Java 面试题整理

基础篇

1、 Java 语言有哪些特点

1、简单易学、有丰富的类库

2、面向对象( Java 最重要的特性,让程序耦合度更低,内聚性更高)

3、与平台无关性( JVM 是 Java 跨平台使用的根本)

4、可靠安全

5、支持多线程

2、面向对象和面向过程的区别

面向过程:是分析解决问题的步骤,然后用函数把这些步骤一步一步地实现,然后在使用的时候一一调用则可。性能较高,所以单片机、嵌入式开发等一般采用面向过程开发

面向对象:是把构成问题的事务分解成各个对象,而建立对象的目的也不是为了完成一个个步骤,而是为了描述某个事物在解决整个问题的过程中所发生的行为。面向对象有 封装、继承、多态 的特性,所以易维护、易复用、易扩展。可以设计出低耦合的系统。 但是性能上来说,比面向过程要低。

3 、八种基本数据类型的大小,以及他们的封装类

| 基本类型 | 大小(字节) | 默认值 | 封装类 |

|---|---|---|---|

| byte | 1 | ( byte )0 | Byte |

| short | 2 | ( short )0 | Short |

| int | 4 | 0 | Integer |

| long | 8 | 0 L | Long |

| float | 4 | 0.0 f | Float |

| double | 8 | 0.0 d | Double |

| boolean | - | false | Boolean |

| char | 2 | \u0000( null ) | Character |

注:

int 是基本数据类型,Integer 是 int 的封装类,是引用类型。int 默认值是0,而 Integer 默认值是null,所以Integer能区分出0和null的情况。一旦java看到null,就知道这个引用还没有指向某个对象,再任何引用使用前,必须为其指定一个对象,否则会报错。

基本数据类型在声明时系统会自动给它分配空间,而引用类型声明时只是分配了引用空间,必须通过实例化开辟数据空间之后才可以赋值。数组对象也是一个引用对象,将一个数组赋值给另一个数组时只是复制了一个引用,所以通过某一个数组所做的修改在另一个数组中也看的见。

虽然定义了 boolean 这种数据类型,但是只对它提供了非常有限的支持。在 Java 虚拟机中没有任何供 boolean 值专用的字节码指令,Java 语言表达式所操作的 boolean 值,在编译之后都使用 Java 虚拟机中的 int 数据类型来代替,而 boolean 数组将会被编码成 Java 虚拟机的 byte 数组,每个元素 boolean 元素占 8 位。这样我们可以得出 boolean 类型占了单独使用是 4 个字节,在数组中又是 1 个字

节。使用 int 的原因是,对于当下 32 位的处理器( CPU )来说,一次处理数据是 32 位(这里不是指的是 32 / 64 位系统,而是指 CPU 硬件层面),具有高效存取的特点。

4、标识符的命名规则

标识符的含义: 是指在程序中,我们自己定义的内容,譬如,类的名字,方法名称以及变量名称等等,都是标识符。

命名规则:(硬性要求) 标识符可以包含英文字母,0 - 9 的数字,$ 以及_ 标识符不能以数字开头 标识符不是关键字

命名规范:(非硬性要求) 类名规范:首字符大写,后面每个单词首字母大写(大驼峰式)。 变量名规范:首字母小写,后面每个单词首字母大写(小驼峰式)。 方法名规范:同变量名。

5、instanceof 关键字的作用

instanceof 严格来说是 Java 中的一个双目运算符,用来测试一个对象是否为一个类的实例,用法为:

1 | boolean result = obj instanceof Class |

其中 obj 为一个对象,Class 表示一个类或者一个接口,当 obj 为 Class 的对象,或者是其直接或间接子类,或者是其接口的实现类,结果 result 都返回 true,否则返回 false 。

注意:编译器会检查 obj 是否能转换成右边的 class 类型,如果不能转换则直接报错,如果不能确定类型,则通过编译,具体看运行时定。

1 | int i = 0; |

1 | Integer integer = new Integer(1); |

1 | //false ,在 JavaSE 规范 中对 instanceof 运算符的规定就是:如果 obj 为 null,那么将返回 false。 |

6、Java 自动装箱与拆箱

装箱就是自动将基本数据类型转换为包装器类型( int –> Integer ),调用方法:Integer 的 valueOf (int) 方法

拆箱就是自动将包装器类型转换为基本数据类型( Integer –> int),调用方法:Integer 的 intValue 方法

在 Java SE5 之前,如果要生成一个数值为 10 的 Integer 对象,必须这样进行:

1 | Integer i = new Integer(10); |

而在从 Java SE5 开始就提供了自动装箱的特性,如果要生成一个数值为 10 的 Integer 对象,只需要这样就可以了:

1 | Integer i = 10; |

面试题 1 : 以下代码会输出什么?

1 | public class Main { |

运行结果:

1 | true |

为什么会出现这样的结果?输出结果表明 i1 和 i2 指向的是同一个对象,而 i3 和 i4 指向的是不同的对

象。此时只需一看源码便知究竟,下面这段代码是 Integer 的 valueOf 方法的具体实现:

1 | public static Integer valueOf(int i) { |

其中 IntegerCache 类的实现为:

1 | private static class IntegerCache { |

从这2段代码可以看出,在通过 valueOf 方法创建 Integer 对象的时候,如果数值在 [-128,127] 之间,便返回指向 IntegerCache.cache 中已经存在的对象的引用;否则创建一个新的 Integer 对象。

上面的代码中 i1 和 i2 的数值为 100 ,因此会直接从 cache 中取已经存在的对象,所以 i1 和 i2 指向的是同一个对象,而 i3 和 i4 则是分别指向不同的对象。

面试题 2 :以下代码输出什么运行结果:

1 | public class Main { |

运行结果:

1 | false |

原因: 在某个范围内的整型数值的个数是有限的,而浮点数却不是。

7、 重载和重写的区别

重写 (Override)

从字面上看,重写就是重新写一遍的意思。其实就是在子类中把父类本身有的方法重新写一遍。子类继承了父类原有的方法,但有时子类并不想原封不动的继承父类中的某个方法,所以在方法名,参数列表,返回类型(除过子类中方法的返回值是父类中方法返回值的子类时)都相同的情况下, 对方法体进行修改或重写,这就是重写。但要注意子类函数的访问修饰权限不能少于父类的。

1 | public class Father { |

重写 总结: 1.发生在父类与子类之间 2.方法名,参数列表,返回类型(除过子类中方法的返回类型是父类中返回类型的子类)必须相同 3.访问修饰符的限制一定要大于被重写方法的访问修饰符( public > protected > default > private ) 4.重写方法一定不能抛出新的检查异常或者比被重写方法申明更加宽泛的检查型异常

重载( Overload )

在一个类中,同名的方法如果有不同的参数列表(参数类型不同、参数个数不同甚至是参数顺序不同)则视为重载。同时,重载对返回类型没有要求,可以相同也可以不同,但不能通过返回类型是否相同来判断重载。

1 | public class Father { |

重载 总结: 1.重载 Overload 是一个类中多态性的一种表现 2.重载要求同名方法的参数列表不同(参数类型,参数个数甚至是参数顺序) 3.重载的时候,返回值类型可以相同也可以不相同。无法以返回型别作为重载函数的区分标准

8、equals 与 == 的区别

== :

== 比较的是变量(栈)内存中存放的对象的(堆)内存地址,用来判断两个对象的地址是否相同,即是否是指相同一个对象。比较的是真正意义上的指针操作。

1、比较的是操作符两端的操作数是否是同一个对象。 2、两边的操作数必须是同一类型的(可以是父子类之间)才能编译通过。 3、比较的是地址,如果是具体的阿拉伯数字的比较,值相等则为 true,如: int a = 10 与 long b = 10 L 与 double c = 10.0 都是相同的(为true),因为他们都指向地址为 10 的堆。

equals:

equals用来比较的是两个对象的内容是否相等,由于所有的类都是继承自 java.lang.Object 类的,所以适用于所有对象,如果没有对该方法进行覆盖的话,调用的仍然是 Object 类中的方法,而 Object 中的 equals 方法返回的却是 == 的判断。

总结:

所有比较是否相等时,都是用 equals 并且在对常量相比较时,把常量写在前面,因为使用 object 的 equals object 可能为 null 则空指针

在阿里的代码规范中只使用 equals,阿里插件默认会识别,并可以快速修改,推荐安装阿里插件来排查老代码使用 “==” ,替换成 equals

9、Hashcode 的作用

java 的集合有两类,一类是 List ,还有一类是 Set 。前者有序可重复,后者无序不重复。当我们在 set 中插入的时候怎么判断是否已经存在该元素呢,可以通过 equals 方法。但是如果元素太多,用这样的方法就会比较满。

于是有人发明了哈希算法来提高集合中查找元素的效率。 这种方式将集合分成若干个存储区域,每个对象可以计算出一个哈希码,可以将哈希码分组,每组分别对应某个存储区域,根据一个对象的哈希码就可以确定该对象应该存储的那个区域。

hashCode 方法可以这样理解:它返回的就是根据对象的内存地址换算出的一个值。这样一来,当集合要添加新的元素时,先调用这个元素的 hashCode 方法,就一下子能定位到它应该放置的物理位置上。如果这个位置上没有元素,它就可以直接存储在这个位置上,不用再进行任何比较了;如果这个位置上已经有元素了,就调用它的 equals 方法与新元素进行比较,相同的话就不存了,不相同就散列其它的地址。这样一来实际调用 equals 方法的次数就大大降低了,几乎只需要一两次。

10、String、StringBuffer 和 StringBuilder 的区别是什么?

String 是只读字符串,它并不是基本数据类型,而是一个对象。从底层源码来看是一个 final 类型的字符数组,所引用的字符串不能被改变,一经定义,无法再增删改。每次对 String 的操作都会生成新的 String 对象。

1 | private final char value[];//dk1.8 及以前 String 底层使用的是 char 数组 |

jdk1.8 及以前 String 底层使用的是 char 数组,jdk 1.9 及以后使用的是 byte 数组。

每次 + 操作 : 隐式在堆上 new 了一个跟原字符串相同的 StringBuilder 对象,再调用 append 方法拼接 + 后面的字符。

StringBuffer 和 StringBuilder 他们两都继承了 AbstractStringBuilder 抽象类,从 AbstractStringBuilder 抽象类中我们可以看到

1 | /** |

他们的底层都是可变的字符数组,所以在进行频繁的字符串操作时,建议使用 StringBuffer 和 StringBuilder 来进行操作。 另外StringBuffer 对方法加了同步锁或者对调用的方法加了同步锁,所以是线程安全的。StringBuilder 并没有对方法进行加同步锁,所以是非线程安全的。

11、ArrayList 和 linkedList 的区别

ArrayList

优点:ArrayList 是实现了基于动态数组的数据结构,因为地址连续,一旦数据存储好了,查询操作效率会比较高(在内存里是连着放的)。

缺点:因为地址连续,ArrayList 要移动数据,所以插入和删除操作效率比较低。

LinkedList

优点:LinkedList 基于链表的数据结构,地址是任意的,所以在开辟内存空间的时候不需要等一个连续的地址。对于新增和删除操作,LinkedList 比较占优势。LinkedList 适用于要头尾操作或插入指定位置的场景。

缺点:因为 LinkedList 要移动指针,所以查询操作性能比较低。

适用场景分析

当需要对数据进行对随机访问的时候,选用 ArrayList。

当需要对数据进行多次增加删除修改时,采用 LinkedList。

如果容量固定,并且只会添加到尾部,不会引起扩容,优先采用 ArrayList。

当然,绝大数业务的场景下,使用 ArrayList 就够了,但需要注意避免 ArrayList 的扩容,以及非顺序的插入。

Array (数组)是基于索引(index)的数据结构,它使用索引在数组中搜索和读取数据是很快的。

Array 获取数据的时间复杂度是 O ( 1 ) ,但是要删除数据却是开销很大,因为这需要重排数组中的所有数据(因为删除数据以后, 需要把后面所有的数据前移)

缺点:数组初始化必须指定初始化的长度, 否则报错

例如:

1 | int[] a = new int[4];//推介使用int[] 这种方式初始化 |

List 是一个有序的集合,可以包含重复的元素,提供了按索引访问的方式,它继承 Collection。

List有两个重要的实现类:ArrayList 和 LinkedList

ArrayList: 可以看作是能够自动增长容量的数组

ArrayList 的 toArray 方法返回一个数组

ArrayList 的 asList 方法返回一个列表

ArrayList底层的实现是 Array, 数组扩容实现

LinkList 是一个双链表 ,在添加和删除元素时具有比 ArrayList 更好的性能;但在 get 与 set 方面弱于ArrayList。当然,这些对比都是指数据量很大或者操作很频繁。

12、HashMap 和 HashTable 的区别

HashTable 是 java 一开始发布时就提供的键值映射的数据结构,而 HashMap 产生于 JDK 1.2。虽然 HashTable 比 HashMap 出现的早一些,但是现在 HashTable 基本上已经被弃用了。而 HashMap 已经成为应用最为广泛的一种数据类型了。

1、两者父类不同

HashMap 是继承自 AbstractMap 类,而 HashTable 是继承自 Dictionary 类。不过它们同时实现了 map、Cloneable(可复制)、Serializable(可序列化)这三个接口。

2、对外提供的接口不同

HashTable 比 HashMap 多提供了 elments() 和 contains() 两个方法。elments() 方法继承自 HashTable 的父类 Dictionnary。elements() 方法用于返回此 HashTable 中的 value 的枚举。

contains() 方法判断该 HashTable 是否包含传入的 value。它的作用与 containsValue() 一致。事实上,contansValue() 就只是调用了一下 contains() 方法。

3、对 null 的支持不同

Hashtable:key 和 value 都不能为 null。

HashMap:key 可以为 null,但是这样的 key 只能有一个,因为必须保证 key 的唯一性;可以有多个 key 值对应的 value 为 null。

4、安全性不同

HashMap 是线程不安全的,在多线程并发的环境下,可能会产生死锁等问题,因此需要开发人员自己处理多线程的安全问题。

Hashtable 是线程安全的,它的每个方法上都有 synchronized 关键字,因此可直接用于多线程中。

虽然 HashMap 是线程不安全的,但是它的效率远远高于 Hashtable,这样设计是合理的,因为大部分的使用场景都是单线程。当需要多线程操作的时候可以使用线程安全的 ConcurrentHashMap 。

ConcurrentHashMap 虽然也是线程安全的,但是它的效率比Hashtable要高好多倍。因为 ConcurrentHashMap 使用了分段锁,并不对整个数据进行锁定。

第二种答案:

出生的版本不一样,Hashtable 出生于 Java 发布的第一版本 JDK 1.0,HashMap 出生于 JDK 1.2。

都实现了 Map、Cloneable、Serializable( 当前 JDK 版本 1.8 )。

HashMap 继承的是 AbstractMap,并且 AbstractMap 也实现了 Map 接口。Hashtable 继承 Dictionary。

Hashtable 中大部分 public 修饰普通方法都是 synchronized 字段修饰的,是线程安全的,HashMap 是非线程安全的。

Hashtable 的 key 不能为 null,value 也不能为 null,这个可以从 Hashtable 源码中的 put 方法看到,判断如果 value 为 null 就直接抛出空指针异常,在 put 方法中计算 key 的 hash 值之前并没有判断 key 为 null 的情况,那说明,这时候如果 key 为空,照样会抛出空指针异常。

HashMap 的 key 和 value 都可以为 null。在计算 hash 值的时候,有判断,如果 key==null ,则其 hash=0 ;至于 value 是否为 null,根本没有判断过。

Hashtable 直接使用对象的 hash 值。hash 值是 JDK 根据对象的地址或者字符串或者数字算出来的 int 类型的数值。然后再使用除留余数法来获得最终的位置。然而除法运算是非常耗费时间的,效率很低。HashMap 为了提高计算效率,将哈希表的大小固定为了 2 的幂,这样在取模预算时,不需要做除法,只需要做位运算。位运算比除法的效率要高很多。

Hashtable、HashMap 都使用了 Iterator。而由于历史原因,Hashtable 还使用了 Enumeration 的方式。

默认情况下,初始容量不同,Hashtable 的初始长度是 11,之后每次扩充容量变为之前的 2n+1(n 为上一次的长度)而 HashMap 的初始长度为 16,之后每次扩充变为原来的两倍。

另外在 Hashtable 源码注释中有这么一句话:

1

2

3Hashtable is synchronized. If a thread-safe implementation is not needed, it is

recommended to use HashMap in place of Hashtable . If a thread-safe highlyconcurrent implementation is desired, then it is recommended to use

ConcurrentHashMap in place of Hashtable.

大致意思:Hashtable 是线程安全,推荐使用 HashMap 代替 Hashtable;如果需要线程安全高并发的话,推荐使用 ConcurrentHashMap 代替 Hashtable。

这个回答完了,面试官可能会继续问:HashMap 是线程不安全的,那么在需要线程安全的情况下还要考虑性能,有什么解决方式?

这里最好的选择就是 ConcurrentHashMap 了,但面试官肯定会叫你继续说一下 ConcurrentHashMap 数据结构以及底层原理等。

拓展:什么是分段锁?

ConcurrentHashMap 中的分段锁称为 Segment,它的内部结构是维护一个 HashEntry 数组,同时 Segment 还继承了 ReentrantLock。

当需要 put 元素的时候,并不是对整个 ConcurrentHashMap 进行加锁,而是先通过 hashcode 来判断它放在哪一个分段中,然后对该分段进行加锁。所以当多线程 put 的时候,只要不是放在同一个分段中,就可以实现并行的插入。分段锁的设计目的就是为了细化锁的粒度,从而提高并发能力。

jdk 1.8 中的 ConcurrentHashMap 中废弃了 Segment 锁,直接使用了数组元素,数组中的每个元素都可以作为一个锁。在元素中没有值的情况下,可以直接通过 CAS 操作来设值,同时保证并发安全;如果元素里面已经存在值的话,那么就使用 synchronized 关键字对元素加锁,再进行之后的 hash 冲突处理。jdk1.8 的 ConcurrentHashMap 加锁粒度比 jdk 1.7 里的 Segment 来加锁粒度更细,并发性能更好。

5、初始容量大小和每次扩充容量大小不同

HashMap 的初始容量为:16,Hashtable 初始容量为:11,两者的负载因子默认都是:0.75

- HashMap 每次扩充,容量变为原来的 2 倍( 2 n );

- HashTable 每次扩充,容量会变为原来的 2 倍 + 1( 2 n + 1 );

下面给出 HashMap 中的源码:

1 | /** |

拓展:什么是负载因子?

负载因子 loadFactor = 哈希表的有效元素个数 / 哈希表长度

这个值越大就说明冲突越严重一些

这个值越小说明冲突越小,数组利用率越低

扩容:采用整表扩容的方式什么时候需要对数组扩容?

扩容与否就根据负载因子来决定,当数组长度 * 负载因子 <= 有效元素个数就需要扩容

HashMap中的源码:

1 | /** |

6、计算 hash 值的方法不同

为了得到元素的位置,首先需要根据元素的 KEY 计算出一个 hash 值,然后再用这个 hash 值来计算得到最终的位置。

Hashtable 中 hash 的计算方法为:直接使用对象的 hashCode()。

HashMap 中 hash 的计算方法为:key 的 hash 值高 16 位不变,低 16 位与高 16 位异或作为 key 最终的 hash 值。(h>>>16,表示无符号右移 16 位,高位补 0 )

HashTable:

1 | /** |

HashMap:

1 | /** |

拓展:什么是hashCode?

hashCode 是 JDK 根据对象的地址或者字符串或者数字算出来的 int 类型的数值。

两者为啥 hash 算法不一样?

Hashtable 在计算元素的位置时使用除留余数法来获得存储的最终的位置,而除法运算是比较耗时的。

HashMap 为了提高计算效率,将哈希表的大小固定为了 2 的倍数,这样在取模运算时,不需要做除法,只需要做位运算(左移一位就是乘以 2 )。位运算比除法的效率要高很多。

HashMap 的效率虽然提高了,但是 hash 冲突却也增加了。因为它得出的 hash 值的低位相同的概率比较高。

为了解决这个问题,HashMap 重新根据 hashcode 计算 hash 值后,又将 hash 值无符号右移 16 位,使得运算出来所取得的位置分散到高低位中,从而减少了 hash 冲突。HashMap 中采取的这种简单位运算操作,不会把使用 2 的幂次方带来的效率提升给抵消掉。

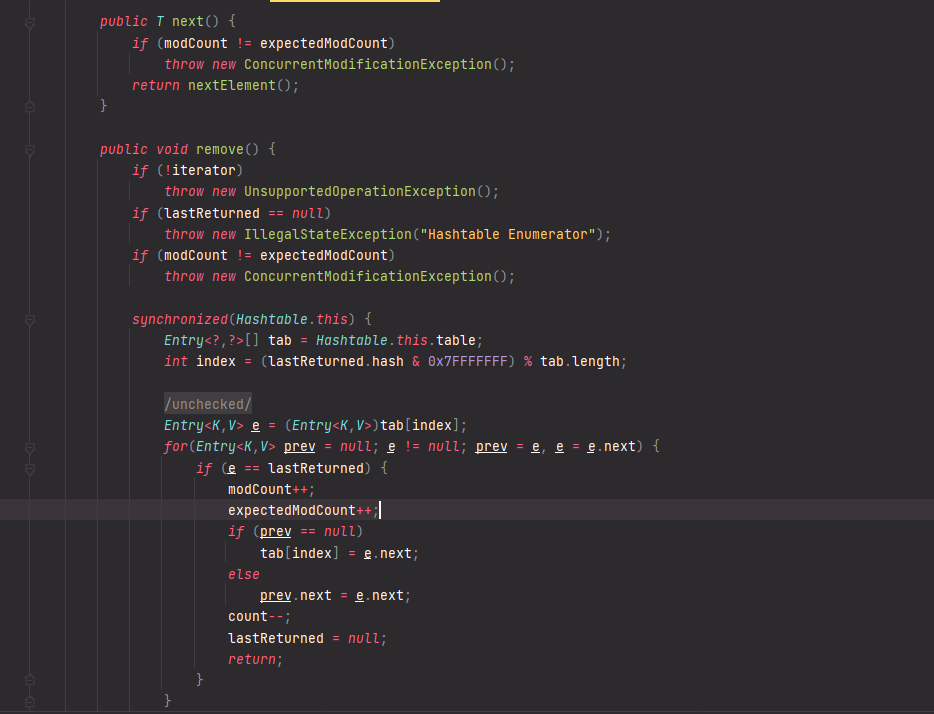

7. 迭代器内部实现不同

Hashtable、HashMap 都使用了 Iterator。Hashtable 还使用了 Enumeration 的方式 。

Hashtable中 的 Enumerator 类,实现了 Enumeration 接口和 Iterator 接口:

1 | /** |

HashMap 中的 Iterator :

1 | /* ------------------------------------------------------------ */ |

拓展:JDK 8 之后,HashMap 和 Hashtable 的 Iterator 都有 fast-fail 机制。

当有其它线程修改了 HashMap 的结构时,将会抛出 ConcurrentModificationException 异常。

注:结构修改是指改变 HashMap 中的映射数量或以其他方式修改其内部结构 (如,重新哈希,增加,删除,修改元素)。

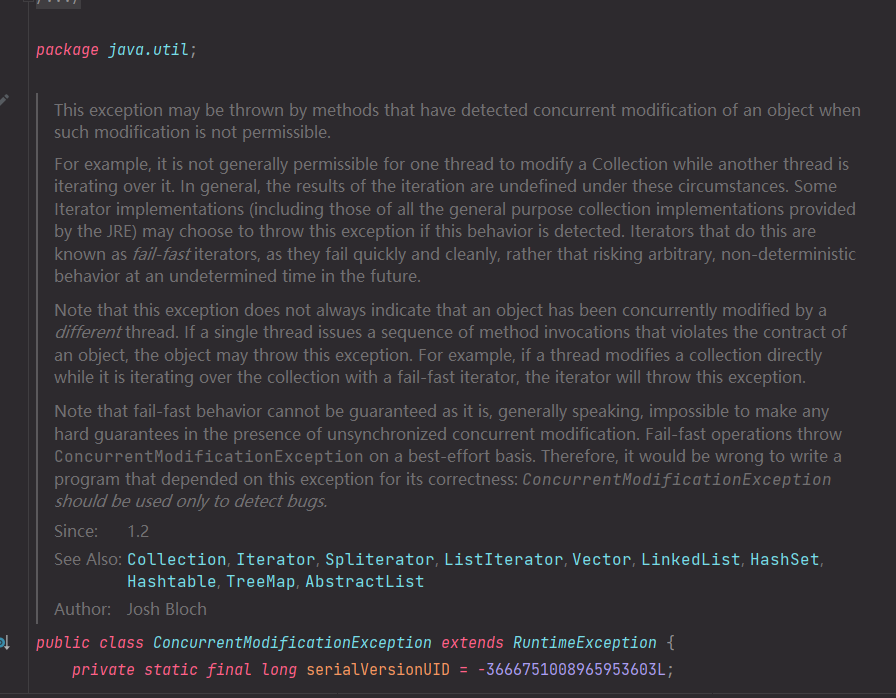

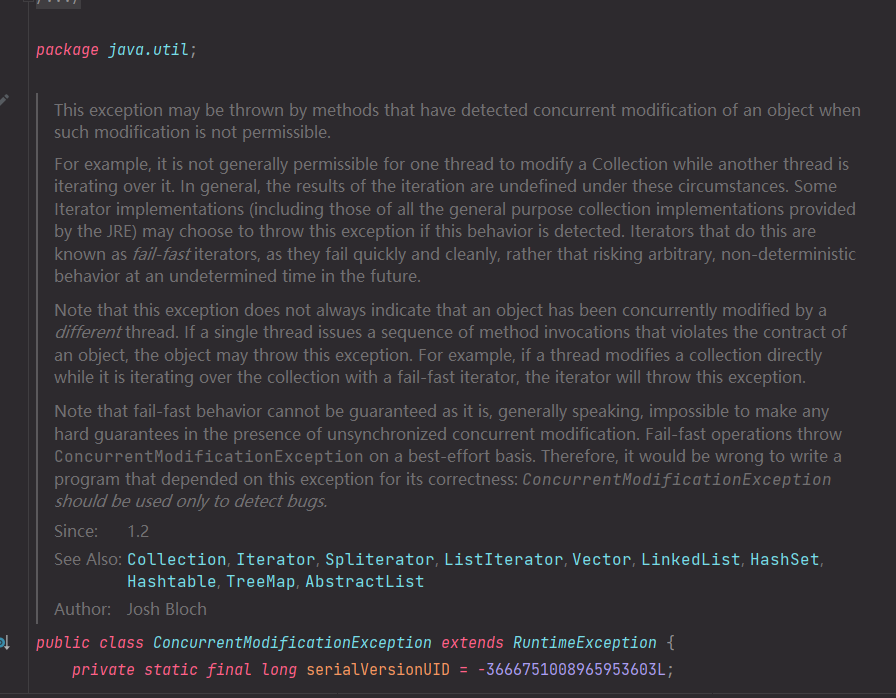

什么是 fast-fail 机制?

例如,通常不允许一个线程在另一个线程迭代 Collection 时修改它。

通常,迭代的结果在这些情况下是没有定义的。如果检测到此行为,一些 Iterator 实现(包括JRE提供的所有通用集合实现)可能会选择抛出此异常。这样做的迭代器被称为快速失败迭代器,因为它们快速而干净地失败,而不是冒着在未来不确定的时间发生任意、不确定行为的风险。

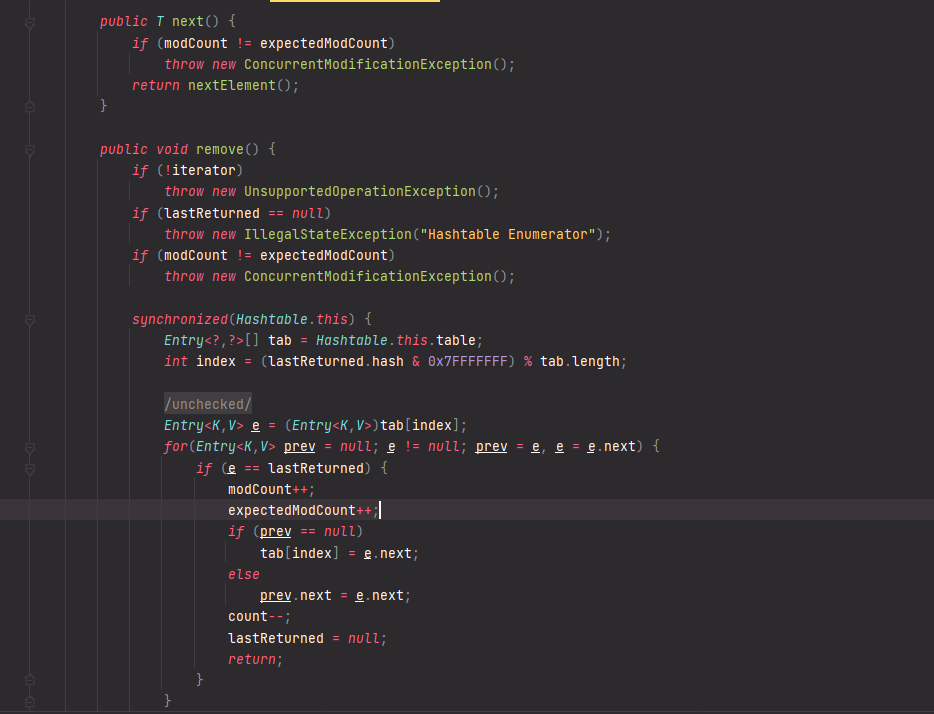

迭代器中的 modCount 变量,类似于并发编程中的 CAS(Compare and Swap)技术。我们可以看到这个方法中,每次在发生增删改的时候都会出现 modCount++ 的动作。

而 modcount 可以理解为是当前 hashtable 的状态。每发生一次操作,状态就向前走一步。设置这个状态,主要是由于 hashtable 等容器类在迭代时,判断数据是否过时时使用的。尽管 hashtable 采用了原生的同步锁来保护数据安全。但是在出现迭代数据的时候,则无法保证边迭代,边正确操作。于是使用这个值来标记状态。一旦在迭代的过程中状态发生了改变,则会快速抛出一个异常,终止迭代行为。

13、 Collection 包结构与 Collections 的区别

Collection 是集合类的上级接口,子接口有 Set、List、LinkedList、ArrayList、Vector、Stack、Set;

Collections 是集合类的一个帮助类, 它包含有各种有关集合操作的静态多态方法,用于实现对各种集合的搜索、排序、线程安全化等操作。此类不能实例化,就像一个工具类,服务于 Java 的 Collection 框架。

14、 Java 的四种引用,强弱软虚

1、强引用

强引用是平常中使用最多的引用,强引用在程序内存不足(OOM)的时候也不会被回收,使用方式:

1 | String str = new String("str"); |

2、软引用

软引用在程序内存不足时,会被回收,使用方式:

1 | // 注意:wrf 这个引用也是强引用,它是指向 SoftReference 这个对象的, |

可用场景: 创建缓存的时候,创建的对象放进缓存中,当内存不足时,JVM 就会回收早先创建的对象。

3、弱引用

弱引用就是只要 JVM 垃圾回收器发现了它,就会将之回收,他的强度比软引用更低一点,弱引用的对象下一次 GC 的时候一定会被回收,而不管内存是否足够。使用方式:

1 | WeakReference<String> wrf = new WeakReference<String>(str); |

可用场景: Java 源码中的 java.util.WeakHashMap 中的 key 就是使用弱引用,我的理解就是,一旦我不需要某个引用,JVM 会自动帮我处理它,这样我就不需要做其它操作。

4、虚引用

虚引用的回收机制跟弱引用差不多,但是它被回收之前,会被放入 ReferenceQueue 中。注意哦,其它引用是被 JVM 回收后才被传入 ReferenceQueue 中的。由于这个机制,所以虚引用大多被用于引用销毁前的处理工作。还有就是,虚引用创建的时候,必须带有 ReferenceQueue ,同样的当发生GC的时候,虚引用也会被回收。可以用虚引用来管理堆外内存

使用例子:

1 | PhantomReference<String> prf = new PhantomReference<String>(new String("str"), |

可用场景: 对象销毁前的一些操作,比如说资源释放等。 Object.finalize() 虽然也可以做这类动作,但是这个方式即不安全又低效

上诉所说的几类引用,都是指对象本身的引用,而不是指 Reference 的四个子类的引用( SoftReference 等)。

15、 泛型常用特点

泛型是 Java SE 1.5 之后的特性, 《Java 核心技术》中对泛型的定义是:

“泛型” 意味着编写的代码可以被不同类型的对象所重用。

“泛型”,顾名思义,“泛指的类型”。我们提供了泛指的概念,但具体执行的时候却可以有具体的规则来约束,比如我们用的非常多的ArrayList 就是个泛型类,ArrayList作为集合可以存放各种元素,如 Integer, String,自定义的各种类型等,但在我们使用的时候通过具体的规则来约束,如我们可以约束集合中只存放Integer类型的元素,如

1 | List<Integer> iniData = new ArrayList<>() |

使用泛型的好处?

以集合来举例,使用泛型的好处是我们不必因为添加元素类型的不同而定义不同类型的集合,如整型集合类,浮点型集合类,字符串集合类,我们可以定义一个集合来存放整型、浮点型,字符串型数据,而这并不是最重要的,因为我们只要把底层存储设置了 Object 即可,添加的数据全部都可向上转型为 Object。 更重要的是我们可以通过规则按照自己的想法控制存储的数据类型。

16、 Java 创建对象有几种方式?

1、new 关键字

使用 new 关键字创建对象,这是我们最常见的也是最简单的创建对象的方式,通过这种方式我们还可以调用任意的构造器(无参的和有参的)。

1 | ClassName myClass = new ClassName(); |

注意:

当我们使用

new创建了一个对象时,会在栈中创建myClass这个引用,并且在堆中开辟一块空间存放对象的值,然后让myClass这个引用指向堆中新建的ClassName对象的值;不管每次创建的对象的值是否相同,每次用

new创建对象时,在栈中创建的引用都是不一样的,即地址都是不一样的。

2、Class.newInstance

这是我们运用 反射 创建对象时最常用的方法。

Class 类的 newInstance 使用的是类的 public 的 无参 构造方法。因此也就是说使用此方法创建对象的前提是必须有 public 的无参构造器才行:

1 | ClassName myClass = ClassName.class.newInstance(); |

3、Constructor.newInstance

该方法和 Class 类的 newInstance 方法很像,但是比它强大很多。

java.lang.relect.Constructor 类里也有一个 newInstance 方法可以创建对象。

我们可以通过这个 newInstance 方法调用 有参数(不再必须是无参)的和 私有的 构造函数(不再必须是 public )。

1 | Constructor<ClassName> constructor = ClassName.class.getConstructor(); |

两种 newInstance 方法的区别

Class类位于java的lang包中,Constructor是java反射机制的一部分Class类的newInstance只能触发 无参数 的构造方法创建对象,Constructor类的newInstance能触发 有参数 或者 任意参数 的构造方法来创建对象。Class类的newInstance需要其构造方法是public的或者对调用方法可见的,Constructor类的newInstance可以在特定环境下调用 私有构造方法 来创建对象。Class类的newInstance抛出类构造函数的异常,Constructor类的newInstance包装了一个InvocationTargetException异常。

4、Clone 方法

无论何时我们调用一个对象的 clone 方法,JVM 就会创建一个新的对象,将前面的对象的内容全部拷贝进去,用 clone 方法创建对象并不会调用任何构造函数。

要使用 clone 方法,我们必须先实现 Cloneable 接口并复写 Object 的 clone 方法(因为 Object 的这个方法是 protected 的,若不复写,外部也调用不了)。

public class ClassName implements Cloneable {

...

// 访问权限写为public,并且返回值写为myclass

@Override

public ClassName clone() throws CloneNotSupportedException {

return (ClassName) super.clone();

}

...

}

public class Main {

public static void main(String[] args) throws Exception {

ClassName myClass = new ClassName();

Object clone = myclass.clone();

//ClassName clone = (ClassName)myClass.clone();

}

}

注意:

clone()方法只会进行 浅复制,也就是说只会在栈中再创建一个引用指向原来的对象的值所处的堆空间中,堆中的对象的值还是原来的并没有重新创建;使用

clone()方法并不需要调用造函数

5、反序列化

要想通过反序列化创建对象,就必须现将某个对象序列化

概念:

1.序列化:将 java 对象转化为字节流或字符流的过程

作用:

(1)便于在网络上进行传输;

(2)将 java 字节序列永久保存在硬盘上,通常放在文件中,所以序列化也可以叫做持久化。

2.反序列化:将字节流或字符流对象转化成 java 对象的过程

1 | /** |

备注:JDK 序列化、反序列化特别特别耗内存。

Java 创建实例对象是不是必须要通过构造函数/构造器/构造方法?

| 创建对象方式 | 是否调用了构造器 |

|---|---|

| new关键字 | 是 |

| Class.newInstance | 是 |

| Constructor.newInstance | 是 |

| Clone | 否 |

| 反序列化 | 否 |

答案:Java 创建实例对象,并不一定必须要调用构造函数/构造器/构造方法的。

17 、有没有可能两个不相等的对象有相同的 hashcode

有可能.在产生 hash 冲突时,两个不相等的对象就会有相同的 hashcode 值。当 hash 冲突产生时,一般有以下几种方式来处理:

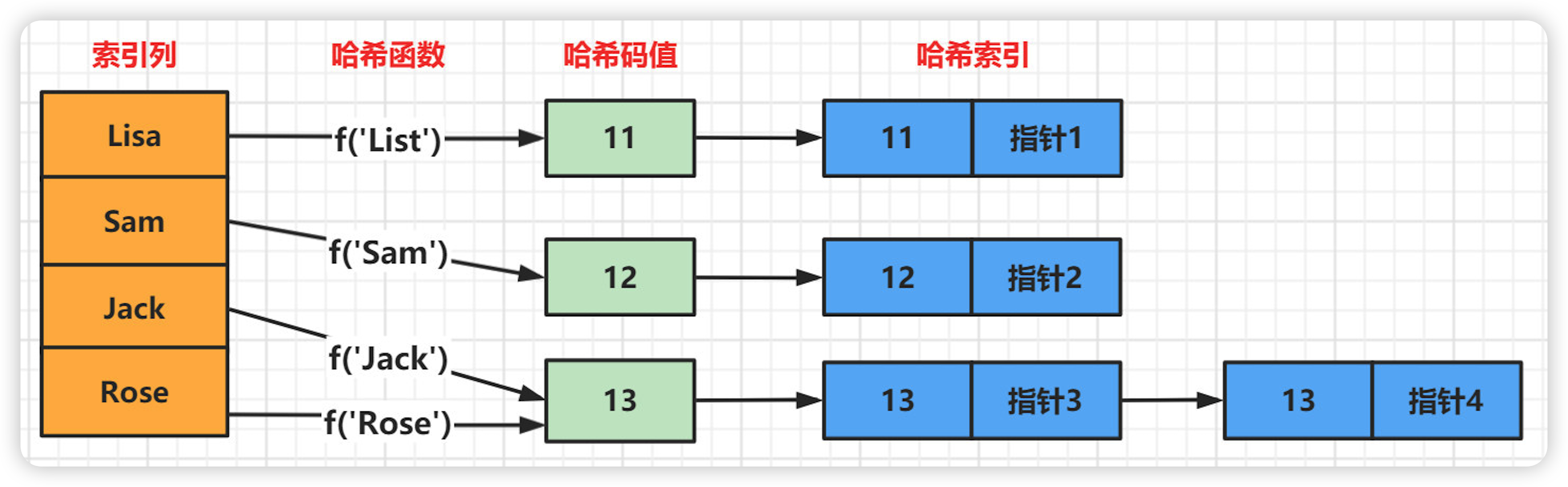

拉链法:每个哈希表节点都有一个 next 指针,多个哈希表节点可以用 next 指针构成一个单向链表,被分配到同一个索引上的多个节点可以用这个单向链表进行存储

开放定址法:一旦发生了冲突,就去寻找下一个空的散列地址,只要散列表足够大,空的散列地址总能找到,并将记录存入

再哈希:又叫双哈希法,有多个不同的 Hash 函数。当发生冲突时,使用第二个,第三个….等哈希函数计算地址,直到无冲突

为什么 java 的指针压缩:

在 Java 中,指针压缩(Pointer Compression)是一种优化技术,用于减少对象指针的内存占用和提高内存访问效率。

在 32 位的 Java 虚拟机中,每个对象引用(指针)通常占用4字节的内存空间。然而,在实际的应用程序中,大部分的堆对象的内存地址范围并不需要使用整个 32 位空间。因此,指针压缩的目标是通过缩小指针的有效位数来减少内存消耗。

指针压缩的具体实现方式是通过将堆对象的内存地址空间划分为几个区域,其中一部分用于存储对象的数据,另一部分用于存储指针。指针压缩将指针的有效位数缩小,从而减少了指针的内存占用。例如,可以将指针大小压缩到3字节或2字节。

指针压缩的好处是可以减少内存消耗,并且在一定程度上提高内存访问效率。较小的指针大小意味着可以在更短的时间内读取或写入指针所指向的对象。此外,指针压缩还可以减少垃圾回收器的工作量,提高垃圾回收的效率。

需要注意的是,指针压缩只在 32 位的 Java 虚拟机中有效,因为在 64 位的虚拟机中,由于地址空间的扩展,指针大小通常为 8 字节,已经足够存储大量的对象引用。

哈希冲突的产生原因及解决方法

哈希冲突的产生

哈希表是根据关键码的值而直接进行访问的数据结构。

哈希法又称散列法、杂凑法以及关键字地址计算法等,相应的表称为哈希表。

哈希表中关键码就是数组的索引下标,然后通过下标直接访问数组中的元素。(哈希表可以用来快速判断一个元素是否出现在集合里)

哈希法法的基本思想是:首先在元素的关键字 k 和元素的存储位置 p 之间建立一个对应关系 f ,使得 p = f ( k ) ,f称为哈希函数。创建哈希表时,把关键字为 k 的元素直接存入地址为 f ( k ) 的单元;以后当查找关键字为 k 的元素时,再利用哈希函数计算出该元素的存储位置p = f ( k ) ,从而达到按关键字直接存取元素的目的。

当关键字集合很大时,关键字值不同的元素可能会映象到哈希表的同一地址上,即 k1 ≠ k2 ,但 H(k1)= H(k2),这种现象称为冲突,此时称 k1 和 k2 为同义词。实际中,冲突是不可避免的,只能通过改进哈希函数的性能来减少冲突。

综上所述,哈希法主要包括以下两方面的内容:

1)如何构造哈希函数

2)如何处理冲突

产生哈希冲突的影响因素

装填因子( 装填因子 = 数据总数 / 哈希表长 )、哈希函数、处理冲突的方法

哈希冲突解决办法

1、开放定址法(再散列法)

基本思想:当关键字 key 的哈希地址 p = H(key)出现冲突时,以 p 为基础,产生另一个哈希地址 p1,如果 p1 仍然冲突,再以 p 为基础,产生另一个哈希地址 p2 ,…,直到找出一个不冲突的哈希地址 pi ,将相应元素存入其中。

(1)线性探测

按顺序决定值时,如果某数据的值已经存在,则在原来值的基础上往后加一个单位,直至不发生哈希冲突。

(2)再平方探测

按顺序决定值时,如果某数据的值已经存在,则在原来值的基础上先加1的平方个单位,若仍然存在则减 1 的平方个单位。随之是 2 的平方,3 的平方等等。直至不发生哈希冲突。

(3)伪随机探测

按顺序决定值时,如果某数据已经存在,通过随机函数随机生成一个数,在原来值的基础上加上随机数,直至不发生哈希冲突。

2、链地址法(拉链法:HashMap 的哈希冲突解决方法)

基本思想:以数组为基本单元,将所有的哈希地址为 i 的元素构成一个称为同义词链的单链表,并将单链表的头指针存在哈希表的第 i 个单元中,因而查找、插入和删除主要在同义词链中进行。

链地址法适用于经常进行插入和删除的情况。

优点:

(1)拉链法处理冲突简单,且无堆积现象,即非同义词决不会发生冲突,因此平均查找长度较短;

(2)由于拉链法中各链表上的结点空间是动态申请的,故它更适合于造表前无法确定表长的情况;

(3)开放定址法为减少冲突,要求装填因子 α 较小,故当结点规模较大时会浪费很多空间。而拉链法中可取 α ≥ 1 ,且结点较大时,拉链法中增加的指针域可忽略不计,因此节省空间;

(4)在用拉链法构造的散列表中,删除结点的操作易于实现。只要简单地删去链表上相应的结点即可。

缺点:

指针占用较大空间时,会造成空间浪费,若空间用于增大散列表规模进而提高开放地址法的效率。

3、再哈希法

基本思想:同时构造多个不同的哈希函数,在发生冲突的时候再用另外一个哈希函数算出哈希值,直到算出的哈希值不同为止。

4、建立公共溢出区

基本思想:将哈希表分为基本表和溢出表两部分,凡是和基本表发生冲突的元素,一律填入溢出表。查表时,先去基本表查,查不到再去溢出区查找。

18、深拷贝和浅拷贝的区别是什么?

浅拷贝:被复制对象的所有变量都含有与原来的对象相同的值,而所有的对其他对象的引用仍然指向原来的对象。换言之,浅拷贝仅仅复制所考虑的对象,而不复制它所引用的对象

深拷贝:被复制对象的所有变量都含有与原来的对象相同的值,而那些引用其他对象的变量将指向被复制过的新对象,而不再是原有的那些被引用的对象。换言之,深拷贝把要复制的对象所引用的对象都复制了一遍

19、final 有哪些用法?

被 final 修饰的类不可以被继承

被 final 修饰的方法不可以被重写

被 final 修饰的变量不可以被改变。如果修饰引用,那么表示引用不可变,引用指向的内容可变

被 final 修饰的方法,JVM 会尝试将其内联,以提高运行效率

被 final 修饰的常量,在编译阶段会存入常量池中

除此之外,编译器对 final 域要遵守的两个重排序规则更好:

在构造函数内对一个 final 域的写入,与随后把这个被构造对象的引用赋值给一个引用变量,这两个操作之间不能重排序,初次读一个包含final域的对象的引用,与随后初次读这个 final 域,这两个操作之间不能重排序.

20、static 都有哪些用法?

所有的人都知道 static 关键字这两个基本的用法:静态变量和静态方法。也就是被 static 所修饰的变量 / 方法都属于类的静态资源,类实例所共享.

除了静态变量和静态方法之外,static 也用于静态块,多用于初始化操作:

1 | public calss PreCache{ |

此外 static 也多用于修饰内部类,此时称之为静态内部类

最后一种用法就是静态导包,即 import static .import static是在 JDK 1.5 之后引入的新特性,可以用来指定导入某个类中的静态资源,并且不需要使用类名,可以直接使用资源名,比如:

1 | import static java.lang.Math.*; |

21、 3 * 0.1 == 0.3 返回值是什么

false,因为有些浮点数不能完全精确的表示出来

22、a = a + b 与 a + = b 有什么区别吗?

+= 操作符会进行隐式自动类型转换,此处 a + = b 隐式的将加操作的结果类型强制转换为持有结果的类型,而 a = a + b 则不会自动进行类型转换。如:

1 | byte a = 127; |

以下代码是否有错,有的话怎么改?

1 | short s1= 1; |

有错误。short 类型在进行运算时会自动提升为 int 类型,也就是说 s1 + 1 的运算结果是 int 类型而 s1 是 short 类型,此时编译器会报错

正确写法:

1 | short s1= 1; |

+= 操作符会对右边的表达式结果强转匹配左边的数据类型,所以没错

23、try catch finally,try 里有 return ,finally 还执行么?

执行,并且 finally 的执行早于 try 里面的 return。如果 finally 块中存在 return 语句,它会覆盖 try 块或 catch 块中的 return 语句,并成为最终的返回值。

结论:

1、不管有木有出现异常,finally 块中代码都会执行;

2、当 try 和 catch 中有 return 时,finally 仍然会执行;

3、finally 是在 return 后面的表达式运算后执行的(此时并没有返回运算后的值,而是先把要返回的值保存起来,管 finally 中的代码怎么样,返回的值都不会改变,仍然是之前保存的值),所以函数返回值是在 finally 执行前确定的;

4、finally 中最好不要包含 return,否则程序会提前退出,返回值不是 try 或 catch 中保存的返回值。

24、Excption 与 Error 包结构

Java 可抛出 ( Throwable ) 的结构分为三种类型:被检查的异常 ( CheckedException ),运行时异常 (RuntimeException ),错误( Error )

1、运行时异常

定义:RuntimeException 及其子类都被称为运行时异常。

特点:Java 编译器不会检查它。也就是说,当程序中可能出现这类异常时,倘若既”没有通过 throws 声明抛出它”,也”没有用 try-catch语句捕获它”,还是会编译通过。例如,除数为零时产生的 ArithmeticException 异常,数组越界时产生的 IndexOutOfBoundsException异常,fail - fast 机制产生的 ConcurrentModificationException 异常(java.util 包下面的所有的集合类都是快速失败的,“快速失败”也就是 fail-fast,它是 Java 集合的一种错误检测机制。当多个线程对集合进行结构上的改变的操作时,有可能会产生fail-fast机制。记住是有可能,而不是一定。例如:假设存在两个线程(线程1、线程2),线程 1 通过 Iterator 在遍历集合 A 中的元素,在某个时候线程 2 修改了集合 A 的结构(是结构上面的修改,而不是简单的修改集合元素的内容),那么这个时候程序就会抛出ConcurrentModificationException 异常,从而产生 fail-fast 机制,这个错叫并发修改异常。Failsafe,java.util.concurrent 包下面的所有的类都是安全失败的,在遍历过程中,如果已经遍历的数组上的内容变化了,迭代器不会抛出 ConcurrentModificationException 异常。如果未遍历的数组上的内容发生了变化,则有可能反映到迭代过程中。这就是 ConcurrentHashMap 迭代器弱一致的表现。ConcurrentHashMap 的弱一致性主要是为了提升效率,是一致性与效率之间的一种权衡。要成为强一致性,就得到处使用锁,甚至是全局锁,这就与 Hashtable 和同步的 HashMap 一样了。)等,都属于运行时异常。

常见的五种运行时异常:

ClassCastException(类转换异常)

IndexOutOfBoundsException(数组越界)

NullPointerException(空指针异常)

ArrayStoreException(数据存储异常,操作数组是类型不一致)

BufferOverflowException

2、被检查异常

定义:Exception 类本身,以及 Exception 的子类中除了”运行时异常”之外的其它子类都属于被检查异常。

特点:Java 编译器会检查它。 此类异常,要么通过 throws 进行声明抛出,要么通过 try - catch 进行捕获处理,否则不能通过编译。例如,CloneNotSupportedException 就属于被检查异常。当通过 clone() 接口去克隆一个对象,而该对象对应的类没有实现 Cloneable 接口,就会抛出 CloneNotSupportedException 异常。被检查异常通常都是可以恢复的。 如:

IOException

FileNotFoundException

SQLException

被检查的异常适用于那些不是因程序引起的错误情况,比如:读取文件时文件不存在引发的 FileNotFoundException 。然而,不被检查的异常通常都是由于糟糕的编程引起的,比如:在对象引用时没有确保对象非空而引起的 NullPointerException 。

3、错误

定义:Error 类及其子类。

特点:和运行时异常一样,编译器也不会对错误进行检查。

当资源不足、约束失败、或是其它程序无法继续运行的条件发生时,就产生错误。程序本身无法修复这些错误的。例如,VirtualMachineError 就属于错误。出现这种错误会导致程序终止运行。

OutOfMemoryError、ThreadDeath。

Java 虚拟机规范规定 JVM 的内存分为了好几块,比如堆,栈,程序计数器,方法区等

25、OOM 你遇到过哪些情况,SOF 你遇到过哪些情况

OOM:

1、OutOfMemoryError 异常

除了程序计数器外,虚拟机内存的其他几个运行时区域都有发生 OutOfMemoryError ( OOM ) 异常的可能。

Java Heap 溢出:

一般的异常信息:java.lang.OutOfMemoryError:Java heap spacess。

java 堆用于存储对象实例,我们只要不断的创建对象,并且保证 GC Roots 到对象之间有可达路径来避免垃圾回收机制清除这些对象,就会在对象数量达到最大堆容量限制后产生内存溢出异常。

出现这种异常,一般手段是先通过内存映像分析工具 ( 如 Eclipse Memory Analyzer ) 对 dump 出来的堆转存快照进行分析,重点是确认内存中的对象是否是必要的,先分清是因为内存泄漏 ( Memory Leak ) 还是内存溢出 ( Memory Overflow )。

如果是内存泄漏,可进一步通过工具查看泄漏对象到 GCRoots 的引用链。于是就能找到泄漏对象是通过怎样的路径与 GC Roots 相关联并导致垃圾收集器无法自动回收。

如果不存在泄漏,那就应该检查虚拟机的参数 ( -Xmx 与 -Xms ) 的设置是否适当。

2、虚拟机栈和本地方法栈溢出

如果线程请求的栈深度大于虚拟机所允许的最大深度,将抛出 StackOverflowError 异常。

如果虚拟机在扩展栈时无法申请到足够的内存空间,则抛出 OutOfMemoryError异常

这里需要注意当栈的大小越大可分配的线程数就越少。

3、运行时常量池溢出

异常信息:java.lang.OutOfMemoryError:PermGenspace

如果要向运行时常量池中添加内容,最简单的做法就是使用 String.intern() 这个 Native 方法。该方法的作用是:如果池中已经包含一个等于此 String 的字符串,则返回代表池中这个字符串的String对象;否则,将此 String 对象包含的字符串添加到常量池中,并且返回此String 对象的引用。由于常量池分配在方法区内,我们可以通过 -XX:PermSize 和 -XX:MaxPermSize 限制方法区的大小,从而间接限制其中常量池的容量。

4、方法区溢出

方法区用于存放 Class 的相关信息,如类名、访问修饰符、常量池、字段描述、方法描述等。也有可能是方法区中保存的 class 对象没有被及时回收掉或者class信息占用的内存超过了我们配置。

异常信息:java.lang.OutOfMemoryError:PermGenspace

方法区溢出也是一种常见的内存溢出异常,一个类如果要被垃圾收集器回收,判定条件是很苛刻的。在经常动态生成大量 Class 的应用中,要特别注意这点。

SOF(堆栈溢出 StackOverflow):

StackOverflowError 的定义:当应用程序递归太深而发生堆栈溢出时,抛出该错误。

因为栈一般默认为 1 - 2 m,一旦出现死循环或者是大量的递归调用,在不断的压栈过程中,造成栈容量超过 1 m 而导致溢出。

栈溢出的原因:递归调用,大量循环或死循环,全局变量是否过多,数组、List、map数据过大。

26、 简述线程、程序、进程的基本概念。以及他们之间关系是什么?

线程与进程相似,但线程是一个比进程更小的执行单位。一个进程在其执行的过程中可以产生多个线程。与进程不同的是同类的多个线程共享同一块内存空间和一组系统资源,所以系统在产生一个线程,或是在各个线程之间作切换工作时,负担要比进程小得多,也正因为如此,线程也被称为轻量级进程。

程序是含有指令和数据的文件,被存储在磁盘或其他的数据存储设备中,也就是说程序是静态的代码。

进程是程序的一次执行过程,是系统运行程序的基本单位,因此进程是动态的。系统运行一个程序即是一个进程从创建,运行到消亡的过程。简单来说,一个进程就是一个执行中的程序,它在计算机中一个指令接着一个指令地执行着,同时,每个进程还占有某些系统资源如 CPU 时间,内存空间,文件,输入输出设备的使用权等等。换句话说,当程序在执行时,将会被操作系统载入内存中。 线程是进程划分成的更小的运行单位。线程和进程最大的不同在于基本上各进程是独立的,而各线程则不一定,因为同一进程中的线程极有可能会相互影响。从另一角度来说,进程属于操作系统的范畴,主要是同一段时间内,可以同时执行一个以上的程序,而线程则是在同一程序内几乎同时执行一个以上的程序段。

27、Java 序列化中如果有些字段不想进行序列化,怎么办?

对于不想进行序列化的变量,使用 transient 关键字修饰。

transient 关键字的作用是:阻止实例中那些用此关键字修饰的的变量序列化;当对象被反序列化时,被 transient 修饰的变量值不会被持久化和恢复。transient 只能修饰变量,不能修饰类和方法。

28、说说 Java 中 IO 流

Java 中 IO 流分为几种?

按照流的流向分,可以分为输入流和输出流;

按照操作单元划分,可以划分为字节流和字符流;

按照流的角色划分为节点流和处理流。

Java IO 流共涉及 40 多个类,这些类看上去很杂乱,但实际上很有规则,而且彼此之间存在非常紧密的联系, Java IO 流的 40 多个类都是从如下 4 个抽象类基类中派生出来的。

InputStream / Reader:所有的输入流的基类,前者是字节输入流,后者是字符输入流。

OutputStream / Writer:所有输出流的基类,前者是字节输出流,后者是字符输出流。

29、 Java IO 与 NIO 的区别(补充)

NIO 即 New IO,这个库是在 JDK1.4 中才引入的。NIO 和 IO 有相同的作用和目的,但实现方式不同,NIO 主要用到的是块,所以 NIO 的效率要比 IO 高很多。在 Java API 中提供了两套 NIO,一套是针对标准输入输出 NIO,另一套就是网络编程 NIO。

30、java 反射的作用于原理

1、定义:

反射机制是在运行时,对于任意一个类,都能够知道这个类的所有属性和方法;对于任意个对象,都能够调用它的任意一个方法。在 java中,只要给定类的名字,就可以通过反射机制来获得类的所有信息。

这种动态获取的信息以及动态调用对象的方法的功能称为 Java 语言的反射机制。

2、哪里会用到反射机制?

jdbc 就是典型的反射

1 | Class.forName('com.mysql.jdbc.Driver.class');//加载 MySQL 的驱动类 |

这就是反射。如 hibernate,struts 等框架使用反射实现的。

3、反射的实现方式:

第一步:获取 Class 对象,有 4 中方法:

1)Class.forName (“类的路径”);

2)类名.class

3)对象名.getClass()

4)基本类型的包装类,可以调用包装类的 Type 属性来获得该包装类的 Class 对象

4、实现 Java 反射的类:

1)Class:表示正在运行的 Java 应用程序中的类和接口。注意: 所有获取对象的信息都需要 Class 类来实现。

2)Field:提供有关类和接口的属性信息,以及对它的动态访问权限。

3)Constructor:提供关于类的单个构造方法的信息以及它的访问权限

4)Method:提供类或接口中某个方法的信息

5、反射机制的优缺点:

优点:

1)能够运行时动态获取类的实例,提高灵活性

2)与动态编译结合

缺点:

1)使用反射性能较低,需要解析字节码,将内存中的对象进行解析。

解决方案:

1、通过 setAccessible ( true ) 关闭 JDK 的安全检查来提升反射速度;

2、多次创建一个类的实例时,有缓存会快很多

3、ReflectASM 工具类,通过字节码生成的方式加快反射速度

2)相对不安全,破坏了封装性( 因为通过反射可以获得私有方法和属性 )

31、说说 List,Set,Map 三者的区别?

List(对付顺序的好帮手):List 接口存储一组不唯一(可以有多个元素引用相同的对象),有序的对象

Set(注重独一无二的性质):不允许重复的集合。不会有多个元素引用相同的对象。

Map(用 Key 来搜索的专家):使用键值对存储。Map 会维护与 Key 有关联的值。两个 Key 可以引用相同的对象,但 Key 不能重复,典型的 Key 是 String 类型,但也可以是任何对象。

32、Object 有哪些常用方法?

java.lang.Object

clone 方法

保护方法,实现对象的浅复制,只有实现了 Cloneable 接口才可以调用该方法,否则抛出 CloneNotSupportedException 异常,深拷贝也需要实现 Cloneable,同时其成员变量为引用类型的也需要实现 Cloneable,然后重写 clone 方法。

finalize 方法

该方法和垃圾收集器有关系,判断一个对象是否可以被回收的最后一步就是判断是否重写了此方法。

equals 方法

该方法使用频率非常高。一般 equals 和 == 是不一样的,但是在 Object 中两者是一样的。子类一般都要重写这个方法。

hashCode 方法

该方法用于哈希查找,重写了 equals 方法一般都要重写 hashCode 方法,这个方法在一些具有哈希功能的 Collection 中用到。

一般必须满足 obj1.equals(obj2) == true 。可以推出 obj1.hashCode() == obj2.hashCode() ,但是 hashCode 相等不一定就满足 equals。不过为了提高效率,应该尽量使上面两个条件接近等价。

JDK 1.6、1.7 默认是返回随机数;

JDK 1.8 默认是通过和当前线程有关的一个随机数 + 三个确定值,运用 Marsaglia’s xorshift scheme 随机数算法得到的一个随机数。

wait 方法

配合 synchronized 使用,wait 方法就是使当前线程等待该对象的锁,当前线程必须是该对象的拥有者,也就是具有该对象的锁。wait() 方法一直等待,直到获得锁或者被中断。wait ( long timeout ) 设定一个超时间隔,如果在规定时间内没有获得锁就返回。

调用该方法后当前线程进入睡眠状态,直到以下事件发生。

- 其他线程调用了该对象的 notify 方法;

- 其他线程调用了该对象的 notifyAll 方法;

- 其他线程调用了 interrupt 中断该线程;

- 时间间隔到了。

此时该线程就可以被调度了,如果是被中断的话就抛出一个 InterruptedException 异常。

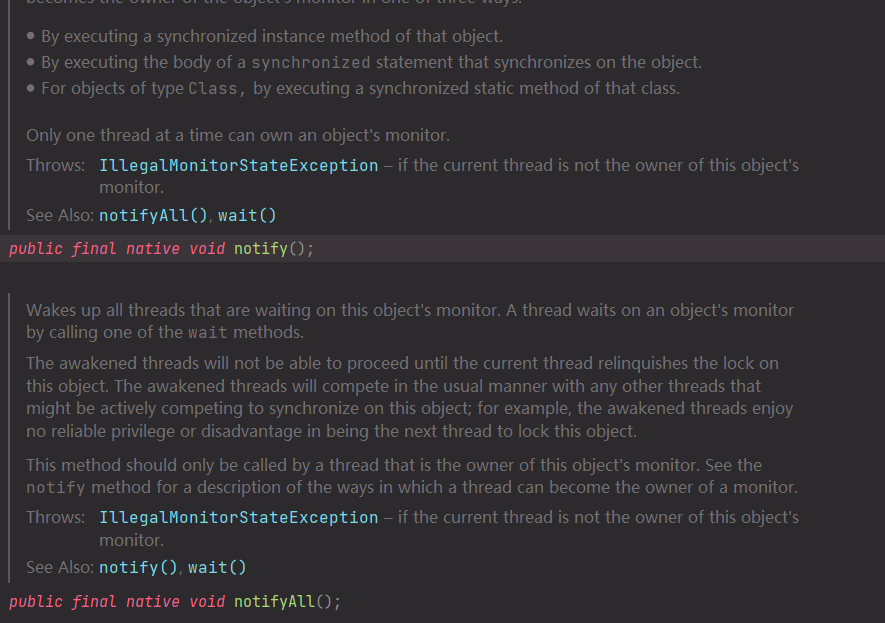

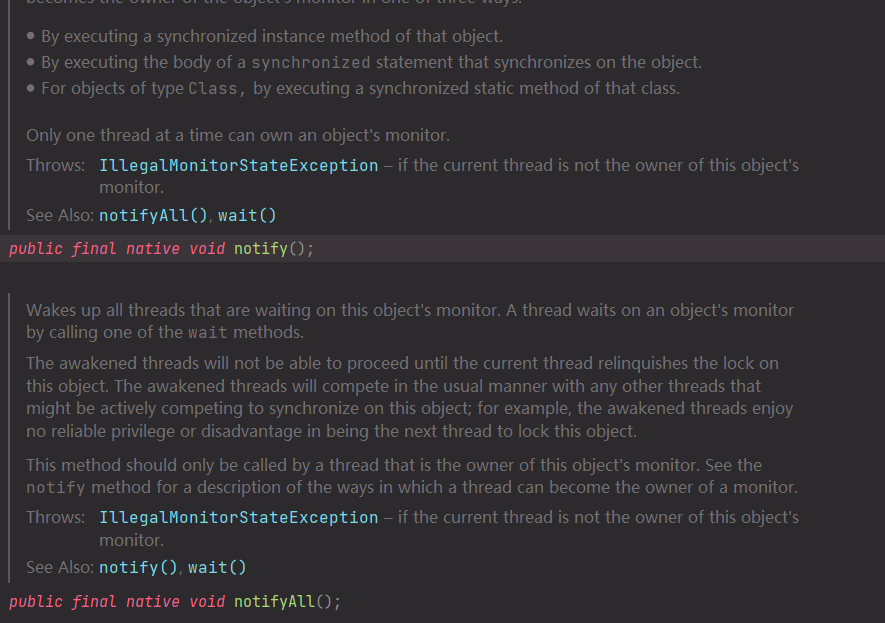

notify 方法

配合 synchronized 使用,该方法唤醒在该对象上等待队列中的某个线程(同步队列中的线程是给抢占 CPU 的线程,等待队列中的线程指的是等待唤醒的线程)。

notifyAll 方法

配合 synchronized 使用,该方法唤醒在该对象上等待队列中的所有线程。

总结

只要把上面几个方法熟悉就可以了,toString 和 getClass 方法可以不用去讨论它们。该题目考察的是对 Object 的熟悉程度,平时用的很多方法并没看其定义但是也在用,比如说:wait() 方法,equals() 方法等。

1 | Class Object is the root of the class hierarchy.Every class has Object as a |

大致意思:Object 是所有类的根,是所有类的父类,所有对象包括数组都实现了 Object 的方法。

33、获取一个类 Class 对象的方式有哪些?

搞清楚类对象和实例对象,但都是对象。

第一种:通过类对象的 getClass() 方法获取,细心点的都知道,这个 getClass 是 Object 类里面的方法。

1 | User user=new User(); |

第二种:通过类的静态成员表示,每个类都有隐含的静态成员 class。

1 | //clazz就是一个User的类对象 |

第三种:通过 Class 类的静态方法 forName() 方法获取。

1 | Class<?> clazz = Class.forName("com.tian.User"); |

34、用过 ArrayList 吗?说一下它有什么特点?

Java 集合框架中的一种存放相同类型的元素数据,是一种变长的集合类,基于定长数组实现,当加入数据达到一定程度后,会实行自动扩容,即扩大数组大小。

底层是使用数组实现,添加元素。

如果 add ( o ) ,添加到的是数组的尾部,如果要增加的数据量很大,应该使用 ensureCapacity() 方法,该方法的作用是预先设置 ArrayList 的大小,这样可以大大提高初始化速度。

如果使用 add ( int , o ) ,添加到某个位置,那么可能会挪动大量的数组元素,并且可能会触发扩容机制。

高并发的情况下,线程不安全。多个线程同时操作 ArrayList,会引发不可预知的异常或错误。

ArrayList 实现了 Cloneable 接口,标识着它可以被复制。注意:ArrayList 里面的 clone() 复制其实是浅复制。

有数组了为什么还要搞个 ArrayList 呢

通常我们在使用的时候,如果在不明确要插入多少数据的情况下,普通数组就很尴尬了,因为你不知道需要初始化数组大小为多少,而 ArrayList 可以使用默认的大小,当元素个数到达一定程度后,会自动扩容。

可以这么来理解:我们常说的数组是定死的数组,ArrayList 却是动态数组

35、说说什么是 fail - fast ?

fail - fast 机制是 Java 集合(Collection)中的一种错误机制。当多个线程对同一个集合的内容进行操作时,就可能会产生 fail - fast 事件。

例如:当某一个线程 A 通过 iterator 去遍历某集合的过程中,若该集合的内容被其他线程所改变了,那么线程 A 访问集合时,就会抛出 ConcurrentModificationException 异常,产生 fail - fast 事件。这里的操作主要是指 add、remove 和 clear,对集合元素个数进行修改。

解决办法:建议使用“ java.util.concurrent 包下的类” 去取代 “ java.util 包下的类”。

可以这么理解:在遍历之前,把 modCount 记下来 expectModCount,后面 expectModCount 去和 modCount 进行比较,如果不相等了,证明已并发了,被修改了,于是抛出 ConcurrentModificationException 异常。

36、HashMap 中的 key 我们可以使用任何类作为 key 吗?

平时可能大家使用的最多的就是使用 String 作为 HashMap 的 key,但是现在我们想使用某个自定义类作为 HashMap 的 key,那就需要注意以下几点:

如果类重写了 equals 方法,它也应该重写 hashCode 方法。

类的所有实例需要遵循与 equals 和 hashCode 相关的规则。

如果一个类没有使用 equals,你不应该在 hashCode 中使用它。

咱们自定义 key 类的最佳实践是使之为不可变的,这样,hashCode 值可以被缓存起来,拥有更好的性能。不可变的类也可以确保 hashCode 和 equals 在未来不会改变,这样就会解决与可变相关的问题了。

37、HashMap 的长度为什么是 2 的 N 次方呢?

为了能让 HashMap 存数据和取数据的效率高,尽可能地减少 hash 值的碰撞,也就是说尽量把数据能均匀的分配,每个链表或者红黑树长度尽量相等。

我们首先可能会想到 % 取模的操作来实现。

下面是回答的重点哟:

取余(%)操作中如果除数是 2 的幂次,则等价于与其除数减一的与(&)操作(也就是说 hash % length == hash & ( length - 1 ) 的前提是 length 是 2 的 n 次方)。并且,采用二进制位操作 & ,相对于 % 能够提高运算效率。

这就是为什么 HashMap 的长度需要 2 的 N 次方了

38、HashMap 与 ConcurrentHashMap 的异同

都是 key - value 形式的存储数据;

HashMap 是线程不安全的,ConcurrentHashMap 是 JUC 下的线程安全的;

HashMap 底层数据结构是数组 + 链表( JDK 1.8 之前)。JDK 1.8 之后是数组 + 链表 + 红黑树。当链表中元素个数达到 8 的时候,链表的查询速度不如红黑树快,链表会转为红黑树,红黑树查询速度快;

HashMap 初始数组大小为 16(默认),当出现扩容的时候,以 0.75 * 数组大小的方式进行扩容;

ConcurrentHashMap 在 JDK 1.8 之前是采用分段锁来现实的 Segment + HashEntry,Segment 数组大小默认是 16,2 的 n 次方;JDK 1.8 之后,采用 Node + CAS + Synchronized来保证并发安全进行实现。

39、红黑树有哪几个特征?

每个节点是黑色或红色

根节点是黑色

每个叶子节点都是黑色(指向空的叶子节点)

如果一个叶子节点是红色,那么其子节点必须都是黑色的

从一个节点到该节点的子孙节点的所有路径上包含相同数目的黑节点

40、说说你平时是怎么处理 Java 异常的

try - catch - finally

try 块负责监控可能出现异常的代码

catch 块负责捕获可能出现的异常,并进行处理

finally 块负责清理各种资源,不管是否出现异常都会执行

其中 try 块是必须的,catch 和 finally 至少存在一个标准异常处理流程

在开发过程中会使用到自定义异常,在通常情况下,程序很少会自己抛出异常,因为异常的类名通常也包含了该异常的有用信息,所以在选择抛出异常的时候,应该选择合适的异常类,从而可以明确地描述该异常情况,所以这时候往往都是自定义异常。

自定义异常通常是通过继承 java.lang.Exception 类,如果想自定义 Runtime 异常的话,可以继承 java.lang.RuntimeException 类,实现一个无参构造和一个带字符串参数的有参构造方法。

在业务代码里,可以针对性的使用自定义异常。比如说:该用户不具备某某权限、余额不足等

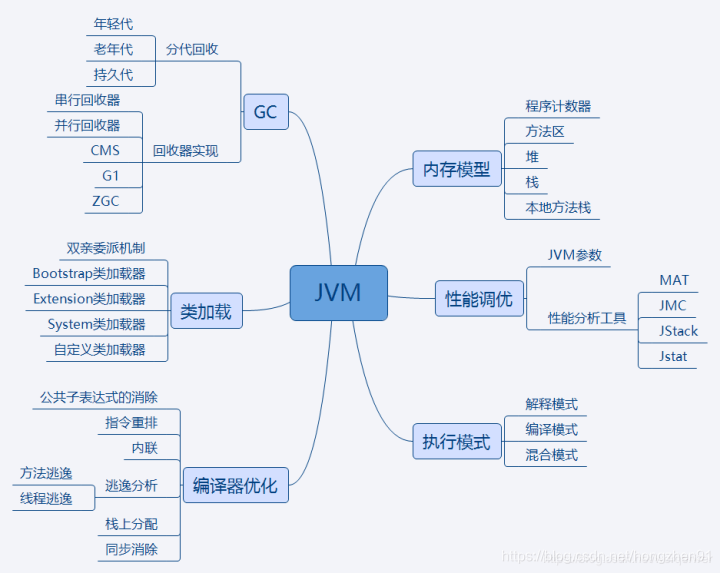

JVM 篇

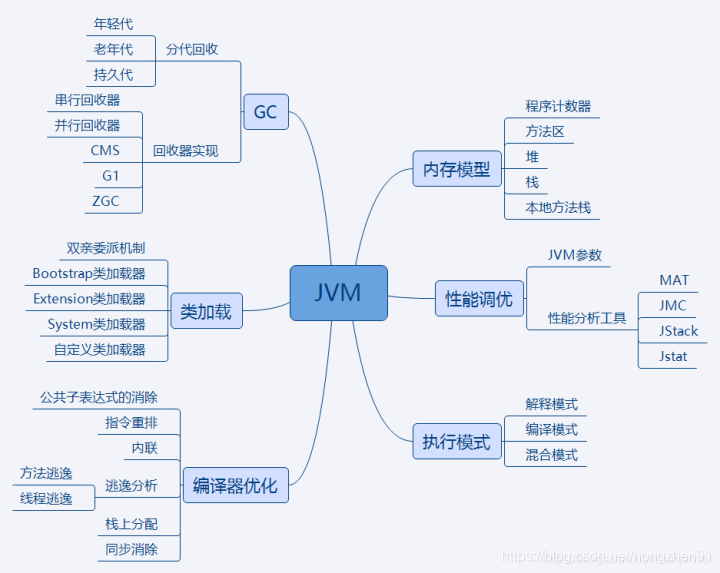

1、知识点汇总

JVM 是 Java 运行基础,面试时一定会遇到 JVM 的有关问题,内容相对集中,但对只是深度要求较高

其中内存模型、类加载机制、GC 是重点方面。性能调优部分更偏向应用。重点突出实践能力,编译器优化和执行模式部分偏向于理论基础,重点掌握知识点。

需了解 内存模型 各部分作用,保存哪些数据。

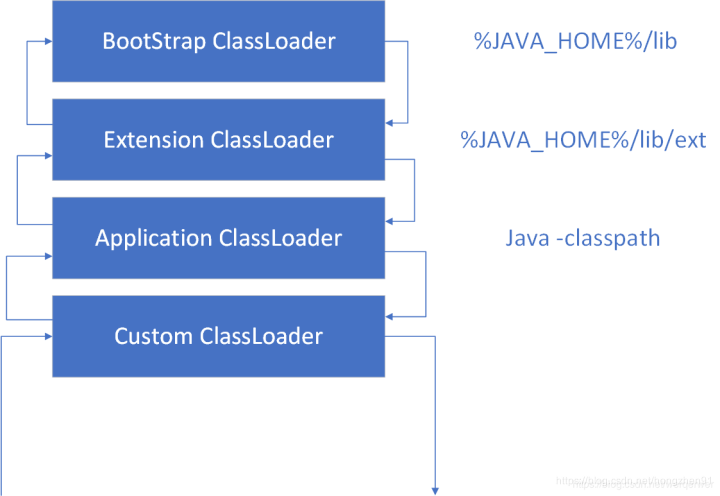

类加载 双亲委派加载机制,常用加载器分别加载哪种类型的类。

GC 分代回收的思想和依据以及不同垃圾回收算法的回收思路和适合场景。

性能调优 常有 JVM 优化参数作用,参数调优的依据,常用的 JVM 分析工具能分析哪些问题以及使用方法。

**执行模式 ** 解释 / 编译 / 混合模式的优缺点,Java 7 提供的分层编译技术,JIT 即时编译技术,OSR 栈上替换,C1 / C2 编译器针对的场景,C2 针对的是 server 模式,优化更激进。新技术方面 Java 10 的 graal 编译器

编译器优化 javac 的编译过程,ast 抽象语法树,编译器优化和运行器优化.

2、知识点详解

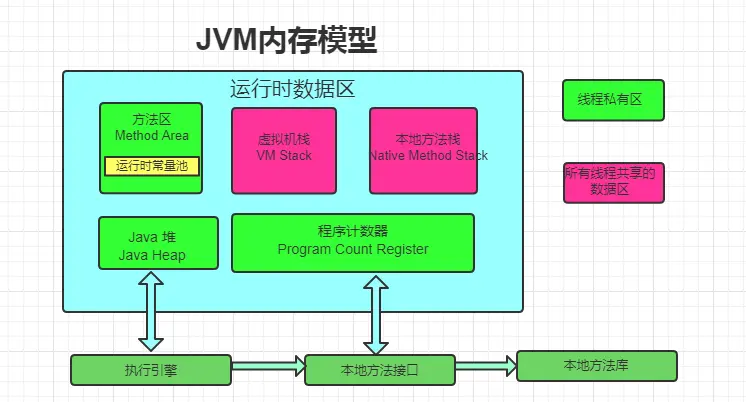

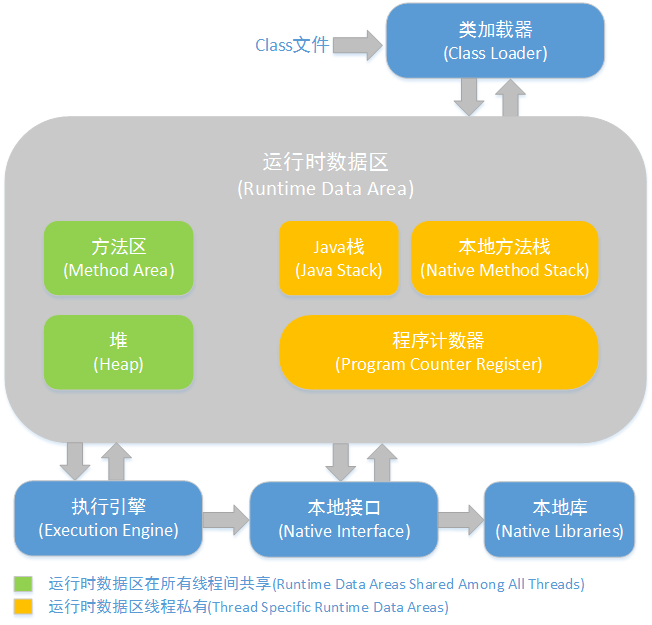

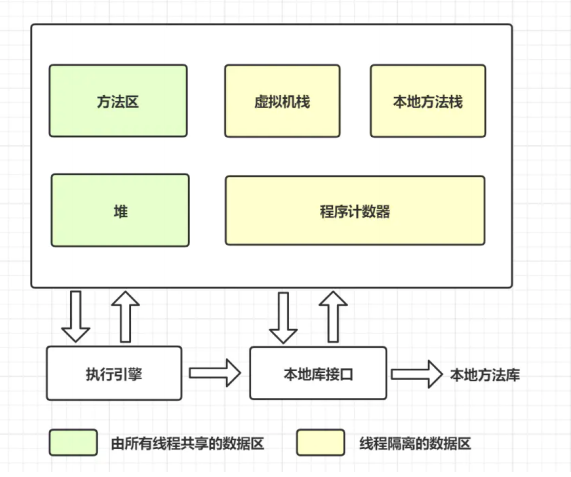

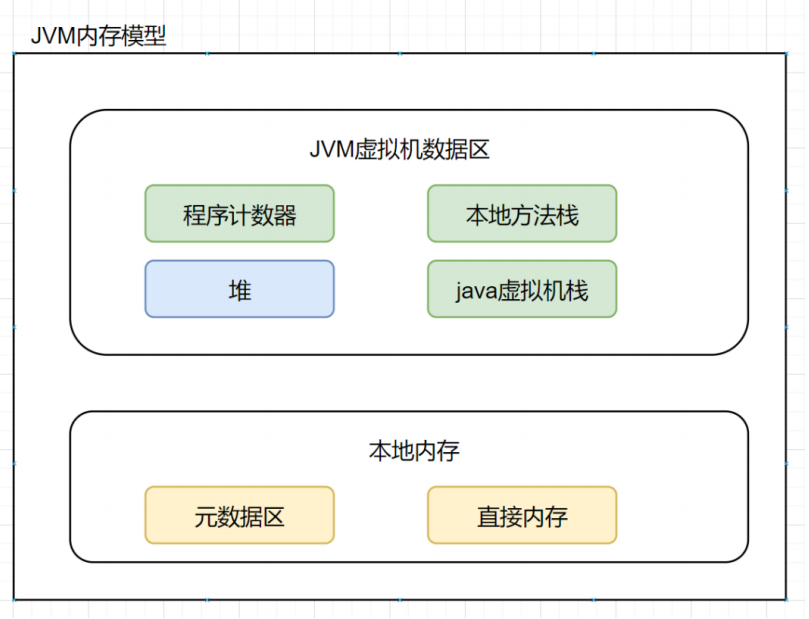

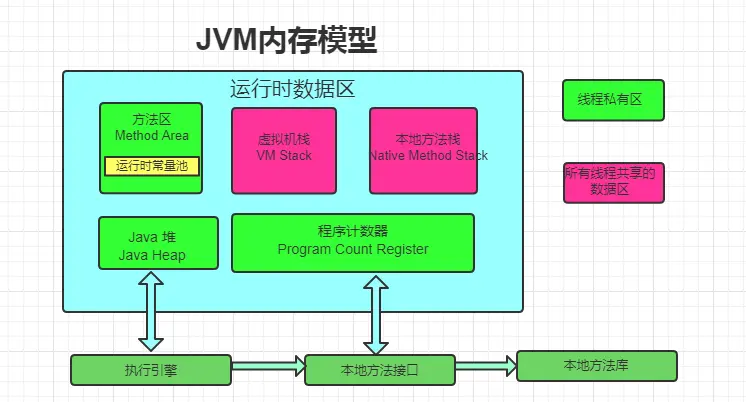

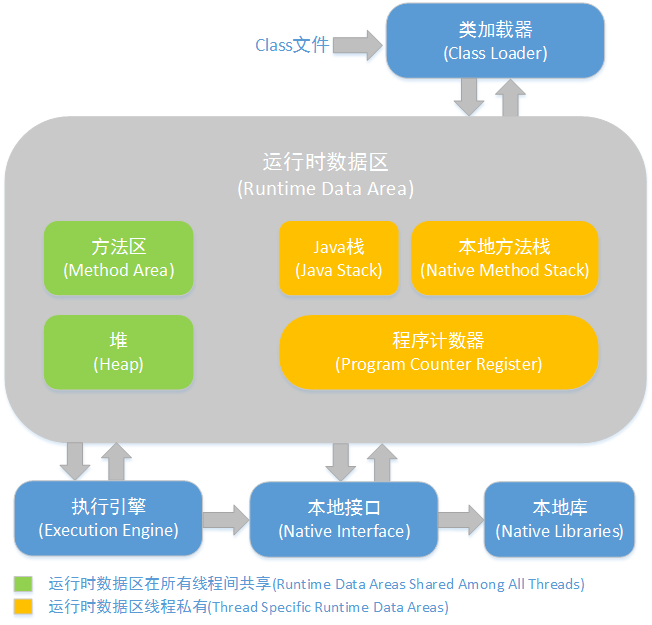

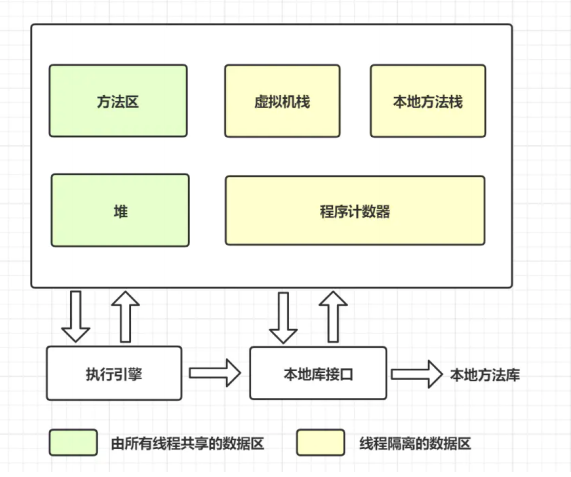

1、JVM 内存模型:

线程独占:栈,本地方法栈,程序计数器

线程共享:堆,方法区

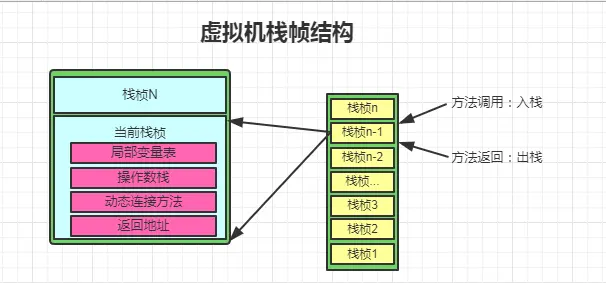

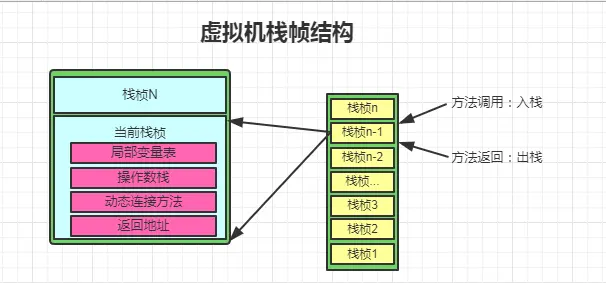

2、栈:

又称方法栈,线程私有的,线程执行方法是都会创建一个栈阵,用来存储局部变量表、操作栈、动态链接、方法出口等信息。调用方法时执行入栈,方法返回时执行出栈。

3、本地方法栈

与栈类似,也是用来保存执行方法的信息。执行 Java 方法是使用栈,执行 Native 方法时使用本地方法栈。

4、程序计数器

保存着当前线程执行的字节码位置,每个线程工作时都有独立的计数器,只为执行 Java 方法服务,执行 Native 方法时,程序计数器为空

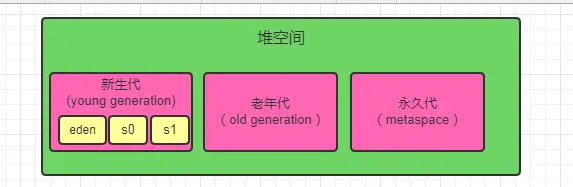

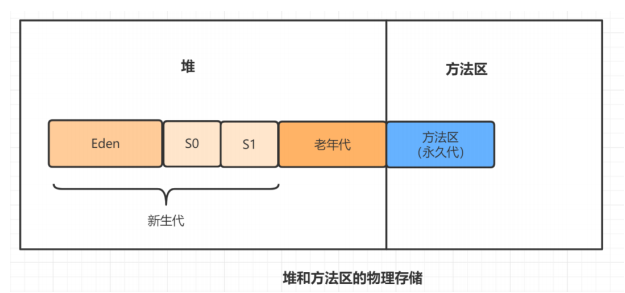

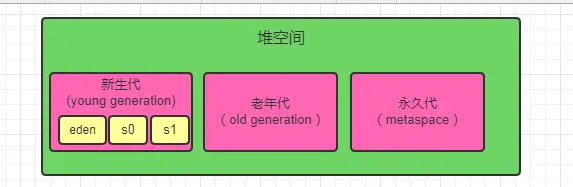

5、堆

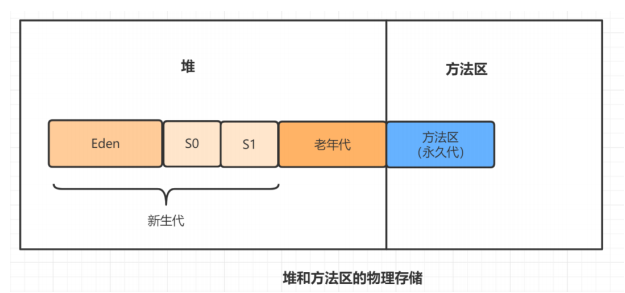

JVM 内存管理最大的一块,它被线程共享,目的是存放对象的实例,几乎所有的对象实例都会放在这里,当堆没有可用空间时,会抛出OOM 异常。根据对象的存活周期不同,JVM 把对象进行分代管理,由垃圾回收器进行垃圾的回收管理

6、方法区:

又称非堆区,用于存储已被虚拟机加载的类信息、常量、静态变量,即时编译器优化后的代码等数据。1.7 的永久代和 1.8 的元空间都是方法区的一种实现

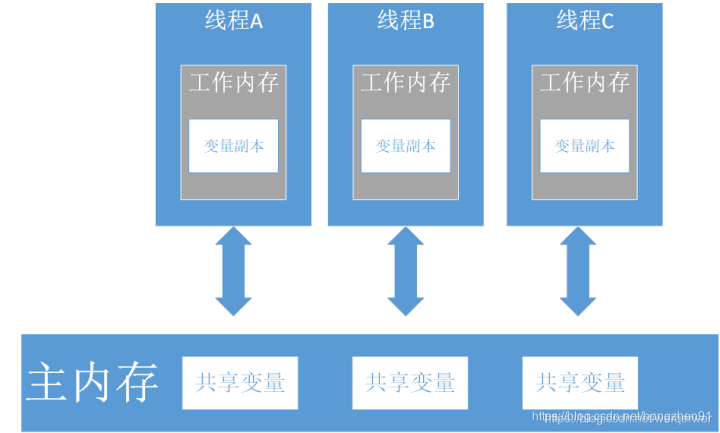

7、JVM 内存可见性

JMM 是定义程序中变量的访问规则,线程对于变量的操作只能在自己的工作内存中进行,而不能直接对主内存操作。由于指令重排序,读写的顺序会被打乱,因此 JMM 需要提供原子性、可见性、有序性保证。

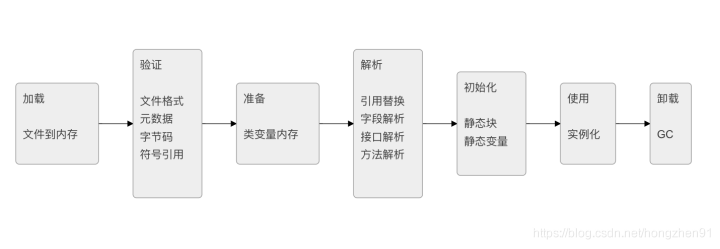

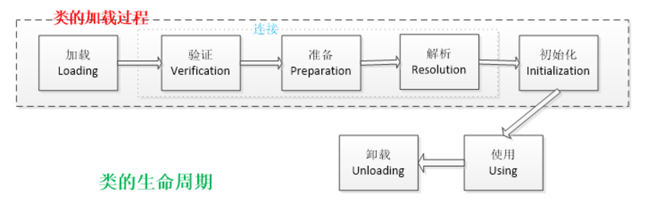

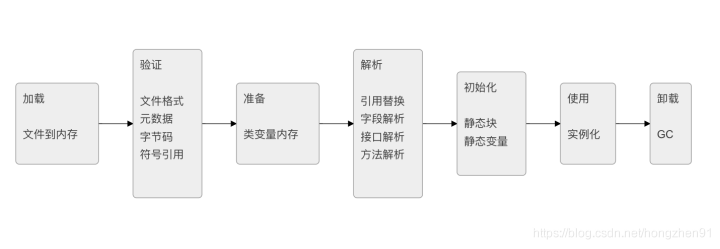

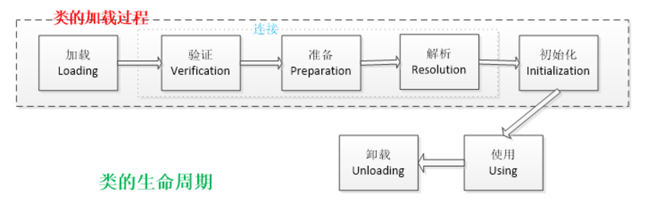

3、说说类加载与卸载

1、加载过程

其中 验证,准备,解析 合称链接

加载 通过类的完全限定名,查找此类字节码文件,利用字节码文件创建Class对象。

验证 确保 Class 文件符合当前虚拟机的要求,不会危害到虚拟机自身安全。

准备 进行内存分配,为 static 修饰的类变量分配内存,并设置初始值 ( 0 或 null )。不包含 final 修饰的静态变量,因为 final 变量在编译时分配。

**解析 **将常量池中的符号引用替换为直接引用的过程,直接引用为直接指向目标的指针或者相对偏移量等。

初始化 主要完成静态块执行以及静态变量的赋值,先初始化父类,再初始化当前类,只有对类主动使用时才会初始化。

触发条件包括,创建类的实例时,访问类的静态方法或静态变量的时候,使用 Class.forName 反射类的时候,或者某个子类初始化的时候。

Java 自带的加载器加载的类,在虚拟机的生命周期中是不会被卸载的,只有用户自定义的加载器加载的类才可以被卸

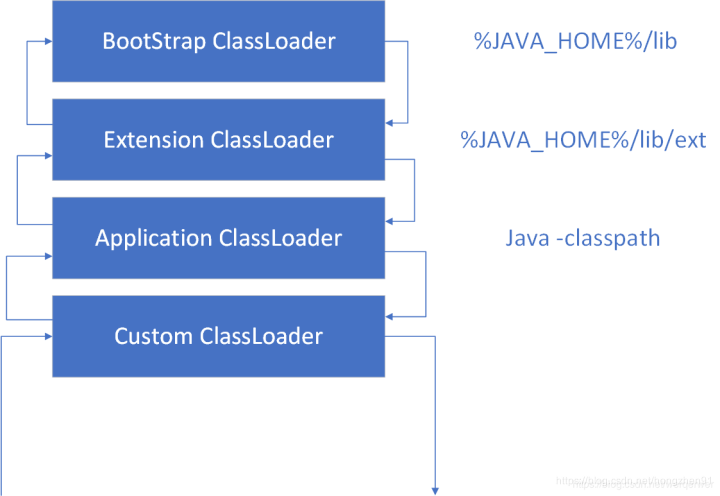

2、加载机制 - 双亲委派模式

双亲委派模式,即加载器加载类时先把请求委托给自己的父类加载器执行,直到顶层的启动类加载器。

父类加载器能够完成加载则成功返回,不能则子类加载器才自己尝试加载。

优点:

- 避免类的重复加载

- 避免 Java 的核心 API 被篡改

3、分代回收

分代回收基于两个事实:大部分对象很快就不使用了,还有一部分不会立即无用,但也不会持续很长时间。

| 堆分代 | |||

|---|---|---|---|

| 年轻代 | Dden | Survivor1 | Survivor2 |

| 老年代 | Tebured | Tenured | Tenured |

| 永久代 | PremGen / MetaSpace | PremGen / MetaSpace | PremGen / MetaSpace |

年轻代 ——> 标记 - 复制 老年代 ——> 标记 - 清除

4、回收算法

a、G1算法

1.9 后默认的垃圾回收算法,特点保持高回收率的同时减少停顿。采用每次只清理一部分,而不是清理全部的增量式清理,以保证停顿时间不会过长

其取消了年轻代与老年代的物理划分,但仍属于分代收集器,算法将堆分为若干个逻辑区域 ( region ) ,一部分用作年轻代,一部分用作老年代,还有用来存储巨型对象的分区。

同 CMS 相同,会遍历所有对象,标记引用情况,清除对象后会对区域进行复制移动,以整合碎片空间。

年轻代回收:并行复制采用复制算法,并行收集,会 StopTheWorld。

老年代回收:会对年轻代一并回收

初始标记完成堆 root 对象的标记,会 StopTheWorld。并发标记 GC 线程和应用线程并发执行。 最终标记完成三色标记周期,会StopTheWorld。复制 / 清楚会优先对可回收空间加大的区域进行回收

b、ZGC算法

前面提供的高效垃圾回收算法,针对大堆内存设计,可以处理 TB 级别的堆,可以做到 10 ms 以下的回收停顿时间

GC roots 标记 ——> 并发标记 ——> 清除 ——> 并发重定位 <—— root 重定位

着色指针

读屏障

并发处理

基于 region

内存压缩 ( 整理 )

roots 标记:标记 root 对象,会发生 StopTheWorld.。并发标记:利用读屏障与应用线程一起运行标记,可能会发生 StopTheWorld。清除会清理标记为不可用的对象。 roots 重定位:是对存活的对象进行移动,以腾出大块内存空间,减少碎片产生。重定位最开始会StopTheWorld,取决于重定位集与对象总活动集的比例。并发重定位与并发标记类似

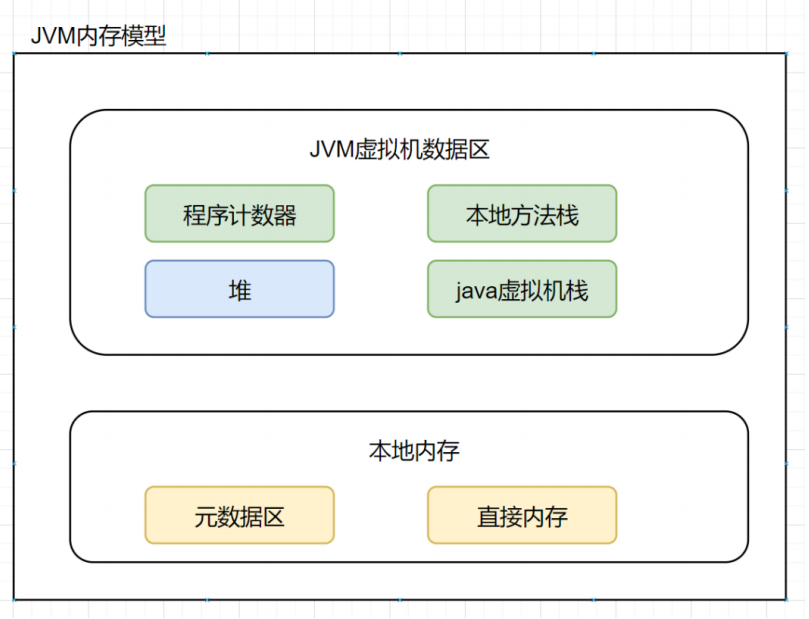

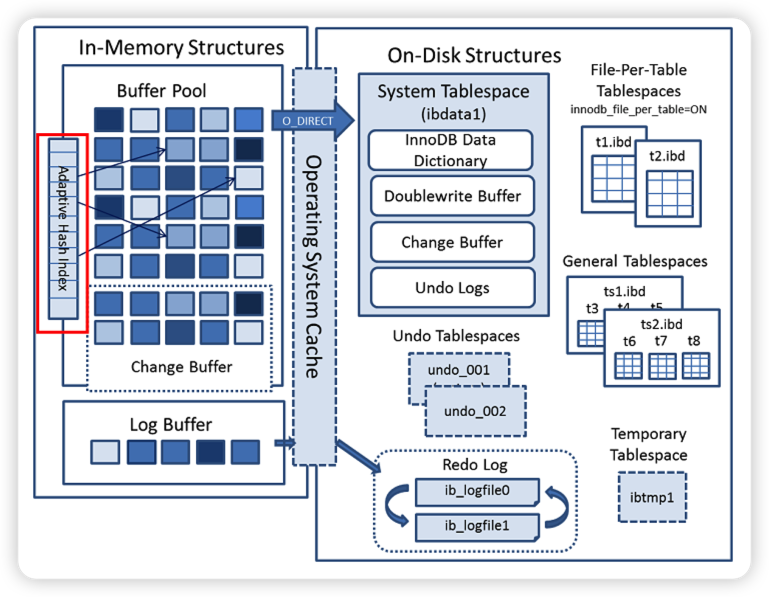

4、简述一下 JVM 的内存模型

1.JVM 内存模型简介

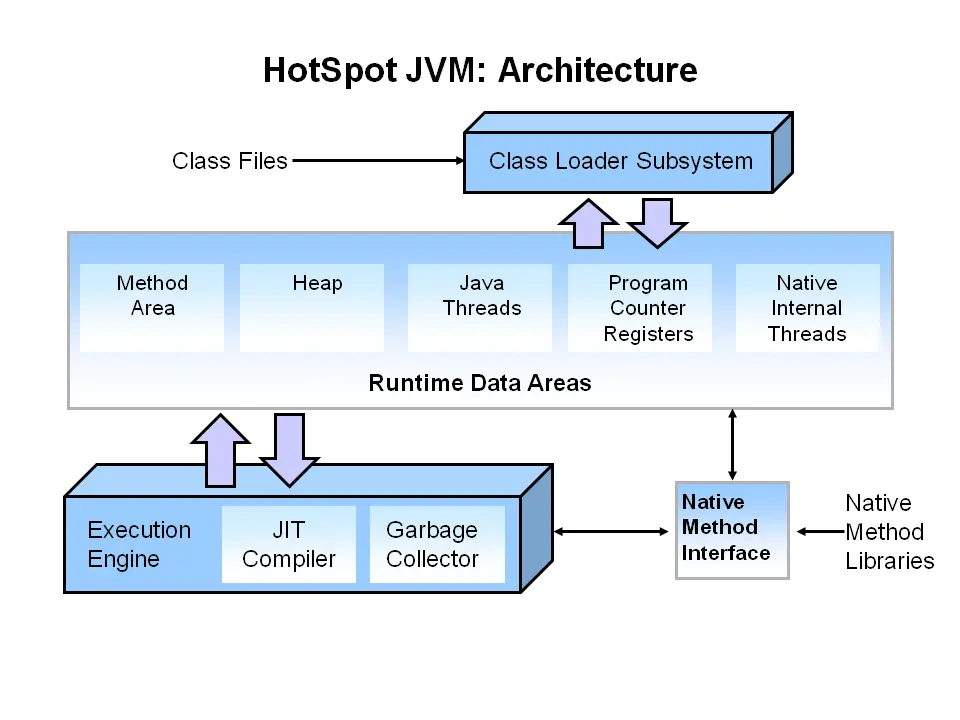

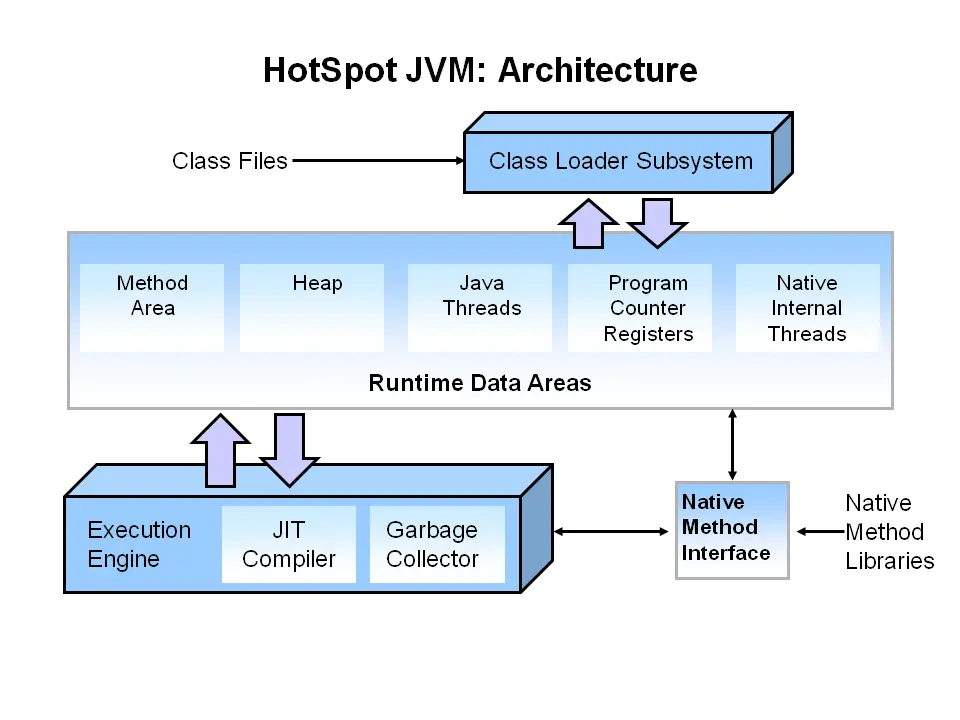

JVM 定义了不同运行时数据区,他们是用来执行应用程序的。某些区域随着 JVM 启动及销毁,另外一些区域的数据是线程性独立的,随着线程创建和销毁。JVM 内存模型总体架构图如下:( 摘自 oracle 官方网站 )

JVM 在执行 Java 程序时,会把它管理的内存划分为若干个的区域,每个区域都有自己的用途和创建销毁时间。如下图所示,可以分为两大部分,线程私有区和共享区。下图是根据自己理解画的一个 JVM 内存模型架构图

JVM 内存分为线程私有区和线程共享区

线程私有区

1、程序计数器

当同时进行的线程数超过 CPU 数或其内核数时,就要通过时间片轮询分派 CPU 的时间资源,不免发生线程切换。这时,每个线程就需要一个属于自己的计数器来记录下一条要运行的指令。如果执行的是 JAVA 方法,计数器记录正在执行的 java 字节码地址,如果执行的是native 方法,则计数器为空。

2、虚拟机栈

线程私有的,与线程在同一时间创建。管理 JAVA 方法执行的内存模型。每个方法执行时都会创建一个桢栈来存储方法的的变量表、操作数栈、动态链接方法、返回值、返回地址等信息。栈的大小决定了方法调用的可达深度( 递归多少层次,或嵌套调用多少层其他方法, -Xss 参数可以设置虚拟机栈大小)。栈的大小可以是固定的,或者是动态扩展的。如果请求的栈深度大于最大可用深度,则抛出stackOverflowError;如果栈是可动态扩展的,但没有内存空间支持扩展,则抛出 OutofMemoryError。 使用 jclasslib 工具可以查看class 类文件的结构。下图为栈帧结构图:

3、本地方法栈

与虚拟机栈作用相似。但它不是为 Java 方法服务的,而是本地方法( C 语言)。由于规范对这块没有强制要求,不同虚拟机实现方法不同。

线程共享区

1、方法区

线程共享的,用于存放被虚拟机加载的类的元数据信息,如常量、静态变量和即时编译器编译后的代码。若要分代,算是永久代(老年代),以前类大多 static 的,很少被卸载或收集,现回收废弃常量和无用的类。其中运行时常量池存放编译生成的各种常量。(如果hotspot 虚拟机确定一个类的定义信息不会被使用,也会将其回收。回收的基本条件至少有:所有该类的实例被回收,而且装载该类的ClassLoader 被回收)

2、堆

存放对象实例和数组,是垃圾回收的主要区域,分为新生代和老年代。刚创建的对象在新生代的 Eden 区中,经过 GC 后进入新生代的 S0 区中,再经过 GC 进入新生代的 S1 区中,15 次 GC 后仍存在就进入老年代。这是按照一种回收机制进行划分的,不是固定的。若堆的空间不够实例分配,则 OutOfMemoryError。

1 | Young Generation 即图中的 Eden + From Space(s0) + To Space(s1) |

5、说说堆和栈的区别

栈是运行时单位,代表着逻辑,内含基本数据类型和堆中对象引用,所在区域连续,没有碎片;堆是存储单位,代表着数据,可被多个栈共享(包括成员中基本数据类型、引用和引用对象),所在区域不连续,会有碎片。

1、功能不同

栈内存用来存储 局部变量 和 方法调用,而堆内存用来存储 Java 中的对象。无论是成员变量,局部变量,还是类变量,它们指向的对象都存储在堆内存中。

2、共享性不同

栈内存是线程私有的。 堆内存是所有线程共有的。

3、异常错误不同

如果栈内存或者堆内存不足都会抛出异常。

栈空间不足:java.lang.StackOverFlowError。

堆空间不足:java.lang.OutOfMemoryError。

4、空间大小

栈的空间大小远远小于堆的。

6、什么时候会触发 Full GC

除直接调用 System.gc 外,触发 Full GC 执行的情况有如下四种。

1、旧生代空间不足

旧生代空间只有在新生代对象转入及创建为大对象、大数组时才会出现不足的现象,当执行 Full GC 后空间仍然不足,则抛出如下错误: java.lang.OutOfMemoryError: Java heap space 为避免以上两种状况引起的 Full GC,调优时应尽量做到让对象在 Minor GC 阶段被回收、让对象在新生代多存活一段时间及不要创建过大的对象及数组。

2、Permanet Generation 空间满

Permanet Generation中 存放的为一些 class 的信息等,当系统中要加载的类、反射的类和调用的方法较多时,Permanet Generation 可能会被占满,在未配置为采用 CMS GC 的情况下会执行 Full GC。如果经过 Full GC 仍然回收不了,那么 JVM 会抛出如下错误信息: java.lang.OutOfMemoryError: PermGen space 为避免 Perm Gen 占满造成 Full GC 现象,可采用的方法为增大 Perm Gen 空间或转为使用 CMS GC。

3、CMS GC 时出现 promotion failed 和 concurrent mode failure

对于采用 CMS 进行旧生代 GC 的程序而言,尤其要注意 GC 日志中是否有 promotion failed 和 concurrent mode failure 两种状况,当这两种状况出现时可能会触发 Full GC。 promotion failed 是在进行 Minor GC 时,survivor space 放不下、对象只能放入旧生代,而此时旧生代也放不下造成的;concurrent mode failure 是在执行 CMS GC 的过程中同时有对象要放入旧生代,而此时旧生代空间不足造成的。 应对措施为:增大 survivor space、旧生代空间或调低触发并发 GC 的比率,但在 JDK 5.0 +、6.0 + 的版本中有可能会由于 JDK 的bug29 导致 CMS 在 remark 完毕后很久才触发 sweeping 动作。对于这种状况,可通过设置 -XX:CMSMaxAbortablePrecleanTime=5(单位为ms)来避免。

4、统计得到的 Minor GC 晋升到旧生代的平均大小大于旧生代的剩余空间

这是一个较为复杂的触发情况,Hotspot 为了避免由于新生代对象晋升到旧生代导致旧生代空间不足的现象,在进行 Minor GC 时,做了一个判断,如果之前统计所得到的 Minor GC 晋升到旧生代的平均大小大于旧生代的剩余空间,那么就直接触发 Full GC。 例如程序第一次触发 Minor GC 后,有 6 MB 的对象晋升到旧生代,那么当下一次 Minor GC 发生时,首先检查旧生代的剩余空间是否大于 6 MB,如果小于 6 MB,则执行 Full GC。 当新生代采用 PS GC 时,方式稍有不同,PS GC 是在 Minor GC 后也会检查,例如上面的例子中第一次 Minor GC 后,PS GC 会检查此时旧生代的剩余空间是否大于 6 MB,如小于,则触发对旧生代的回收。 除了以上4种状况外,对于使用RMI来进行RPC或管理的Sun JDK应用而言,默认情况下会一小时执行一次Full GC。可通过在启动时通过

-java Dsun.rmi.dgc.client.gcInterval=3600000来设置Full GC执行的间隔时间或通过

-XX:+DisableExplicitGC来禁止 RMI 调用 System.gc

7、什么是 Java 虚拟机?为什么 Java 被称作是“平台无关的编程语言“?

Java 虚拟机是一个可以执行 Java 字节码的虚拟机进程。Java 源文件被编译成能被 Java 虚拟机执行的字节码文件。 Java 被设计成允许应用程序可以运行在任意的平台,而不需要程序员为每一个平台单独重写或者是重新编译。Java 虚拟机让这个变为可能,因为它知道底层硬件平台的指令长度和其他特性。

8、Java 内存结构

方法区和堆是所有线程共享的内存区域;而 java 栈、本地方法栈和程序员计数器是运行是线程私有的内存区域。

Java 堆( Heap )是 Java 虚拟机所管理的内存中最大的一块。Java 堆是被所有线程共享的一块内存区域,在虚拟机启动时创建。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例都在这里分配内存。

方法区( Method Area )与 Java 堆一样,是各个线程共享的内存区域,它用于存储已被虚拟机加载的类信息、常量、静态变量、即时编译器编译后的代码等数据。

程序计数器( Program Counter Register )是一块较小的内存空间,它的作用可以看做是当前线程所执行的字节码的行号指示器。

JVM 栈(JVM Stacks)与程序计数器一样,Java 虚拟机栈( Java Virtual Machine Stacks )也是线程私有的,它的生命周期与线程相同。虚拟机栈描述的是 Java 方法执行的内存模型:每个方法被执行的时候都会同时创建一个栈帧( Stack Frame )用于存储局部变量表、操作栈、动态链接、方法出口等信息。每一个方法被调用直至执行完成的过程,就对应着一个栈帧在虚拟机栈中从入栈到出栈的过程。

本地方法栈(Native Method Stacks)与虚拟机栈所发挥的作用是非常相似的,其区别不过是虚拟机栈为虚拟机执行 Java 方法(也就是字节码)服务,而本地方法栈则是为虚拟机使用到的 Native 方法服务。

9、说说对象分配规则

对象优先分配在 Eden 区,如果 Eden 区没有足够的空间时,虚拟机执行一次 Minor GC。

大对象直接进入老年代(大对象是指需要大量连续内存空间的对象)。这样做的目的是避免在Eden区和两个 Survivor 区之间发生大量的内存拷贝(新生代采用复制算法收集内存)。

长期存活的对象进入老年代。虚拟机为每个对象定义了一个年龄计数器,如果对象经过了 1 次 Minor GC 那么对象会进入 Survivor区,之后每经过一次 Minor GC 那么对象的年龄加 1,知道达到阀值对象进入老年区。

动态判断对象的年龄。如果 Survivor 区中相同年龄的所有对象大小的总和大于 Survivor 空间的一半,年龄大于或等于该年龄的对象可以直接进入老年代。

空间分配担保。每次进行 Minor GC 时,JVM 会计算 Survivor 区移至老年区的对象的平均大小,如果这个值大于老年区的剩余值大小则进行一次 Full GC,如果小于检查 HandlePromotionFailure 设置,如果 true 则只进行 Monitor GC,如果 false 则进行 Full GC。

10、描述一下 JVM 加载 class 文件的原理机制?

JVM 中类的装载是由类加载器( ClassLoader )和它的子类来实现的,Java 中的类加载器是一个重要的 Java 运行时系统组件,它负责在运行时查找和装入类文件中的类。 由于 Java 的跨平台性,经过编译的 Java 源程序并不是一个可执行程序,而是一个或多个类文件。当Java 程序需要使用某个类时,JVM 会确保这个类已经被 加载、连接(验证、准备和解析)和初始化。类的加载是指把类的 .class 文件中的数据读入到内存中,通常是创建一个字节数组读入 .class 文件,然后产生与所加载类对应的 Class 对象。加载完成后,Class 对象还不完整,所以此时的类还不可用。当类被加载后就进入连接阶段,这一阶段包括 验证、准备(为静态变量分配内存并设置默认的初始值)和解析(将符号引用替换为直接引用)三个步骤。

最后JVM对类进行初始化,包括:

如果类存在直接的父类并且这个类还没有被初始化,那么就先初始化父类;

如果类中存在初始化语句,就依次执行这些初始化语句。 类的加载是由类加载器完成的,类加载器包括:根加载器(BootStrap)、扩展加载器(Extension)、系统加载器(System)和用户自定义类加载器(java.lang.ClassLoader的子类)。从 Java 2(JDK 1.2)开始,类加载过程采取了父亲委托机制(PDM)。PDM 更好的保证了 Java 平台的安全性,在该机制中,JVM 自带的 Bootstrap 是根加载器,其他的加载器都有且仅有一个父类加载器。类的加载首先请求父类加载器加载,父类加载器无能为力时才由其子类加载器自行加载。JVM 不会向 Java 程序提供对 Bootstrap 的引用。下面是关于几个类加载器的说明:

Bootstrap:一般用本地代码实现,负责加载 JVM 基础核心类库(rt.jar);

Extension:从

java.ext.dirs系统属性所指定的目录中加载类库,它的父加载器是 Bootstrap;System:又叫应用类加载器,其父类是 Extension。它是应用最广泛的类加载器。它从环境变量 classpath 或者系统属性java.class.path 所指定的目录中记载类,是用户自定义加载器的默认父加载器。

11、说说 Java 对象创建过程

JVM 遇到一条新建对象的指令时首先去检查这个指令的参数是否能在常量池中定义到一个类的符号引用。然后加载这个类(类加载过程在后边讲)

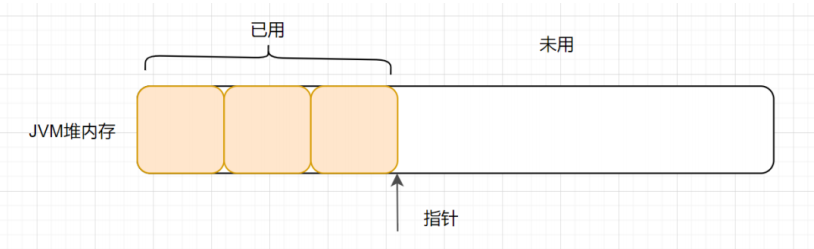

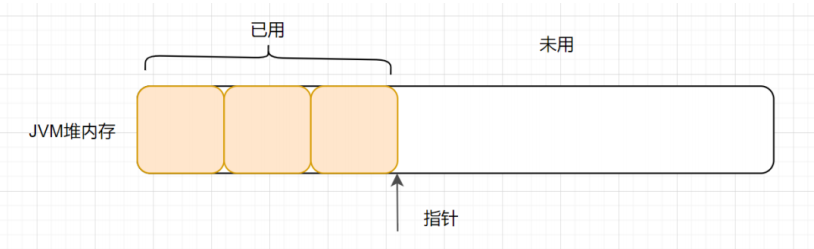

为对象分配内存。一种办法 “指针碰撞” 、一种办法 “空闲列表” ,最终常用的办法 “本地线程缓冲分配(TLAB)”

将除对象头外的对象内存空间初始化为 0

对对象头进行必要设置

12、知道类的生命周期吗?

类的生命周期包括这几个部分,加载、连接、初始化、使用和卸载,其中前三部是类的加载的过程,如下图;

加载,查找并加载类的二进制数据,在 Java 堆中也创建一个

java.lang.Class类的对象连接,连接又包含三块内容:验证、准备、初始化。 1)验证,文件格式、元数据、字节码、符号引用验证; 2)准备,为类的静态变量分配内存,并将其初始化为默认值; 3)解析,把类中的符号引用转换为直接引用

初始化,为类的静态变量赋予正确的初始值

使用,new 出对象程序中使用

卸载,执行垃圾回收

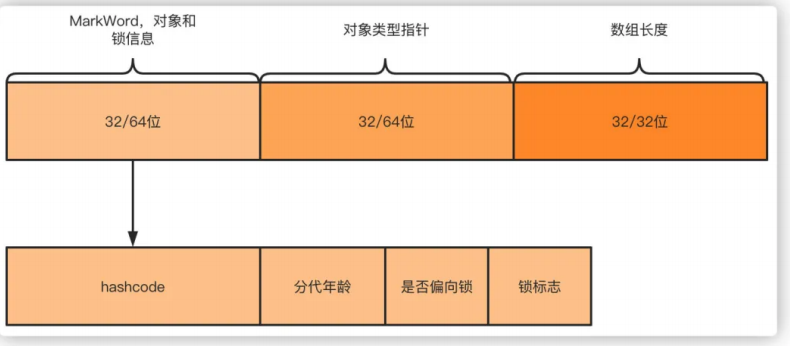

13、简述 Java 的对象结构

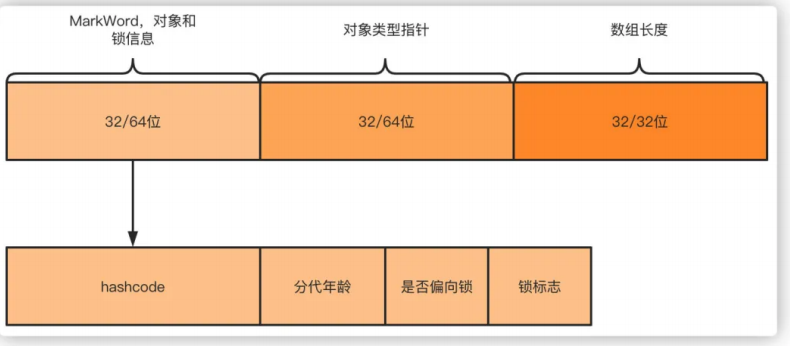

Java 对象由三个部分组成:对象头、实例数据、对齐填充。

对象头由两部分组成,第一部分存储对象自身的运行时数据:哈希码、GC 分代年龄、锁标识状态、线程持有的锁、偏向线程 ID(一般占 32 / 64 bit )。第二部分是指针类型,指向对象的类元数据类型(即对象代表哪个类)。如果是数组对象,则对象头中还有一部分用来记录数组长度。

实例数据用来存储对象真正的有效信息(包括父类继承下来的和自己定义的)

对齐填充:JVM 要求对象起始地址必须是 8 字节的整数倍(8 字节对齐)

14、如何判断对象可以被回收?

判断对象是否存活一般有两种方式:

引用计数:每个对象有一个引用计数属性,新增一个引用时计数加 1,引用释放时计数减 1,计数为 0 时可以回收。此方法简单,无法解决对象相互循环引用的问题。

可达性分析(Reachability Analysis):从 GC Roots 开始向下搜索,搜索所走过的路径称为引用链。当一个对象到 GC Roots 没有任何引用链相连时,则证明此对象是不可用的,不可达对象。

15、JVM 的永久代中会发生垃圾回收么?

垃圾回收不会发生在永久代,如果永久代满了或者是超过了临界值,会触发完全垃圾回收(Full GC)。如果你仔细查看垃圾收集器的输出信息,就会发现永久代也是被回收的。这就是为什么正确的永久代大小对避免Full GC是非常重要的原因。请参考下 Java 8:从永久代到元数据区(注:Java 8 中已经移除了永久代,新加了一个叫做元数据区的 native 内存区)

16、你知道哪些垃圾收集算法

GC 最基础的算法有三种: 标记 - 清除算法、复制算法、标记 - 压缩算法,我们常用的垃圾回收器一般都采用分代收集算法。

标记 - 清除算法,“标记 - 清除”( Mark - Sweep )算法,如它的名字一样,算法分为“标记”和“清除”两个阶段:首先标记出所有需要回收的对象,在标记完成后统一回收掉所有被标记的对象。

复制算法,“复制”( Copying )的收集算法,它将可用内存按容量划分为大小相等的两块,每次只使用其中的一块。当这一块的内存用完了,就将还存活着的对象复制到另外一块上面,然后再把已使用过的内存空间一次清理掉。

标记 - 压缩算法,标记过程仍然与“标记 - 清除”算法一样,但后续步骤不是直接对可回收对象进行清理,而是让所有存活的对象都向一端移动,然后直接清理掉端边界以外的内存

分代收集算法,“分代收集”( Generational Collection )算法,把 Java 堆分为新生代和老年代,这样就可以根据各个年代的特点采用最适当的收集算法。

17、调优命令有哪些?

Sun JDK 监控和故障处理命令有 jps jstat jmap jhat jstack jinfo

jps,JVM Process Status Tool,显示指定系统内所有的 HotSpot 虚拟机进程。

jstat,JVM statistics Monitoring 是用于监视虚拟机运行时状态信息的命令,它可以显示出虚拟机进程中的类装载、内存、垃圾收集、JIT 编译等运行数据。

jmap,JVM Memory Map 命令用于生成 heap dump 文件

jhat,JVM Heap Analysis Tool 命令是与 jmap 搭配使用,用来分析 jmap 生成的 dump,jhat 内置了一个微型的 HTTP / HTML 服务器,生成 dump 的分析结果后,可以在浏览器中查看

jstack,用于生成 java 虚拟机当前时刻的线程快照。

jinfo,JVM Configuration info 这个命令作用是实时查看和调整虚拟机运行参数。

18、常见调优工具有哪些

常用调优工具分为两类,jdk 自带监控工具:jconsole 和 jvisualvm,第三方有:MAT(Memory Analyzer Tool)、GChisto。

jconsole,Java Monitoring and Management Console 是从 java5 开始,在 JDK 中自带的 java 监控和管理控制台,用于对 JVM 中内存,线程和类等的监控

jvisualvm,jdk 自带全能工具,可以分析内存快照、线程快照;监控内存变化、GC 变化等。

MAT,Memory Analyzer Tool,一个基于 Eclipse 的内存分析工具,是一个快速、功能丰富的 Java heap 分析工具,它可以帮助我们查找内存泄漏和减少内存消耗

GChisto,一款专业分析 gc 日志的工具

19、Minor GC 与 Full GC 分别在什么时候发生?

新生代内存不够用时候发生 MGC 也叫 YGC,JVM 内存不够的时候发生 FGC

20、你知道哪些 JVM 性能调优参数?

简单回答:

设定堆内存大小

-Xmx 堆内存最大限制。设定新生代大小。 新生代不宜太小,否则会有大量对象涌入老年代

-XX:NewSize 新生代大小 -XX:NewRatio 新生代和老生代占比 -XX:SurvivorRatio 伊甸园空间和幸存者空间的占比设定垃圾回收器 年轻代用 -XX:+UseParNewGC 年老代用 -XX:+UseConcMarkSweepGC

具体回答:

「堆栈内存相关」

-Xms 设置初始堆的大小

-Xmx 设置最大堆的大小

-Xmn 设置年轻代大小,相当于同时配置 -XX:NewSize 和 -XX:MaxNewSize 为一样的值

-Xss 每个线程的堆栈大小

-XX:NewSize 设置年轻代大小( for 1.3 / 1.4 )

-XX:MaxNewSize 年轻代最大值( for 1.3 / 1.4 )

-XX:NewRatio 年轻代与年老代的比值(除去持久代)

-XX:SurvivorRatio Eden 区与 Survivor 区的的比值

-XX:PretenureSizeThreshold 当创建的对象超过指定大小时,直接把对象分配在老年代。

-XX:MaxTenuringThreshold 设定对象在 Survivor 复制的最大年龄阈值,超过阈值转移到老年代

「垃圾收集器相关」

-XX:+UseParallelGC 选择垃圾收集器为并行收集器。

-XX:ParallelGCThreads=20 配置并行收集器的线程数

-XX:+UseConcMarkSweepGC 设置年老代为并发收集。

-XX:CMSFullGCsBeforeCompaction=5 由于并发收集器不对内存空间进行压缩、整理,所以运行一段时间以后会产生“碎片”,使得运行效率降低。此值设置运行 5 次 GC 以后对内存空间进行压缩、整理。

-XX:+UseCMSCompactAtFullCollection 打开对年老代的压缩。可能会影响性能,但是可以消除碎片

「辅助信息相关」

-XX:+PrintGCDetails 打印 GC 详细信息

-XX:+HeapDumpOnOutOfMemoryError 让 JVM 在发生内存溢出的时候自动生成内存快照,排查问题用

-XX:+DisableExplicitGC 禁止系统 System.gc(),防止手动误触发 FGC 造成问题.

-XX:+PrintTLAB 查看 TLAB 空间的使用情况

21、 对象一定分配在堆中吗?有没有了解逃逸分析技术?

「对象一定分配在堆中吗?」 不一定的,JVM 通过「逃逸分析」,那些逃不出方法的对象会在栈上分配。

「什么是逃逸分析?」

逃逸分析( Escape Analysis ),是一种可以有效减少 Java 程序中同步负载和内存堆分配压力的跨函数全局数据流分析算法。通过逃逸分析,Java Hotspot 编译器能够分析出一个新的对象的引用的使用范围,从而决定是否要将这个对象分配到堆上。

逃逸分析 是指分析指针动态范围的方法,它同编译器优化原理的指针分析和外形分析相关联。当变量(或者对象)在方法中分配后,其指针有可能被返回或者被全局引用,这样就会被其他方法或者线程所引用,这种现象称作指针(或者引用)的逃逸( Escape )。通俗点讲,如果一个对象的指针被多个方法或者线程引用时,那么我们就称这个对象的指针发生了逃逸。

「逃逸分析的好处」

栈上分配,可以降低垃圾收集器运行的频率。

同步消除,如果发现某个对象只能从一个线程可访问,那么在这个对象上的操作可以不需要同步。

标量替换,把对象分解成一个个基本类型,并且内存分配不再是分配在堆上,而是分配在栈上。这样的好处有,一、减少内存使用,因为不用生成对象头。二、程序内存回收效率高,并且 GC 频率也会减少。

22、虚拟机为什么使用元空间替换了永久代?

「什么是元空间?什么是永久代?为什么用元空间代替永久代?」 我们先回顾一下「方法区」吧,看看虚拟机运行时数据内存图,如下:

方法区和堆一样,是各个线程共享的内存区域,它用于存储已被虚拟机加载的类信息、常量、静态变量、即时编译后的代码等数据。

「什么是永久代?它和方法区有什么关系呢?」

如果在 HotSpot 虚拟机上开发、部署,很多程序员都把方法区称作永久代。可以说方法区是规范,永久代是 Hotspot 针对该规范进行的实现。在 Java7 及以前的版本,方法区都是永久代实现的。

「什么是元空间?它和方法区有什么关系呢?」

对于 Java8,HotSpots 取消了永久代,取而代之的是元空间(Metaspace)。换句话说,就是方法区还是在的,只是实现变了,从永久代变为元空间了。

「为什么使用元空间替换了永久代?」

- 永久代的方法区,和堆使用的物理内存是连续的。

「永久代」是通过以下这两个参数配置大小的~

-XX:PremSize:设置永久代的初始大小

-XX:MaxPermSize: 设置永久代的最大值,默认是 64 M

对于「永久代」,如果动态生成很多 class 的话,就很可能出现「 java.lang.OutOfMemoryError: PermGen space 错误」,因为永久代空间配置有限嘛。最典型的场景是,在 web 开发比较多 jsp 页面的时候。

- JDK 8 之后,方法区存在于元空间( Metaspace)。物理内存不再与堆连续,而是直接存在于本地内存中,理论上机器「内存有多大,元空间就有多大」。

可以通过以下的参数来设置元空间的大小:

-XX:MetaspaceSize,初始空间大小,达到该值就会触发垃圾收集进行类型卸载,同时 GC 会对该值进行调整:如果释放了大量的空间,就适当降低该值;如果释放了很少的空间,那么在不超过 MaxMetaspaceSize 时,适当提高该值。

-XX:MaxMetaspaceSize,最大空间,默认是没有限制的。

-XX:MinMetaspaceFreeRatio,在 GC 之后,最小的 Metaspace 剩余空间容量的百分比,减少为分配空间所导致的垃圾收集

-XX:MaxMetaspaceFreeRatio,在 GC 之后,最大的 Metaspace 剩余空间容量的百分比,减少为释放空间所导致的垃圾收集

「所以,为什么使用元空间替换永久代?」

表面上看是为了避免 OOM 异常。因为通常使用 PermSize 和 MaxPermSize 设置永久代的大小就决定了永久代的上限,但是不是总能知道应该设置为多大合适, 如果使用默认值很容易遇到 OOM 错误。当使用元空间时,可以加载多少类的元数据就不再由 MaxPermSize 控制, 而由系统的实际可用空间来控制啦。

23、什么是 Stop The World ?什么是 OopMap ?什么是安全点?

进行垃圾回收的过程中,会涉及对象的移动。为了保证对象引用更新的正确性,必须暂停所有的用户线程,像这样的停顿,虚拟机设计者形象描述为「 Stop The World 」。也简称为 STW。

在 HotSpot 中,有个数据结构(映射表)称为「 OopMap 」。一旦类加载动作完成的时候,HotSpot 就会把对象内什么偏移量上是什么类型的数据计算出来,记录到 OopMap。在即时编译过程中,也会在「特定的位置」生成 OopMap,记录下栈上和寄存器里哪些位置是引用。

这些特定的位置主要在:

1.循环的末尾(非 counted 循环)

2.方法临返回前 / 调用方法的 call 指令后

3.可能抛异常的位置

这些位置就叫作「安全点( safepoint)」 用户程序执行时并非在代码指令流的任意位置都能够在停顿下来开始垃圾收集,而是必须是执行到安全点才能够暂停。

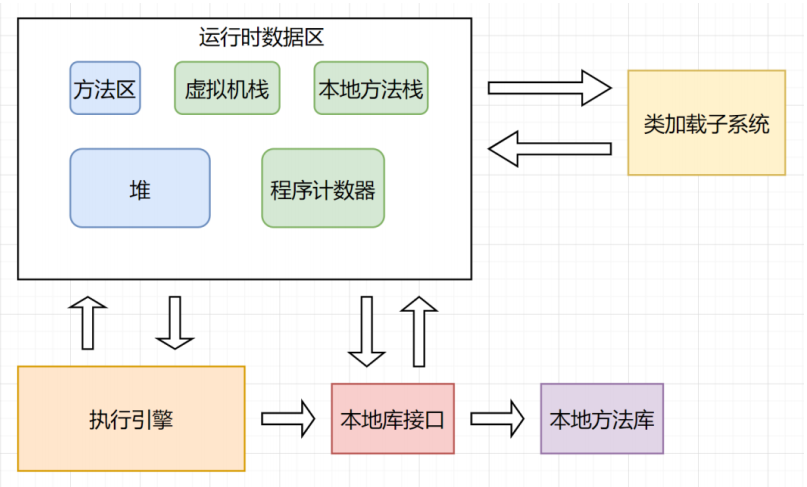

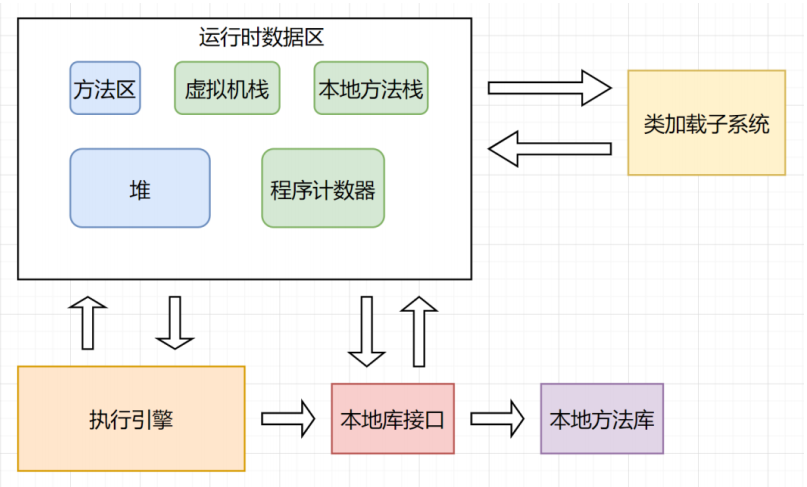

24、说一下 JVM 的主要组成部分及其作用?

JVM 包含两个子系统和两个组件,分别为

Class loader(类装载子系统)

Execution engine(执行引擎子系统)

Runtime data area(运行时数据区组件)

Native Interface(本地接口组件)

「 Class loader(类装载)」: 根据给定的全限定名类名(如:java.lang.Object)来装载 class 文件到运行时数据区的方法区中。

「 Execution engine(执行引擎)」:执行 class 的指令。

「 Native Interface(本地接口)」: 与 native lib 交互,是其它编程语言交互的接口。

「 Runtime data area(运行时数据区域)」:即我们常说的 JVM 的内存。

首先通过编译器把 Java 源代码转换成字节码,Class loader(类装载)再把字节码加载到内存中,将其放在运行时数据区的方法区内,而字节码文件只是 JVM 的一套指令集规范,并不能直接交给底层操作系统去执行,因此需要特定的命令解析器执行引擎(Execution Engine),将字节码翻译成底层系统指令,再交由 CPU 去执行,而这个过程中需要调用其他语言的本地库接口(Native Interface)来实现整个程序的功能。

25、什么是指针碰撞?

一般情况下,JVM 的对象都放在堆内存中(发生逃逸分析除外)。当类加载检查通过后,Java 虚拟机开始为新生对象分配内存。如果 Java 堆中内存是绝对规整的,所有被使用过的的内存都被放到一边,空闲的内存放到另外一边,中间放着一个指针作为分界点的指示器,所分配内存仅仅是把那个指针向空闲空间方向挪动一段与对象大小相等的实例,这种分配方式就是 指针碰撞。

26、什么是空闲列表?

如果 Java 堆内存中的内存并不是规整的,已被使用的内存和空闲的内存相互交错在一起,不可以进行指针碰撞啦,虚拟机必须维护一个列表,记录哪些内存是可用的,在分配的时候从列表找到一块大的空间分配给对象实例,并更新列表上的记录,这种分配方式就是空闲列表。

27、什么是 TLAB ?

可以把内存分配的动作按照线程划分在不同的空间之中进行,每个线程在 Java 堆中预先分配一小块内存,这就是 TLAB(Thread Local Allocation Buffer,本地线程分配缓存) 。虚拟机通过 -XX:UseTLAB 设定它的。

28、对象头具体都包含哪些内容?

在我们常用的 Hotspot 虚拟机中,对象在内存中布局实际包含 3 个部分:

对象头

实例数据

对齐填充

而对象头包含两部分内容,Mark Word 中的内容会随着锁标志位而发生变化,所以只说存储结构就好了。

对象自身运行时所需的数据,也被称为 Mark Word,也就是用于轻量级锁和偏向锁的关键点。具体的内容包含对象的 hashcode、分代年龄、轻量级锁指针、重量级锁指针、GC 标记、偏向锁线程 ID、偏向锁时间戳。

存储类型指针,也就是指向类的元数据的指针,通过这个指针才能确定对象是属于哪个类的实例。

如果是数组的话,则还包含了数组的长度。

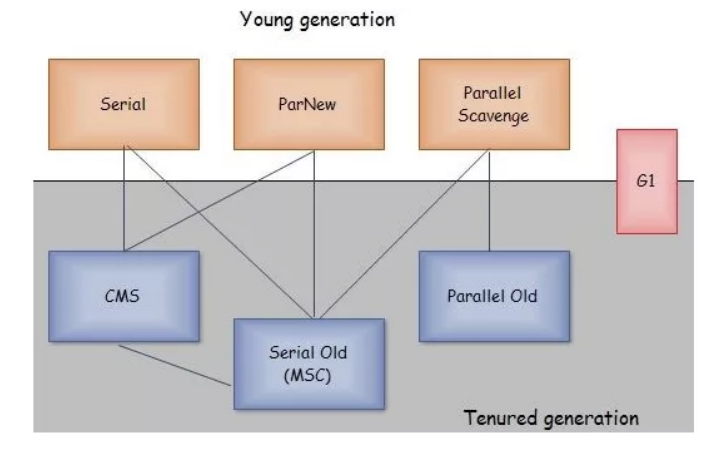

29、说一下 JVM 有哪些垃圾回收器?

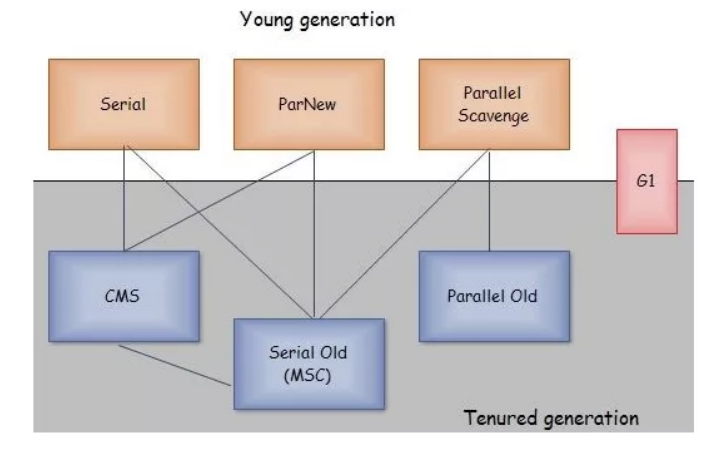

如果说垃圾收集算法是内存回收的方法论,那么垃圾收集器就是内存回收的具体实现。下图展示了 7 种作用于不同分代的收集器,其中用于回收新生代的收集器包括 Serial、PraNew、Parallel Scavenge,回收老年代的收集器包括 Serial Old、Parallel Old、CMS,还有用于回收整个 Java 堆的 G1收集器。不同收集器之间的连线表示它们可以搭配使用。

Serial 收集器(复制算法):新生代单线程收集器,标记和清理都是单线程,优点是简单高效;

ParNew 收集器 (复制算法) :新生代收并行集器,实际上是 Serial 收集器的多线程版本,在多核 CPU 环境下有着比 Serial 更好的表现;

Parallel Scavenge 收集器(复制算法):新生代并行收集器,追求高吞吐量,高效利用 CPU。吞吐量 = 用户线程时间 /(用户线程时间 + GC 线程时间),高吞吐量可以高效率的利用 CPU 时间,尽快完成程序的运算任务,适合后台应用等对交互相应要求不高的场景;

Serial Old 收集器 (标记 - 整理算法): 老年代单线程收集器,Serial 收集器的老年代版本;

Parallel Old 收集器(标记 - 整理算法): 老年代并行收集器,吞吐量优先,Parallel Scavenge 收集器的老年代版本;

CMS( Concurrent Mark Sweep )收集器(标记 - 清除算法): 老年代并行收集器,以获取最短回收停顿时间为目标的收集器,具有高并发、低停顿的特点,追求最短 GC 回收停顿时间。

G1( Garbage First )收集器(标记 - 整理算法): Java 堆并行收集器,G1 收集器是 JDK 1.7 提供的一个新收集器,G1 收集器基于“标记 - 整理”算法实现,也就是说不会产生内存碎片。此外,G1 收集器不同于之前的收集器的一个重要特点是:G1 回收的范围是整个 Java堆(包括新生代,老年代),而前六种收集器回收的范围仅限于新生代或老年代。

ZGC ( Z Garbage Collector )是一款由 Oracle 公司研发的,以低延迟为首要目标的一款垃圾收集器。它是基于动态 Region 内存布局,(暂时)不设年龄分代,使用了读屏障、染色指针和内存多重映射等技术来实现可并发的标记 - 整理算法的收集器。在 JDK 11 新加入,还在实验阶段,主要特点是:回收 TB 级内存(最大 4 T ),停顿时间不超过 10 ms。优点:低停顿,高吞吐量, ZGC 收集过程中额外耗费的内存小。缺点:浮动垃圾目前使用的非常少,真正普及还是需要写时间的。

新生代收集器:Serial、 ParNew 、 Parallel Scavenge

老年代收集器:CMS 、Serial Old、Parallel Old

整堆收集器:G1 ,ZGC (因为不涉年代不在图中)

30、如何选择垃圾收集器?

如果你的堆大小不是很大(比如 100 MB ),选择串行收集器一般是效率最高的。

参数: -XX:+UseSerialGC 。

如果你的应用运行在单核的机器上,或者你的虚拟机核数只有单核,选择串行收集器依然是合适的,这时候启用一些并行收集器没有任何收益。

参数: -XX:+UseSerialGC 。

如果你的应用是“吞吐量”优先的,并且对较长时间的停顿没有什么特别的要求。选择并行收集器是比较好的。

参数: -XX:+UseParallelGC 。

如果你的应用对响应时间要求较高,想要较少的停顿。甚至 1 秒的停顿都会引起大量的请求失败,那么选择 G1 、ZGC 、CMS 都是合理的。虽然这些收集器的 GC 停顿通常都比较短,但它需要一些额外的资源去处理这些工作,通常吞吐量会低一些。

参数:

-XX:+UseConcMarkSweepGC 、

-XX:+UseG1GC 、

-XX:+UseZGC 等。

从上面这些出发点来看,我们平常的 Web 服务器,都是对响应性要求非常高的。选择性其实就集中在 CMS 、 G1 、 ZGC 上。而对于某些定时任务,使用并行收集器,是一个比较好的选择。

31、 什么是类加载器?

类加载器是一个用来加载类文件的类。Java 源代码通过 javac 编译器编译成类文件。然后 JVM 来执行类文件中的字节码来执行程序。类加载器负责加载文件系统、网络或其他来源的类文件。

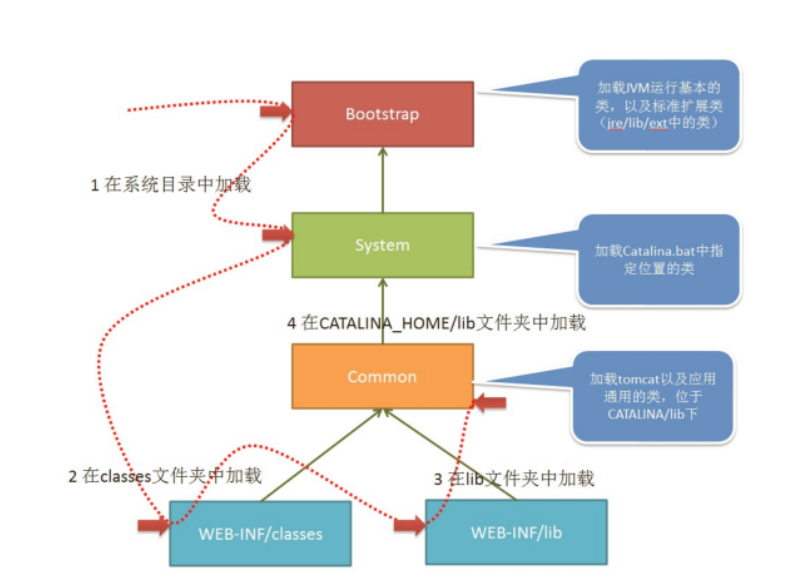

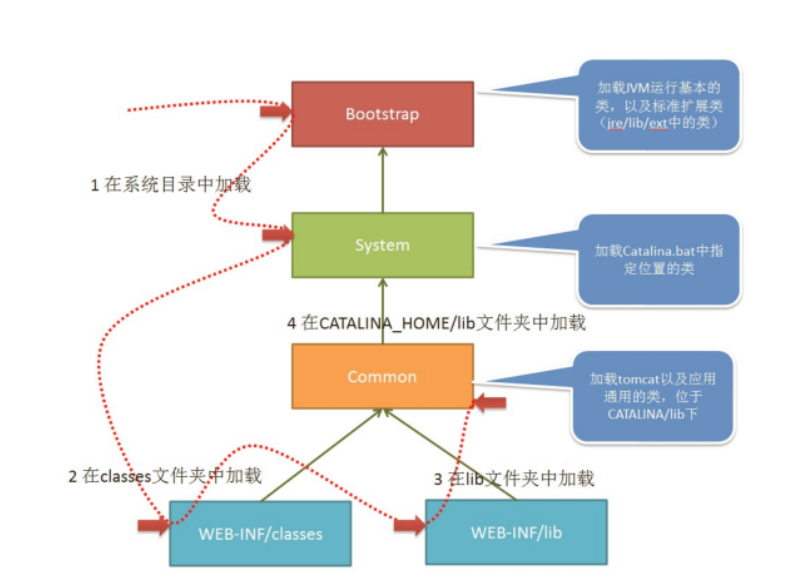

32、什么是 tomcat 类加载机制?

在 tomcat 中类的加载稍有不同,如下图:

当 tomcat 启动时,会创建几种类加载器: Bootstrap 引导类加载器 加载 JVM 启动所需的类,以及标准扩展类(位于 jre/lib/ext 下) System 系统类加载器 加载 tomcat 启动的类,比如 bootstrap.jar,通常在 catalina.bat 或者 catalina.sh 中指定。位于 CATALINA_HOME/bin 下。

Common 通用类加载器

多线程 & 并发篇

1、说说 Java 中实现多线程有几种方法

剖其底层 Runnable

创建线程的常用四种方式:

- 继承 Thread 类,重写 run 方法

- 实现 Runnable 接口,重写 run 方法

- 实现 Callable 接口( JDK 1.5 >= ),重写 call 方法,配合 FutureTask(有返回结果的非阻塞执行)

- 线程池方式创建

lambda 方式

1 | Thread t2 = new Thread(()->{ |

通过继承 Thread 类或者实现 Runnable 接口、Callable 接口都可以实现多线程,不过实现 Runnable 接口与实现 Callable 接口的方式基本相同,只是 Callable 接口里定义的方法返回值,可以声明抛出异常而已。因此将实现 Runnable 接口和实现 Callable 接口归为一种方式。这种方式与继承 Thread 方式之间的主要差别如下。

采用实现 Runnable、Callable 接口的方式创建线程的优缺点

优点:线程类只是实现了 Runnable 或者 Callable 接口,还可以继承其他类。这种方式下,多个线程可以共享一个 target 对象,所以非常适合多个相同线程来处理同一份资源的情况,从而可以将 CPU、代码和数据分开,形成清晰的模型,较好的体现了面向对象的思想。

缺点:编程稍微复杂一些,如果需要访问当前线程,则必须使用 Thread.currentThread() 方法

采用继承 Thread 类的方式创建线程的优缺点

优点:编写简单,如果需要访问当前线程,则无需使用 Thread.currentThread() 方法,直接使用 this 即可获取当前线程

缺点:因为线程类已经继承了 Thread 类,Java 语言是单继承的,所以就不能再继承其他父类了。

2、如何停止一个正在运行的线程

1、使用退出标志,使线程正常退出,也就是当 run 方法完成后线程终止。

2、使用 stop 方法强行终止,但是不推荐这个方法,因为 stop 和 suspend 及 resume 一样都是过期作废的方法。

3、使用 interrupt 方法中断线程。

1 | class MyThread extends Thread { |

3、notify() 和 notifyAll() 有什么区别?

notify 可能会导致死锁,而 notifyAll 则不会

任何时候只有一个线程可以获得锁,也就是说只有一个线程可以运行 synchronized 中的代码使用 notifyAll,可以唤醒所有处于 wait 状态的线程,使其重新进入锁的争夺队列中,而 notify 只能唤醒一个。

wait() 应配合 while 循环使用,不应使用 if,务必在 wait() 调用前后都检查条件,如果不满足,必须调用 notify() 唤醒另外的线程来处理,自己继续 wait() 直至条件满足再往下执行。

notify() 是对 notifyAll() 的一个优化,但它有很精确的应用场景,并且要求正确使用。不然可能导致死锁。正确的场景应该是 WaitSet 中等待的是相同的条件,唤醒任一个都能正确处理接下来的事项,如果唤醒的线程无法正确处理,务必确保继续 notify() 下一个线程,并且自身需要重新回到 WaitSet 中.

4、sleep() 和 wait() 有什么区别?

对于 sleep() 方法,我们首先要知道该方法是属于 Thread 类中的。而 wait() 方法,则是属于 Object 类中的。

sleep() 方法导致了程序暂停执行指定的时间,让出 cpu 该其他线程,但是他的监控状态依然保持者,当指定的时间到了又会自动恢复运行状态。在调用 sleep() 方法的过程中,线程不会释放对象锁。

当调用 wait() 方法的时候,线程会放弃对象锁,进入等待此对象的等待锁定池,只有针对此对象调用 notify() 方法后本线程才进入对象锁定池准备,获取对象锁进入运行状态。

5、volatile 是什么?可以保证有序性吗?

一旦一个共享变量(类的成员变量、类的静态成员变量)被 volatile 修饰之后,那么就具备了两层语义:

1)保证了不同线程对这个变量进行操作时的可见性,即一个线程修改了某个变量的值,这新值对其他线程来说是立即可见的,volatile 关键字会强制将修改的值立即写入主存。

2)禁止进行指令重排序。

volatile 不是原子性操作

什么叫保证部分有序性?

当程序执行到 volatile 变量的读操作或者写操作时,在其前面的操作的更改肯定全部已经进行,且结果已经对后面的操作可见;在其后面的操作肯定还没有进行;

1 | x = 2; //语句1 |

由于 flag 变量为 volatile 变量,那么在进行指令重排序的过程的时候,不会将语句 3 放到语句 1、语句 2 前面,也不会将语句 3 放到语句4、语句 5 后面。但是要注意语句 1 和语句 2 的顺序、语句 4 和语句 5 的顺序是不作任何保证的。

使用 volatile 一般用于状态标记量和单例模式的双检锁。

6、Thread 类中的 start() 和 run() 方法有什么区别?

start() 方法被用来启动新创建的线程,而且 start() 内部调用了 run() 方法,这和直接调用 run() 方法的效果不一样。当你调用 run() 方法的时候,只会是在原来的线程中调用,没有新的线程启动,start() 方法才会启动新线程。

7、为什么 wait,notify 和 notifyAll 这些方法不在 thread 类里面?

明显的原因是 JAVA 提供的锁是对象级的而不是线程级的,每个对象都有锁,通过线程获得。如果线程需要等待某些锁那么调用对象中的wait() 方法就有意义了。如果 wait() 方法定义在 Thread 类中,线程正在等待的是哪个锁就不明显了。简单的说,由于 wait,notify 和notifyAll 都是锁级别的操作,所以把他们定义在 Object 类中因为锁属于对象。

8、为什么 wait 和 notify 方法要在同步块中调用?

只有在调用线程拥有某个对象的独占锁时,才能够调用该对象的 wait(),notify() 和 notifyAll() 方法。

如果你不这么做,你的代码会抛出 IllegalMonitorStateException 异常。

还有一个原因是为了避免 wait 和 notify 之间产生竞态条件。

wait() 方法强制当前线程释放对象锁。这意味着在调用某对象的 wait() 方法之前,当前线程必须已经获得该对象的锁。因此,线程必须在某个对象的同步方法或同步代码块中才能调用该对象的 wait() 方法。

在调用对象的 notify() 和 notifyAll() 方法之前,调用线程必须已经得到该对象的锁。因此,必须在某个对象的同步方法或同步代码块中才能调用该对象的 notify() 或 notifyAll() 方法。

调用 wait() 方法的原因通常是,调用线程希望某个特殊的状态(或变量)被设置之后再继续执行。调用 notify() 或 notifyAll() 方法的原因通常是,调用线程希望告诉其他等待中的线程:”特殊状态已经被设置”。这个状态作为线程间通信的通道,它必须是一个可变的共享状态(或变量)

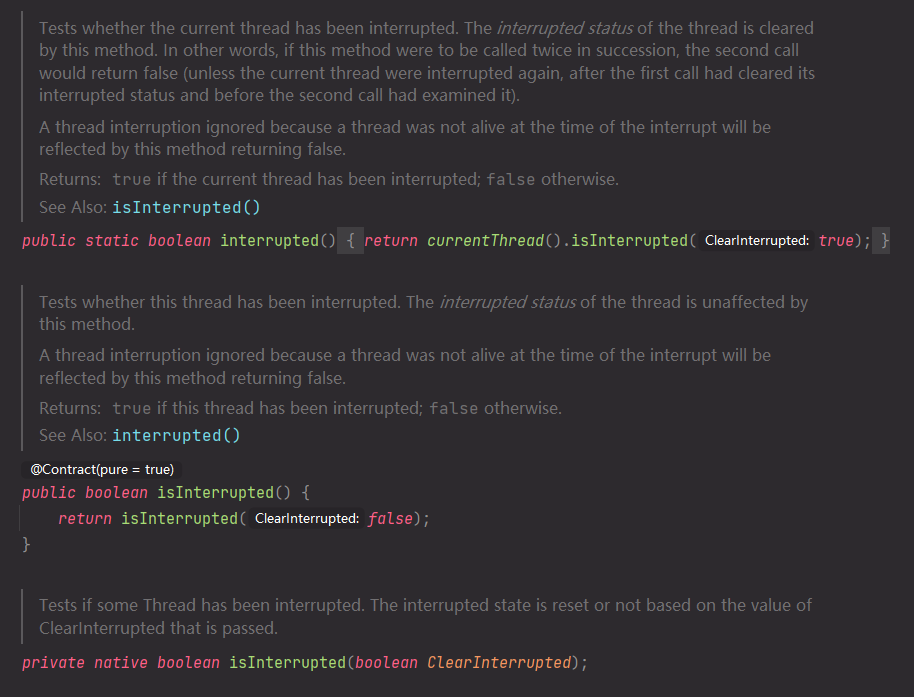

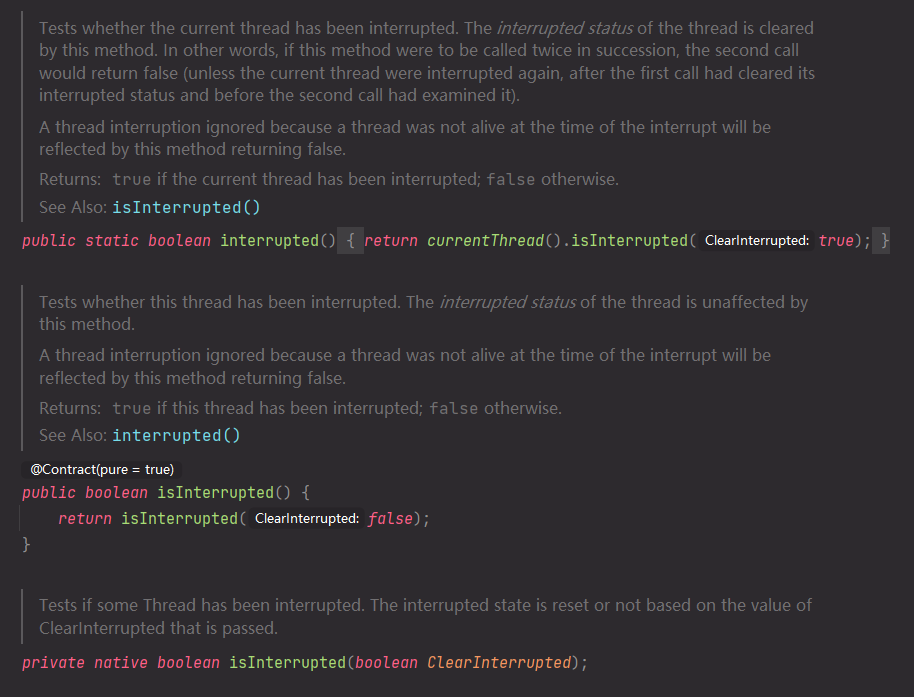

9、Java 中 interrupted 和 isInterrupted 方法的区别?

interrupted() 和 isInterrupted() 的主要区别是前者会将中断状态清除而后者不会。Java 多线程的中断机制是用内部标识来实现的,调用Thread.interrupt() 来中断一个线程就会设置中断标识为 true。当中断线程调用静态方法 Thread.interrupted() 来检查中断状态时,中断状态会被清零。而非静态方法 isInterrupted() 用来查询其它线程的中断状态且不会改变中断状态标识。简单的说就是任何抛出InterruptedException 异常的方法都会将中断状态清零。无论如何,一个线程的中断状态有有可能被其它线程调用中断来改变。

10、Java 中 synchronized 和 ReentrantLock 有什么不同?

相似点:

这两种同步方式有很多相似之处,它们都是加锁方式同步,而且都是阻塞式的同步,也就是说当如果一个线程获得了对象锁,进入了同步块,其他访问该同步块的线程都必须阻塞在同步块外面等待,而进行线程阻塞和唤醒的代价是比较高的.

区别:

这两种方式最大区别就是对于 Synchronized 来说,它是 java 语言的关键字,是原生语法层面的互斥,需要 jvm 实现。而 ReentrantLock 它是 JDK 1.5 之后提供的 API 层面的互斥锁,需要 lock() 和 unlock() 方法配合 try / finally 语句块来完成。

Synchronized 进过编译,会在同步块的前后分别形成 monitorenter 和 monitorexit 这个两个字节码指令。在执行 monitorenter 指令时,首先要尝试获取对象锁。如果这个对象没被锁定,或者当前线程已经拥有了那个对象锁,把锁的计算器加 1,相应的,在执行monitorexit 指令时会将锁计算器就减 1,当计算器为 0 时,锁就被释放了。如果获取对象锁失败,那当前线程就要阻塞,直到对象锁被另一个线程释放为止。

由于 ReentrantLock 是 java.util.concurrent 包下提供的一套互斥锁,相比 Synchronized,ReentrantLock 类提供了一些高级功能,主要有以下3项:

1.等待可中断,持有锁的线程长期不释放的时候,正在等待的线程可以选择放弃等待,这相当于Synchronized 来说可以避免出现死锁的情况。

2.公平锁,多个线程等待同一个锁时,必须按照申请锁的时间顺序获得锁,Synchronized 锁非公平锁,ReentrantLock 默认的构造函数是创建的非公平锁,可以通过参数 true 设为公平锁,但公平锁表现的性能不是很好。

3.锁绑定多个条件,一个 ReentrantLock 对象可以同时绑定多个对象。

11、有三个线程 T1、T2、T3 如何保证顺序执行?

在多线程中有多种方法让线程按特定顺序执行,你可以用线程类的 join() 方法在一个线程中启动另一个线程,另外一个线程完成该线程继续执行。为了确保三个线程的顺序你应该先启动最后一个( T3 调用 T2,T2调用 T1),这样 T1 就会先完成而 T3 最后完成。

实际上先启动三个线程中哪一个都行, 因为在每个线程的run方法中用join方法限定了三个线程的执行顺序。

1 | public class JoinTest2 { |

12、SynchronizedMap 和 ConcurrentHashMap 有什么区别?

SynchronizedMap() 和 Hashtable 一样,实现上在调用 map 所有方法时,都对整个 map 进行同步。而 ConcurrentHashMap 的实现却更加精细,它对 map 中的所有桶加了锁。所以,只要有一个线程访问 map,其他线程就无法进入 map,而如果一个线程在访问ConcurrentHashMap 某个桶时,其他线程,仍然可以对 map 执行某些操作。

所以,ConcurrentHashMap 在性能以及安全性方面,明显比 Collections.synchronizedMap() 更加有优势。同时,同步操作精确控制到桶,这样,即使在遍历 map 时,如果其他线程试图对 map 进行数据修改,也不会抛出 ConcurrentModificationException。

13、什么是线程安全

线程安全就是说多线程访问同一段代码,不会产生不确定的结果。

又是一个理论的问题,各式各样的答案有很多,我给出一个个人认为解释地最好的:如果你的代码在多线程下执行和在单线程下执行永远都能获得一样的结果,那么你的代码就是线程安全的。

这个问题有值得一提的地方,就是线程安全也是有几个级别的:

(1)不可变

像 String、Integer、Long 这些,都是 final 类型的类,任何一个线程都改变不了它们的值,要改变除非新创建一个,因此这些不可变对象不需要任何同步手段就可以直接在多线程环境下使用

(2)绝对线程安全

不管运行时环境如何,调用者都不需要额外的同步措施。要做到这一点通常需要付出许多额外的代价,Java 中标注自己是线程安全的类,实际上绝大多数都不是线程安全的,不过绝对线程安全的类,Java 中也有,比方说 CopyOnWriteArrayList、CopyOnWriteArraySet

(3)相对线程安全

相对线程安全也就是我们通常意义上所说的线程安全,像 Vector 这种,add、remove 方法都是原子操作,不会被打断,但也仅限于此,如果有个线程在遍历某个 Vector、有个线程同时在 add 这个 Vector,99 % 的情况下都会出现 ConcurrentModificationException,也就是fail-fast 机制。

(4)线程非安全

这个就没什么好说的了,ArrayList、LinkedList、HashMap 等都是线程非安全的类

14、Thread 类中的 yield 方法有什么作用?

Yield 方法可以暂停当前正在执行的线程对象,让其它有相同优先级的线程执行。它是一个静态方法而且只保证当前线程放弃 CPU 占用而不能保证使其它线程一定能占用 CPU,执行 yield() 的线程有可能在进入到暂停状态后马上又被执行。

15、Java 线程池中 submit() 和 execute() 方法有什么区别?

两个方法都可以向线程池提交任务,execute() 方法的返回类型是 void,它定义在 Executor 接口,b而 submit() 方法可以返回持有计算结果的 Future 对象,它定义在 ExecutorService 接口中,它扩展了 Executor 接口,其它线程池类像 ThreadPoolExecutor 和ScheduledThreadPoolExecutor 都有这些方法。

16、说一说自己对于 synchronized 关键字的了解

synchronized 关键字解决的是多个线程之间访问资源的同步性,synchronized 关键字可以保证被它修饰的方法或者代码块在任意时刻只能有一个线程执行。 另外,在 Java 早期版本中,synchronized 属于重量级锁,效率低下,因为监视器锁(monitor)是依赖于底层的操作系统的 Mutex Lock 来实现的,Java 的线程是映射到操作系统的原生线程之上的。如果要挂起或者唤醒一个线程,都需要操作系统帮忙完成,而操作系统实现线程之间的切换时需要从用户态转换到内核态,这个状态之间的转换需要相对比较长的时间,时间成本相对较高,这也是为什么早期的 synchronized 效率低的原因。庆幸的是在 Java 6 之后 Java 官方对从 JVM 层面对 synchronized 做了较大优化,所以现在的 synchronized 锁效率也优化得很不错了。JDK1.6 对锁的实现引入了大量的优化,如自旋锁、适应性自旋锁、锁消除、锁粗化、偏向锁、轻量级锁等技术来减少锁操作的开销。

17、说说自己是怎么使用 synchronized 关键字?

修饰实例方法::作用于当前对象实例加锁,进入同步代码前要获得当前对象实例的锁

修饰静态方法:也就是给当前类加锁,会作用于类的所有对象实例,因为静态成员不属于任何一个实例对象,是类成员( static 表明这是该类的一个静态资源,不管 new 了多少个对象,只有一份)。所以如果一个线程 A 调用一个实例对象的非静态 synchronized 方法,而线程 B 需要调用这个实例对象所属类的静态 synchronized 方法,是允许的,不会发生互斥现象,因为访问静态 synchronized 方法占用的锁是当前类的锁,而访问非静态 synchronized **方法占用的锁是当前实例对象锁。 **

修饰代码块:指定加锁对象,对给定对象加锁,进入同步代码库前要获得给定对象的锁。

总结: synchronized 关键字加到 static 静态方法和 synchronized(class) 代码块上都是是给 Class 类上锁。synchronized 关键字加到实例方法上是给对象实例上锁。尽量不要使用 synchronized(String a) 因为 JVM 中,字符串常量池具有缓存功能!会导致加锁在同一个对象,必然会阻塞

18、什么是线程安全?Vector 是一个线程安全类吗?

如果你的代码所在的进程中有多个线程在同时运行,而这些线程可能会同时运行这段代码。如果每次运行结果和单线程运行的结果是一样的,而且其他的变量的值也和预期的是一样的,就是线程安全的。一个线程安全的计数器类的同一个实例对象在被多个线程使用的情况下也不会出现计算失误。很显然你可以将集合类分成两组,线程安全和非线程安全的。Vector 是用同步方法来实现线程 安全的, 而和它相似的 ArrayList 不是线程安全的。

19、volatile 关键字的作用?

一旦一个共享变量(类的成员变量、类的静态成员变量)被 volatile 修饰之后,那么就具备了两层语义:

保证了不同线程对这个变量进行操作时的可见性,即一个线程修改了某个变量的值,这新值对其他线程来说是立即可见的。

禁止进行指令重排序。

volatile 与 synchronized 区别(5 个):

volatile 本质是在告诉 jvm 当前变量在寄存器(工作内存)中的值是不确定的,需要从主存中读取;

synchronized 则是锁定当前变量,只有当前线程可以访问该变量,其他线程被阻塞住。

volatile 仅能使用在变量级别;

synchronized 则可以使用在变量、方法、和类级别的。

volatile 仅能实现变量的修改可见性,并不能保证原子性;

synchronized 则可以保证变量的修改可见性和原子性。

volatile 不会造成线程的阻塞;

synchronized 可能会造成线程的阻塞。

volatile 标记的变量不会被编译器优化;

synchronized标记的变量可以被编译器优化。

20、常用的线程池有哪些?

newSingleThreadExecutor:创建一个单线程的线程池,此线程池保证所有任务的执行顺序按照任务的提交顺序执行。

newFixedThreadPool:创建固定大小的线程池,它的核心线程数和最大线程数是一样的,每次提交一个任务就创建一个线程,直到线程达到线程池的最大大小。

newCachedThreadPool:创建一个可缓存的线程池,它的特点就是可以无限的缓存线程任务,最大可以达到 Integer.MAX_VALUE,为 2^31-1,此线程池不会对线程池大小做限制,线程池大小完全依赖于操作系统(或者说JVM)能够创建的最大线程大小。

newScheduledThreadPool:创建一个大小无限的线程池,此线程池支持定时以及周期性执行任务的需求。

newSingleThreadScheduledExecutor:创建一个单线程的线程池。此线程池支持定时以及周期性执行任务的需求

21、简述一下你对线程池的理解

(如果问到了这样的问题,可以展开的说一下线程池如何用、线程池的好处、线程池的启动策略)

合理利用线程池能够带来三个好处。

第一:降低资源消耗。通过重复利用已创建的线程降低线程创建和销毁造成的消耗。

第二:提高响应速度。当任务到达时,任务可以不需要等到线程创建就能立即执行。

第三:提高线程的可管理性。线程是稀缺资源,如果无限制的创建,不仅会消耗系统资源,还会降低系统的稳定性,使用线程池可以进行统一的分配,调优和监控。

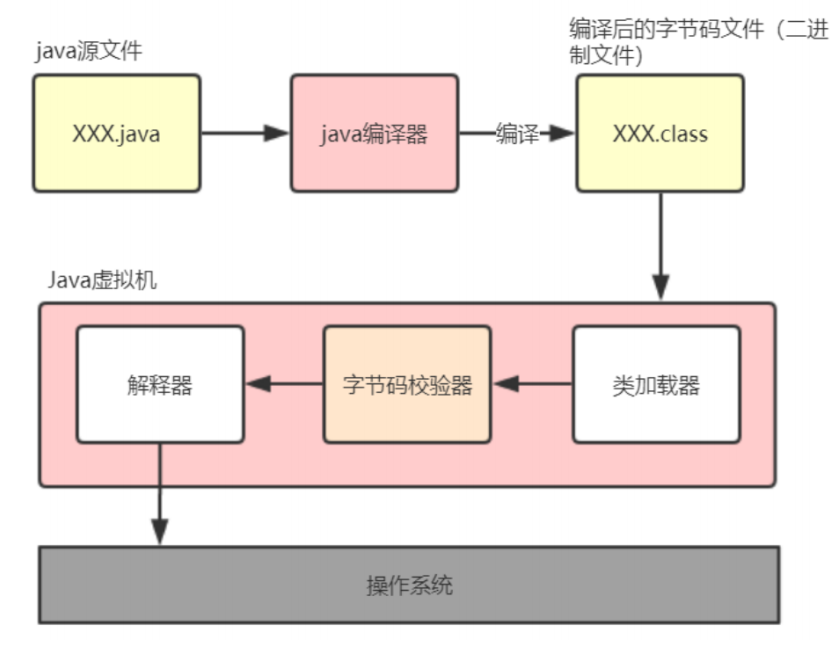

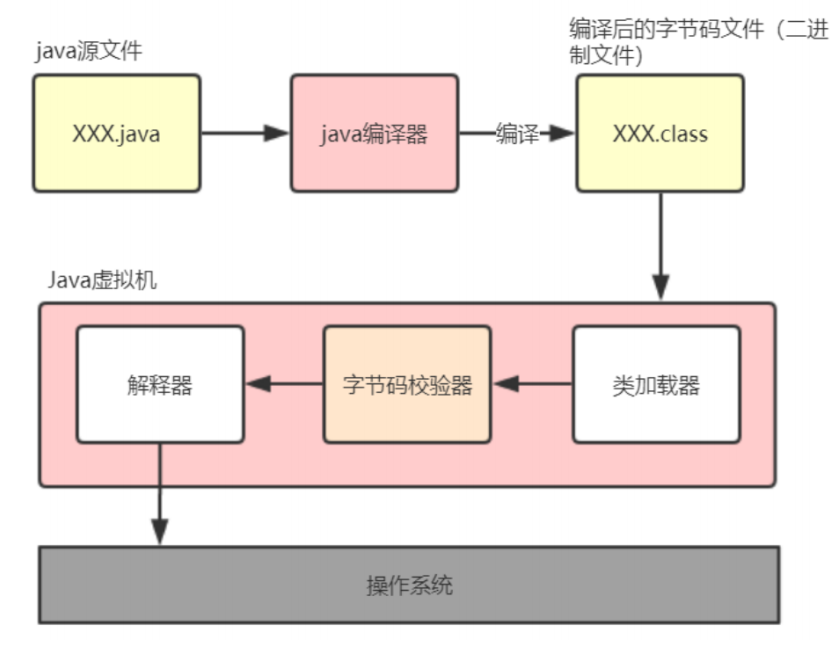

22、Java 程序是如何执行的

我们日常的工作中都使用开发工具(IntelliJ IDEA 或 Eclipse 等)可以很方便的调试程序,或者是通过打包工具把项目打包成 jar 包或者 war 包,放入 Tomcat 等 Web 容器中就可以正常运行了,但你有没有想过 Java 程序内部是如何执行的?其实不论是在开发工具中运行还是在 Tomcat 中运行,Java 程序的执行流程基本都是相同的,它的执行流程如下:

先把 Java 代码编译成字节码,也就是把 .java 类型的文件编译成 .class 类型的文件。这个过程的大致执行流程:Java 源代码 -> 词法分析器 -> 语法分析器 -> 语义分析器 -> 字符码生成器 ->最终生成字节码,其中任何一个节点执行失败就会造成编译失败;

把 class 文件放置到 Java 虚拟机,这个虚拟机通常指的是 Oracle 官方自带的 Hotspot JVM;

Java 虚拟机使用类加载器(Class Loader)装载 class 文件;

类加载完成之后,会进行字节码效验,字节码效验通过之后 JVM 解释器会把字节码翻译成机器码交由操作系统执行。但不是所有代码都是解释执行的,JVM 对此做了优化,比如,以 Hotspot 虚拟机来说,它本身提供了 JIT(Just In Time)也就是我们通常所说的动态编译器,它能够在运行时将热点代码编译为机器码,这个时候字节码就变成了编译执行。Java 程序执行流程图如下:

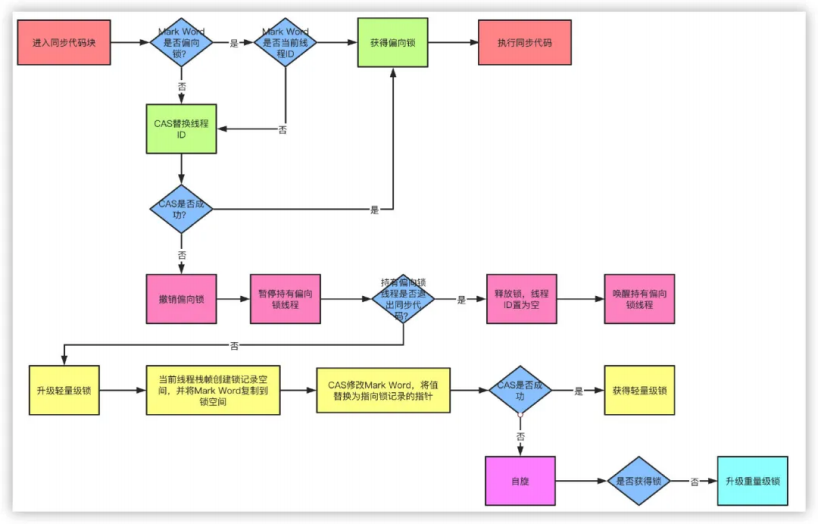

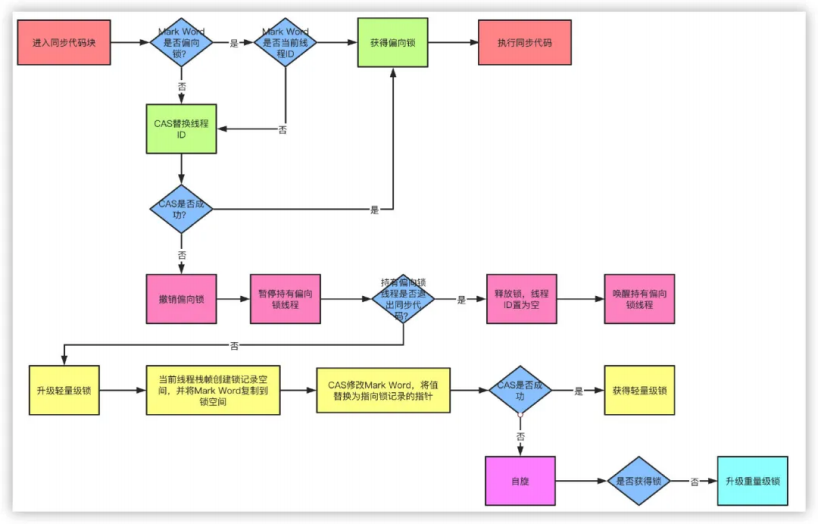

23、锁的优化机制了解吗?

从 JDK 1.6 版本之后,synchronized 本身也在不断优化锁的机制,有些情况下他并不会是一个很重量级的锁了。优化机制包括自适应锁、自旋锁、锁消除、锁粗化、轻量级锁和偏向锁。

锁的状态从低到高依次为 无锁 -> 偏向锁 -> 轻量级锁 -> 重量级锁,升级的过程就是从低到高,降级在一定条件也是有可能发生的。

自旋锁:由于大部分时候,锁被占用的时间很短,共享变量的锁定时间也很短,所有没有必要挂起线程,用户态和内核态的来回上下文切换严重影响性能。自旋的概念就是让线程执行一个忙循环,可以理解为就是啥也不干,防止从用户态转入内核态,自旋锁可以通过设置 -XX:+UseSpining 来开启,自旋的默认次数是 10 次,可以使用 -XX:PreBlockSpin 设置。

自适应锁:自适应锁就是自适应的自旋锁,自旋的时间不是固定时间,而是由前一次在同一个锁上的自旋时间和锁的持有者状态来决定。

锁消除:锁消除指的是 JVM 检测到一些同步的代码块,完全不存在数据竞争的场景,也就是不需要加锁,就会进行锁消除。

锁粗化:锁粗化指的是有很多操作都是对同一个对象进行加锁,就会把锁的同步范围扩展到整个操作序列之外。

偏向锁:当线程访问同步块获取锁时,会在对象头和栈帧中的锁记录里存储偏向锁的线程 ID,之后这个线程再次进入同步块时都不需要CAS 来加锁和解锁了,偏向锁会永远偏向第一个获得锁的线程,如果后续没有其他线程获得过这个锁,持有锁的线程就永远不需要进行同步,反之,当有其他线程竞争偏向锁时,持有偏向锁的线程就会释放偏向锁。可以用过设置 -XX:+UseBiasedLocking 开启偏向锁。

轻量级锁:JVM 的对象的对象头中包含有一些锁的标志位,代码进入同步块的时候,JVM 将会使用 CAS 方式来尝试获取锁,如果更新成功则会把对象头中的状态位标记为轻量级锁,如果更新失败,当前线程就尝试自旋来获得锁。整个锁升级的过程非常复杂,我尽力去除一些无用的环节,简单来描述整个升级的机制。简单点说,偏向锁就是通过对象头的偏向线程 ID 来对比,甚至都不需要 CAS 了,而轻量级锁主要就是通过 CAS 修改对象头锁记录和自旋来实现,重量级锁则是除了拥有锁的线程其他全部阻塞。

24、说说进程和线程的区别?

进程是一个“执行中的程序”,是系统进行资源分配和调度的一个独立单位。

线程是进程的一个实体,一个进程中拥有多个线程,线程之间共享地址空间和其它资源(所以通信和同步等操作线程比进程更加容易)

线程上下文的切换比进程上下文切换要快很多。

(1)进程切换时,涉及到当前进程的 CPU 环境的保存和新被调度运行进程的 CPU 环境的设置。

(2)线程切换仅需要保存和设置少量的寄存器内容,不涉及存储管理方面的操作。

25、产生死锁的四个必要条件?

- 互斥条件:一个资源每次只能被一个线程使用

- 请求与保持条件:一个线程因请求资源而阻塞时,对已获得的资源保持不放

- 不剥夺条件:进程已经获得的资源,在未使用完之前,不能强行剥夺

- 循环等待条件:若干线程之间形成一种头尾相接的循环等待资源关系

26、如何避免死锁?

指定获取锁的顺序,举例如下:

- 比如某个线程只有获得 A 锁和 B 锁才能对某资源进行操作,在多线程条件下,如何避免死锁?

- 获得锁的顺序是一定的,比如规定,只有获得 A 锁的线程才有资格获取 B 锁,按顺序获取锁就可以避免死锁!!!

27、线程池核心线程数怎么设置呢?

分为 CPU 密集型和 IO 密集型

CPU

这种任务消耗的主要是 CPU 资源,可以将线程数设置为 N(CPU 核心数)+1,比 CPU 核心数多出来的一个线程是为了防止线程偶发的缺页中断,或者其它原因导致的任务暂停而带来的影响。一旦任务暂停,CPU 就会处于空闲状态,而在这种情况下多出来的一个线程就可以充分利用 CPU 的空闲时间。

IO 密集型

这种任务应用起来,系统会用大部分的时间来处理 I/O 交互,而线程在处理 I/O 的时间段内不会占用 CPU 来处理,这时就可以将 CPU 交出给其它线程使用。因此在 I/O 密集型任务的应用中,我们可以多配置一些线程,具体的计算方法是:核心线程数 = CPU 核心数量 * 2。

28、Java 线程池中队列常用类型有哪些?

ArrayBlockingQueue 是一个基于数组结构的 有界阻塞队列,此队列按 FIFO(先进先出)原则对元素进行排序。

LinkedBlockingQueue 一个基于链表结构的 阻塞队列,此队列按 FIFO(先进先出) 排序元素,吞吐量通常要高于 ArrayBlockingQueue 。

SynchronousQueue 一个不存储元素的 阻塞队列。

PriorityBlockingQueue 一个具有优先级的 无限阻塞队列。PriorityBlockingQueue 也是 基于最小二叉堆实现

DelayQueue

- 只有当其指定的延迟时间到了,才能够从队列中获取到该元素。

- DelayQueue 是一个没有大小限制的队列,

- 因此往队列中插入数据的操作(生产者)永远不会被阻塞,而只有获取数据的操作(消费者)才会被阻塞。

这里能说出前三种也就差不多了,如果能说全那是最好。

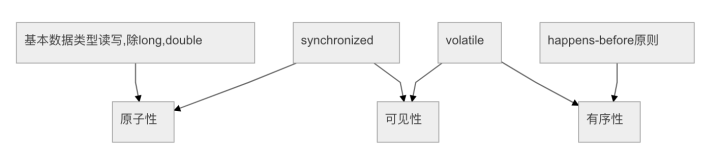

29、线程安全需要保证几个基本特征?

原子性,简单说就是相关操作不会中途被其他线程干扰,一般通过同步机制实现。

可见性,是一个线程修改了某个共享变量,其状态能够立即被其他线程知晓,通常被解释为将线程本地状态反映到主内存上,volatile 就是负责保证可见性的。

有序性,是保证线程内串行语义,避免指令重排等。

30、说一下线程之间是如何通信的?

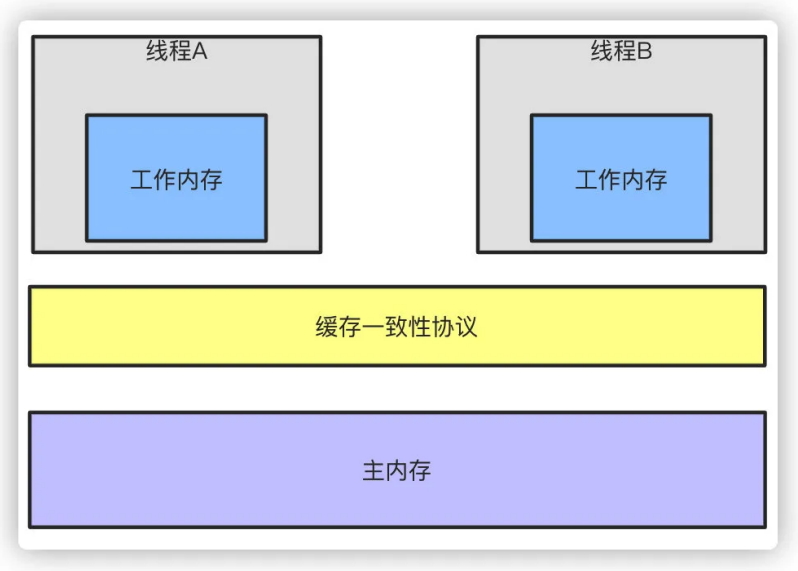

线程之间的通信有两种方式:共享内存和消息传递。

共享内存

在共享内存的并发模型里,线程之间共享程序的公共状态,线程之间通过写-读内存中的公共状态来隐式进行通信。典型的共享内存通信方式,就是通过共享对象进行通信。

例如上图线程 A 与 线程 B 之间如果要通信的话,那么就必须经历下面两个步骤:

- 线程 A 把本地内存 A 更新过得共享变量刷新到主内存中去。

- 线程 B 到主内存中去读取线程 A 之前更新过的共享变量。

消息传递

在消息传递的并发模型里,线程之间没有公共状态,线程之间必须通过明确的发送消息来显式进行通信。在 Java 中典型的消息传递方式,就是 wait() 和 notify() ,或者 BlockingQueue 。

31、CAS 的原理呢?

CAS 叫做 CompareAndSwap,比较并交换,主要是通过处理器的指令来保证操作的原子性,它包含三个操作数:

- 变量内存地址,V 表示

- 旧的预期值,A 表示

- 准备设置的新值,B 表示

当执行 CAS 指令时,只有当 V 等于 A 时,才会用 B 去更新 V 的值,否则就不会执行更新操作。

32、CAS 有什么缺点吗?

CAS 的缺点主要有 3 点:

ABA 问题:ABA 的问题指的是在 CAS 更新的过程中,当读取到的值是 A,然后准备赋值的时候仍然是 A,但是实际上有可能 A 的值被改成了 B,然后又被改回了 A,这个 CAS 更新的漏洞就叫做 ABA。只是 ABA 的问题大部分场景下都不影响并发的最终效果。

Java 中有 AtomicStampedReference 来解决这个问题,他加入了预期标志和更新后标志两个字段,更新时不光检查值,还要检查当前的标志是否等于预期标志,全部相等的话才会更新。

循环时间长开销大:自旋 CAS 的方式如果长时间不成功,会给 CPU 带来很大的开销。

只能保证一个共享变量的原子操作:只对一个共享变量操作可以保证原子性,但是多个则不行,多个可以通过 AtomicReference 来处理或者使用锁 synchronized 实现。

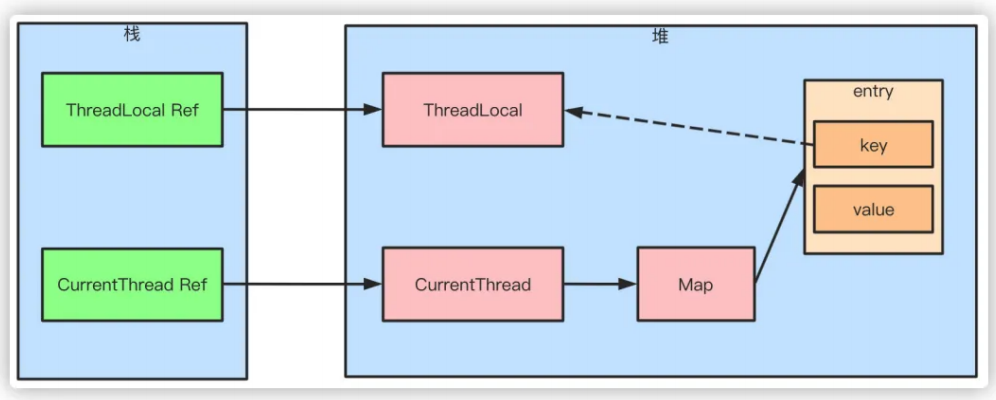

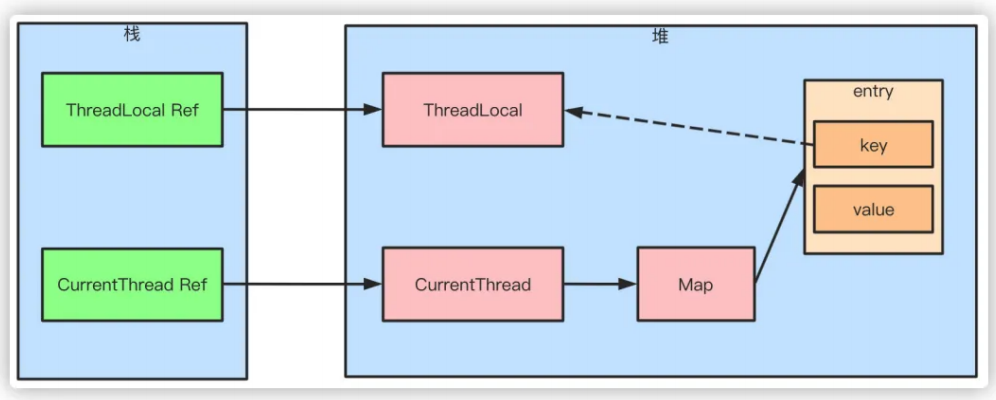

33、说说 ThreadLocal 原理?

ThreadLocal 可以理解为线程本地变量,他会在每个线程都创建一个副本,那么在线程之间访问内部副本变量就行了,做到了线程之间互相隔离,相比于 synchronized 的做法是用空间来换时间。

ThreadLocal 有一个静态内部类 ThreadLocalMap,ThreadLocalMap 又包含了一个 Entry 数组,Entry 本身是一个弱引用,它的 key 是指向 ThreadLocal 的弱引用,Entry 具备了保存 key value 键值对的能。

弱引用的目的是为了防止内存泄露,如果是强引用那么 ThreadLocal 对象除非线程结束否则始终无法被回收,弱引用则会在下一次 GC 的时候被回收。

但是这样还是会存在内存泄露的问题,假如 key 和 ThreadLocal 对象被回收之后,entry 中就存在 key 为 null,但是 value 有值的 entry对象,但是永远没办法被访问到,同样除非线程结束运行。

但是只要 ThreadLocal 使用恰当,在使用完之后调用 remove 方法删除 Entry 对象,实际上是不会出现这个问题的。

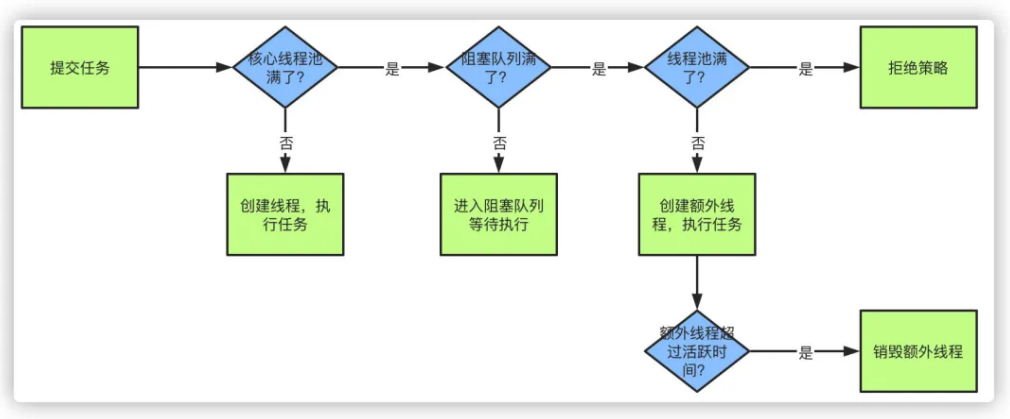

34、线程池原理知道吗?以及核心参数

首先线程池有几个核心的参数概念:

- 最大线程数 maximumPoolSize

- 核心线程数 corePoolSize

- 活跃时间 keepAliveTime

- 阻塞队列 workQueue

- 拒绝策略 RejectedExecutionHandler

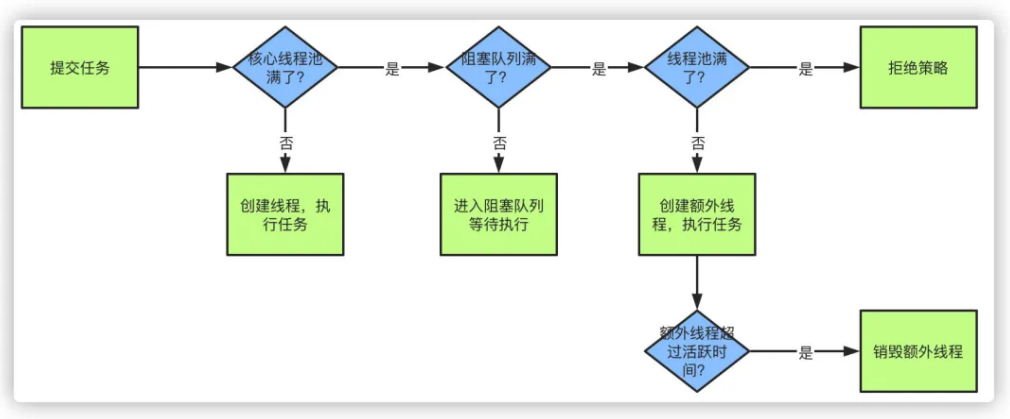

当提交一个新任务到线程池时,具体的执行流程如下:

当我们提交任务,线程池会根据 corePoolSize 大小创建若干任务数量线程执行任务

当任务的数量超过 corePoolSize 数量,后续的任务将会进入阻塞队列阻塞排队

当阻塞队列也满了之后,那么将会继续创建(maximumPoolSize-corePoolSize)个数量的线程来执行任务,如果任务处理完成,maximumPoolSize-corePoolSize 额外创建的线程等待 keepAliveTime 之后被自动销毁

如果达到 maximumPoolSize,阻塞队列还是满的状态,那么将根据不同的拒绝策略对应处理

35、 线程池的拒绝策略有哪些?

主要有 4 种拒绝策略:

- AbortPolicy:直接丢弃任务,抛出异常,这是默认策略

- CallerRunsPolicy:只用调用者所在的线程来处理任务

- DiscardOldestPolicy:丢弃等待队列中最旧的任务,并执行当前任务

- DiscardPolicy:直接丢弃任务,也不抛出异常

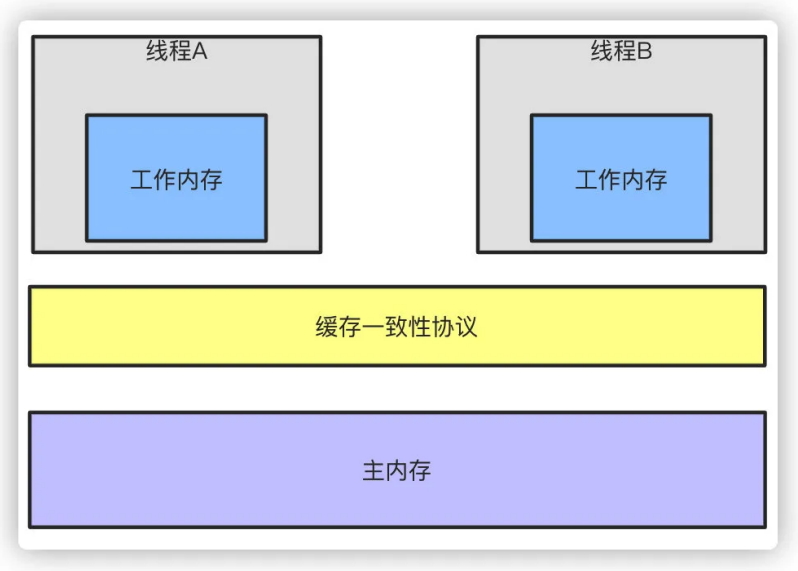

36、说说你对 JMM 内存模型的理解?为什么需要 JMM ?

随着 CPU 和内存的发展速度差异的问题,导致 CPU 的速度远快于内存,所以现在的 CPU 加入了高速缓存,高速缓存一般可以分为 L1、L2、L3 三级缓存。基于上面的例子我们知道了这导致了缓存一致性的问题,所以加入了缓存一致性协议,同时导致了内存可见性的问题,而编译器和 CPU 的重排序导致了原子性和有序性的问题,JMM 内存模型正是对多线程操作下的一系列规范约束,因为不可能让陈雇员的代码去兼容所有的 CPU,通过 JMM 我们才屏蔽了不同硬件和操作系统内存的访问差异,这样保证了 Java 程序在不同的平台下达到一致的内存访问效果,同时也是保证在高效并发的时候程序能够正确执行。

原子性:Java 内存模型通过 read、load、assign、use、store、write 来保证原子性操作,此外还有 lock 和 unlock,直接对应着synchronized 关键字的 monitorenter 和 monitorexit 字节码指令。

可见性:可见性的问题在上面的回答已经说过,Java 保证可见性可以认为通过 volatile、synchronized、final 来实现。

有序性:由于处理器和编译器的重排序导致的有序性问题,Java 通过 volatile、synchronized 来保证。

happen-before 规则

虽然指令重排提高了并发的性能,但是 Java 虚拟机会对指令重排做出一些规则限制,并不能让所有的指令都随意的改变执行位置,主要有以下几点:

- 单线程每个操作,happen-before 于该线程中任意后续操作

- volatile 写 happen-before 与后续对这个变量的读

- synchronized 解锁 happen-before 后续对这个锁的加锁

- final 变量的写 happen-before 于 final 域对象的读,happen-before 后续对 final 变量的读

- 传递性规则,A 先于 B,B 先于 C,那么 A 一定先于 C 发生

说了半天,到底工作内存和主内存是什么?

主内存可以认为就是物理内存,Java 内存模型中实际就是虚拟机内存的一部分。而工作内存就是 CPU 缓存,他有可能是寄存器也有可能是 L1 \ L2 \ L3 缓存,都是有可能的。

37、多线程有什么用?

一个可能在很多人看来很扯淡的一个问题:我会用多线程就好了,还管它有什么用?在我看来,这个回答更扯淡。所谓”知其然知其所以然”,”会用”只是”知其然”,”为什么用”才是”知其所以然”,只有达到”知其然知其所以然”的程度才可以说是把一个知识点运用自如。OK,下面说说我对这个问题的看法:

(1)发挥多核 CPU 的优势

随着工业的进步,现在的笔记本、台式机乃至商用的应用服务器至少也都是双核的,4 核、8 核甚至 16 核的也都不少见,如果是单线程的程序,那么在双核 CPU 上就浪费了 50 %,在 4 核 CPU 上就浪费了 75 %。单核 CPU 上所谓的“多线程”那是假的多线程,同一时间处理器只会处理一段逻辑,只不过线程之间切换得比较快,看着像多个线程”同时”运行罢了。多核 CPU 上的多线程才是真正的多线程,它能让你的多段逻辑同时工作,多线程,可以真正发挥出多核 CPU 的优势来,达到充分利用 CPU 的目的。

(2)防止阻塞

从程序运行效率的角度来看,单核 CPU 不但不会发挥出多线程的优势,反而会因为在单核 CPU 上运行多线程导致线程上下文的切换,而降低程序整体的效率。但是单核 CPU 我们还是要应用多线程,就是为了防止阻塞。试想,如果单核 CPU 使用单线程,那么只要这个线程阻塞了,比方说远程读取某个数据吧,对端迟迟未返回又没有设置超时时间,那么你的整个程序在数据返回回来之前就停止运行了。多线程可以防止这个问题,多条线程同时运行,哪怕一条线程的代码执行读取数据阻塞,也不会影响其它任务的执行。

(3)便于建模

这是另外一个没有这么明显的优点了。假设有一个大的任务 A,单线程编程,那么就要考虑很多,建立整个程序模型比较麻烦。但是如果把这个大的任务 A 分解成几个小任务,任务 B、任务 C、任务 D,分别建立程序模型,并通过多线程分别运行这几个任务,那就简单很多了。

38、说说 CyclicBarrier 和 CountDownLatch 的区别?

两个看上去有点像的类,都在 java.util.concurrent 下,都可以用来表示代码运行到某个点上,二者的区别在于:

(1)CyclicBarrier 的某个线程运行到某个点上之后,该线程即停止运行,直到所有的线程都到达了这个点,所有线程才重新运行;

CountDownLatch 则不是,某线程运行到某个点上之后,只是给某个数值 -1 而已,该线程继续运行

(2)CyclicBarrier 只能唤起一个任务,CountDownLatch 可以唤起多个任务

(3)CyclicBarrier 可重用,CountDownLatch 不可重用,计数值为 0 该 CountDownLatch 就不可再用了

39、什么是 AQS ?

简单说一下 AQS,AQS 全称为 AbstractQueuedSychronizer,翻译过来应该是 抽象队列同步器。如果说 java.util.concurrent 的基础是 CAS 的话,那么 AQS 就是整个 Java 并发包的核心了,ReentrantLock、CountDownLatch、Semaphore 等等都用到了它。AQS 实际上以双向队列的形式连接所有的 Entry,比方说 ReentrantLock,所有等待的线程都被放在一个 Entry 中并连成双向队列,前面一个线程使用 ReentrantLock 好了,则双向队列实际上的第一个 Entry 开始运行。

AQS 定义了对双向队列所有的操作,而只开放了 tryLock 和 tryRelease 方法给开发者使用,开发者可以根据自己的实现重写 tryLock 和tryRelease 方法,以实现自己的并发功能。

40、了解 Semaphore 吗?

Semaphore 就是一个信号量,它的作用是 限制某段代码块的并发数。Semaphore 有一个构造函数,可以传入一个 int 型整数 n,表示某段代码最多只有 n 个线程可以访问,如果超出了 n,那么请等待,等到某个线程执行完毕这段代码块,下一个线程再进入。由此可以看出如果 Semaphore 构造函数中传入的 int 型整数 n = 1,相当于变成了一个 synchronized 了。

41、什么是 Callable 和 Future?

Callable 接口类似于 Runnable,从名字就可以看出来了,但是 Runnable 不会返回结果,并且无法抛出返回结果的异常,而 Callable 功能更强大一些,被线程执行后,可以返回值,这个返回值可以被 Future 拿到,也就是说,Future 可以拿到异步执行任务的返回值。可以认为是带有回调的 Runnable。

Future 接口表示异步任务,是还没有完成的任务给出的未来结果。所以说 Callable 用于产生结果,Future 用于获取结果。

42、什么是阻塞队列?阻塞队列的实现原理是什么?如何使用阻塞队列来实现生产者 - 消费者模型?

阻塞队列(BlockingQueue)是一个支持两个附加操作的队列。

这两个附加的操作是:在队列为空时,获取元素的线程会等待队列变为非空。当队列满时,存储元素的线程会等待队列可用。

阻塞队列常用于生产者和消费者的场景,生产者是往队列里添加元素的线程,消费者是从队列里拿元素的线程。阻塞队列就是生产者存放元素的容器,而消费者也只从容器里拿元素。

JDK 7 提供了 7 个阻塞队列。分别是:

ArrayBlockingQueue :一个由数组结构组成的有界阻塞队列。

LinkedBlockingQueue :一个由链表结构组成的有界阻塞队列。

PriorityBlockingQueue :一个支持优先级排序的无界阻塞队列。

DelayQueue:一个使用优先级队列实现的无界阻塞队列。

SynchronousQueue:一个不存储元素的阻塞队列。

LinkedTransferQueue:一个由链表结构组成的无界阻塞队列。

LinkedBlockingDeque:一个由链表结构组成的双向阻塞队列。

Java 5 之前实现同步存取时,可以使用普通的一个集合,然后在使用线程的协作和线程同步可以实现生产者 - 消费者模式,主要的技术就是用好 wait,notify,notifyAll,sychronized 这些关键字。而在 java 5 之后,可以使用阻塞队列来实现,此方式大大简少了代码量,使得多线程编程更加容易,安全方面也有保障。

BlockingQueue 接口是 Queue 的子接口,它的主要用途并不是作为容器,而是作为线程同步的的工具,因此他具有一个很明显的特性,当生产者线程试图向 BlockingQueue 放入元素时,如果队列已满,则线程被阻塞,当消费者线程试图从中取出一个元素时,如果队列为空,则该线程会被阻塞,正是因为它所具有这个特性,所以在程序中多个线程交替向 BlockingQueue 中放入元素,取出元素,它可以很好的控制线程之间的通信。

阻塞队列使用最经典的场景就是 socket 客户端数据的读取和解析,读取数据的线程不断将数据放入队列,然后解析线程不断从队列取数据解析。

43、什么是多线程中的上下文切换?

在上下文切换过程中,CPU 会停止处理当前运行的程序,并保存当前程序运行的具体位置以便之后继续运行。从这个角度来看,上下文切换有点像我们同时阅读几本书,在来回切换书本的同时我们需要记住每本书当前读到的页码。

在程序中,上下文切换过程中的“页码”信息是保存在进程控制块(PCB)中的。PCB 还经常被称作“切换桢”(switchframe)。“页码”信息会一直保存到 CPU 的内存中,直到他们被再次使用。

上下文切换是存储和恢复 CPU 状态的过程,它使得线程执行能够从中断点恢复执行。上下文切换是多任务操作系统和多线程环境的基本特征。

44、什么是 Daemon 线程?它有什么意义?

所谓后台(daemon)线程,也叫守护线程,是指在程序运行的时候在后台提供一种通用服务的线程,并且这个线程并不属于程序中不可或缺的部分。

因此,当所有的非后台线程结束时,程序也就终止了,同时会杀死进程中的所有后台线程。反过来说, 只要有任何非后台线程还在运行,程序就不会终止。

必须在线程启动之前调用 setDaemon() 方法,才能把它设置为后台线程。注意:后台进程在不执行 finally 子句的情况下就会终止其 run() 方法。

比如:JVM 的垃圾回收线程就是 Daemon 线程,Finalizer 也是守护线程。

45、乐观锁和悲观锁的理解及如何实现,有哪些实现方式?

悲观锁:总是假设最坏的情况,每次去拿数据的时候都认为别人会修改,所以每次在拿数据的时候都会上锁,这样别人想拿这个数据就会阻塞直到它拿到锁。

传统的关系型数据库里边就用到了很多这种锁机制,比如行锁,表锁等,读锁,写锁等,都是在做操作之前先上锁。再比如 Java 里面的同步原语 synchronized 关键字的实现也是悲观锁。

乐观锁:顾名思义,就是很乐观,每次去拿数据的时候都认为别人不会修改,所以不会上锁,但是在更新的时候会判断一下在此期间别人有没有去更新这个数据,可以使用版本号等机制。

乐观锁适用于多读的应用类型,这样可以提高吞吐量,像数据库提供的类似于 write_condition 机制,其实都是提供的乐观锁。在 Java 中 java.util.concurrent.atomic 包下面的原子变量类就是使用了乐观锁的一种实现方式 CAS 实现的。

乐观锁的实现方式:

1、使用版本标识来确定读到的数据与提交时的数据是否一致。提交后修改版本标识,不一致时可以采取丢弃和再次尝试的策略。

2、java 中的 Compare and Swap 即 CAS,当多个线程尝试使用 CAS 同时更新同一个变量时,只有其中一个线程能更新变量的值,而其它线程都失败,失败的线程并不会被挂起,而是被告知这次竞争中失败,并可以再次尝试。 CAS 操作中包含三个操作数 —— 需要读写的内存位置(V)、进行比较的预期原值(A)和拟写入的新值(B)。如果内存位置 V 的值与预期原值 A 相匹配,那么处理器会自动将该位置值更新为新值 B。否则处理器不做任何操作。

CAS 缺点:

ABA 问题:比如说一个线程 one 从内存位置 V 中取出 A,这时候另一个线程 two 也从内存中取出 A,并且 two 进行了一些操作变成了 B,然后 two 又将 V 位置的数据变成 A,这时候线程 one 进行 CAS 操作发现内存中仍然是 A,然后 one 操作成功。尽管线程 one的 CAS 操作成功,但可能存在潜藏的问题。从 Java 1.5 开始 JDK 的 atomic 包里提供了一个类

AtomicStampedReference来解决ABA 问题。循环时间长开销大:对于资源竞争严重(线程冲突严重)的情况,CAS 自旋的概率会比较大,从而浪费更多的 CPU 资源,效率低于 synchronized。

只能保证一个共享变量的原子操作:当对一个共享变量执行操作时,我们可以使用循环 CAS 的方式来保证原子操作,但是对多个共享变量操作时,循环 CAS 就无法保证操作的原子性,这个时候就可以用锁。

46、CopyOnWriteArrayList 应用场景

1、读多写少的场景:由于在写操作时需要复制一个新的数组,因此写的性能较差。而读操作则不会影响原来的数组,所以性能很高。适合于读多写少的场景。

2、读操作优先场景:由于 CopyOnWriteArrayList 在写操作时,所有读操作都不受到影响和阻塞。因此,当对数据的读操作次数比较多时,可以使用 CopyOnWriteArrayList 来提升系统的性能。

3、数据更新要求不频繁的场景: 在 CopyOnWriteArrayList 上,每次添加、修改或删除列表中的元素时,都需要重新创建一个新的底层数组,因此在实现上会消耗更多的内存空间。如果数据经常需要被更新,则建议使用普通的 ArrayList。

4、互斥访问数据不方便的场景: 在多线程环境下,如果对一个 ArrayList 实例进行访问,需要加锁保证数据一致性。但是,在某些场景下,加锁会给程序带来额外的复杂度和延迟。在这种情况下可以考虑使用 CopyOnWriteArrayList。

5、高并发场景:CopyOnWriteArrayList 在写操作时候有很高的并发度,不会阻塞其他的读操作。因此非常适合用于读多写少的场景下,可以提高系统的并发性能。

需要注意的是,CopyOnWriteArrayList 并不能解决所有多线程问题,它主要是针对读多写少的应用场景,所以开发人员在选择使用 CopyOnWriteArrayList 时,一定要结合实际需求,如果业务场景不适合使用该类,建议使用其它的集合类,或者自己实现一些更加适用的线程安全集合类。

总之,CopyOnWriteArrayList 适合于读多写少,读优先的场景,需要更新频率较低的数据,而且有运行效率限制的场景。因为它的底层实现方式比较特殊,它的读性能非常高,而写性能相对较差。对于需要快速修改的应用场景,可以考虑使用其他的 List 类来替代 CopyOnWriteArrayList 。

47、说说线程池的常用构建方式

在Java中,可以使用ExecutorService接口来创建线程池。ExecutorService是Executor的子接口,它提供了更多的方法来管理和控制线程池的执行。

以下是几种常见的建立线程池的方式:

使用

Executors类的静态方法创建线程池:1

2

3ExecutorService executor = Executors.newFixedThreadPool(10); // 创建固定大小的线程池,最多同时执行10个任务

ExecutorService executor = Executors.newSingleThreadExecutor(); // 创建单个线程的线程池

ExecutorService executor = Executors.newCachedThreadPool(); // 创建可缓存的线程池,根据需要自动调整线程数量使用

ThreadPoolExecutor类的构造函数创建线程池:1

2

3

4

5

6

7int corePoolSize = 10; // 核心线程数

int maximumPoolSize = 20; // 最大线程数

long keepAliveTime = 60; // 线程空闲时间

TimeUnit unit = TimeUnit.SECONDS; // 空闲时间的单位

ExecutorService executor = new ThreadPoolExecutor(corePoolSize, maximumPoolSize, keepAliveTime, unit,

new LinkedBlockingQueue<>()); // 创建自定义的线程池,使用有界队列作为任务队列使用

ThreadPoolExecutor类的ThreadPoolExecutor.AbortPolicy等内置拒绝策略创建线程池:1

2

3

4

5

6

7

8

9int corePoolSize = 10; // 核心线程数

int maximumPoolSize = 20; // 最大线程数

long keepAliveTime = 60; // 线程空闲时间

TimeUnit unit = TimeUnit.SECONDS; // 空闲时间的单位

BlockingQueue<Runnable> workQueue = new LinkedBlockingQueue<>(); // 任务队列

RejectedExecutionHandler handler = new ThreadPoolExecutor.AbortPolicy(); // 拒绝策略

ExecutorService executor = new ThreadPoolExecutor(corePoolSize, maximumPoolSize, keepAliveTime, unit,

workQueue, handler); // 创建自定义的线程池,指定拒绝策略

以上是几种常见的建立线程池的方式,根据具体的需求选择适合的方式来创建线程池。

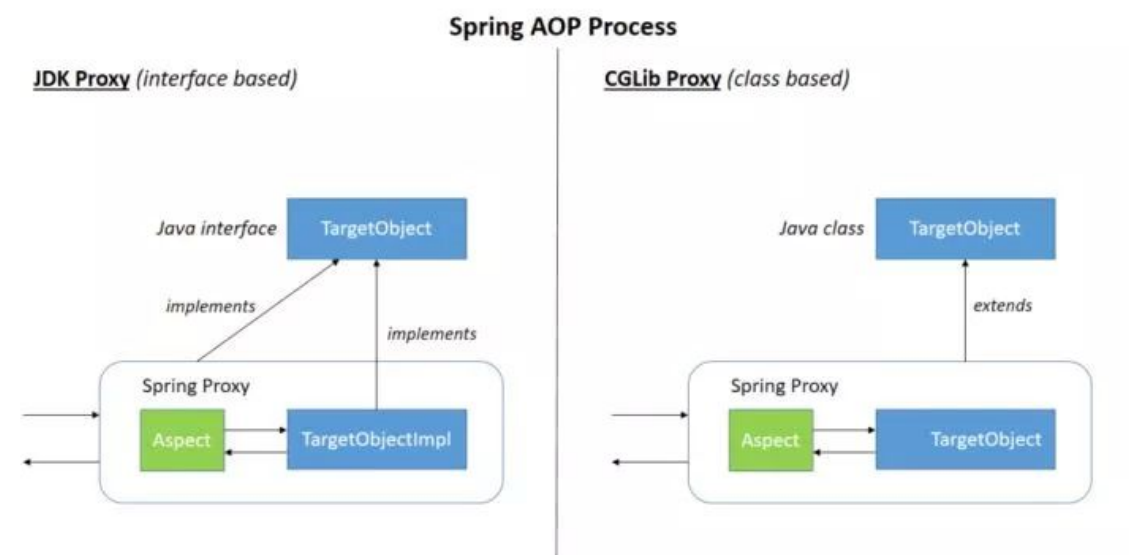

Spring 篇

1、什么是 spring?

Spring 是个 java 企业级应用的开源开发框架。Spring 主要用来开发 Java 应用,但是有些扩展是针对构建 J2EE 平台的 web 应用。Spring 框架目标是简化 Java 企业级应用开发,并通过 POJO 为基础的编程模型促进良好的编程习惯。

2、你们项目中为什么使用 Spring 框架?

这么问的话,就直接说 Spring 框架的好处就可以了。比如说 Spring 有以下特点:

轻量:Spring 是轻量的,基本的版本大约 2 MB。

控制反转:Spring 通过控制反转实现了松散耦合,对象们给出它们的依赖,而不是创建或查找依赖的对象们。

面向切面的编程 (AOP) :Spring 支持面向切面的编程,并且把应用业务逻辑和系统服务分开。

容器:Spring 包含并管理应用中对象的生命周期和配置。

MVC 框架:Spring 的 WEB 框架是个精心设计的框架,是 Web 框架的一个很好的替代品。

事务管理:Spring 提供一个持续的事务管理接口,可以扩展到上至本地事务下至全局事务(JTA)。

异常处理:Spring 提供方便的 API 把具体技术相关的异常(比如由 JDBC,Hibernate or JDO 抛出的)转化为一致的 unchecked 异常。

3、Autowired 和 Resource 关键字的区别?

@Resource 和 @Autowired 都是做 bean 的注入时使用,其实 @Resource 并不是 Spring 的注解,它的包是javax.annotation.Resource,需要导入,但是 Spring 支持该注解的注入。

1、共同点

两者都可以写在字段和 setter 方法上。两者如果都写在字段上,那么就不需要再写 setter 方法。

2、不同点

(1)@Autowired

@Autowired 为 Spring 提供的注解,需要导入包 org.springframework.beans.factory.annotation.Autowired;只按照 byType 注入。

1 | public class TestServiceImpl { |

@Autowired 注解是按照类型(byType)装配依赖对象,默认情况下它要求依赖对象必须存在,如果允许 null 值,可以设置它的required 属性为 false。如果我们想使用按照名称(byName)来装配,可以结合 @Qualifier 注解一起使用。如下:

1 | public class TestServiceImpl { |

(2)@Resource

@Resource 默认按照 ByName 自动注入,由 J2EE 提供,需要导入包 javax.annotation.Resource。

@Resource 有两个重要的属性:name 和 type,而 Spring 将 @Resource 注解的 name 属性解析为 bean 的名字,而 type 属性则解析为 bean 的类型。所以,如果使用 name 属性,则使用 byName 的自动注入策略,而使用 type 属性时则使用 byType 自动注入策略。如果既不制定 name 也不制定 type 属性,这时将通过反射机制使用 byName 自动注入策略。

1 | public class TestServiceImpl { |

注:最好是将 @Resource 放在 setter 方法上,因为这样更符合面向对象的思想,通过 set、get 去操作属性,而不是直接去操作属性。

@Resource 装配顺序:

①如果同时指定了 name 和 type,则从 Spring 上下文中找到唯一匹配的 bean 进行装配,找不到则抛出异常。

②如果指定了 name,则从上下文中查找名称(id)匹配的 bean 进行装配,找不到则抛出异常。

③如果指定了 type,则从上下文中找到类似匹配的唯一 bean 进行装配,找不到或是找到多个,都会抛出异常。

④如果既没有指定 name,又没有指定 type,则自动按照 byName 方式进行装配;如果没有匹配,则回退为一个原始类型进行匹配,如果匹配则自动装配。

@Resource 的作用相当于 @Autowired,只不过 @Autowired 按照 byType 自动注入。

4、依赖注入的方式有几种,各是什么?

1、构造器注入

将被依赖对象通过构造函数的参数注入给依赖对象,并且在初始化对象的时候注入。

优点:对象初始化完成后便可获得可使用的对象。

缺点:当需要注入的对象很多时,构造器参数列表将会很长; 不够灵活。若有多种注入方式,每种方式只需注入指定几个依赖,那么就需要提供多个重载的构造函数,麻烦。

2、setter 方法注入

IOC Service Provider 通过调用成员变量提供的 setter 函数将被依赖对象注入给依赖类。

优点:灵活。可以选择性地注入需要的对象。

缺点:依赖对象初始化完成后由于尚未注入被依赖对象,因此还不能使用。

3、接口注入

依赖类必须要实现指定的接口,然后实现该接口中的一个函数,该函数就是用于依赖注入。该函数的参数就是要注入的对象。

优点:接口注入中,接口的名字、函数的名字都不重要,只要保证函数的参数是要注入的对象类型即可。

缺点:侵入行太强,不建议使用。

PS:什么是侵入行? 如果类 A 要使用别人提供的一个功能,若为了使用这功能,需要在自己的类中增加额外的代码,这就是侵入性。

5、讲一下什么是 Spring

Spring 是一个轻量级的 IOC 和 AO P容器框架。是为 Java 应用程序提供基础性服务的一套框架,目的是用于简化企业应用程序的开发,它使得开发者只需要关心业务需求。常见的配置方式有三种:基于 XML 的配置、基于注解的配置、基于 Java 的配置。

主要由以下几个模块组成:

Spring Core:核心类库,提供 IOC 服务;

Spring Context:提供框架式的 Bean 访问方式,以及企业级功能( JNDI、定时任务等);

Spring AOP:AOP 服务;

Spring DAO:对 JDBC 的抽象,简化了数据访问异常的处理;

Spring ORM:对现有的 ORM 框架的支持;

Spring Web:提供了基本的面向 Web 的综合特性,例如多方文件上传;

Spring MVC:提供面向 Web 应用的 Model - View - Controller 实现。

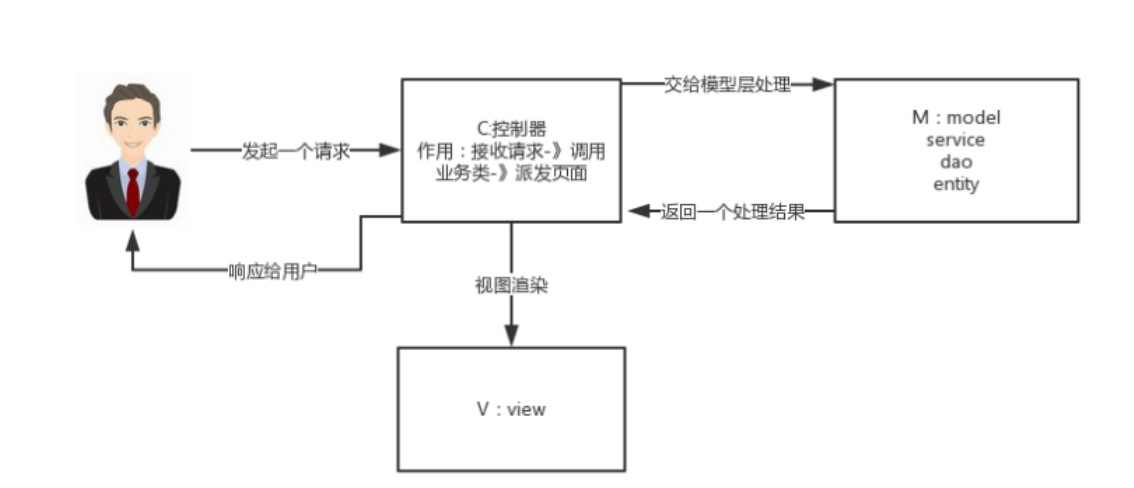

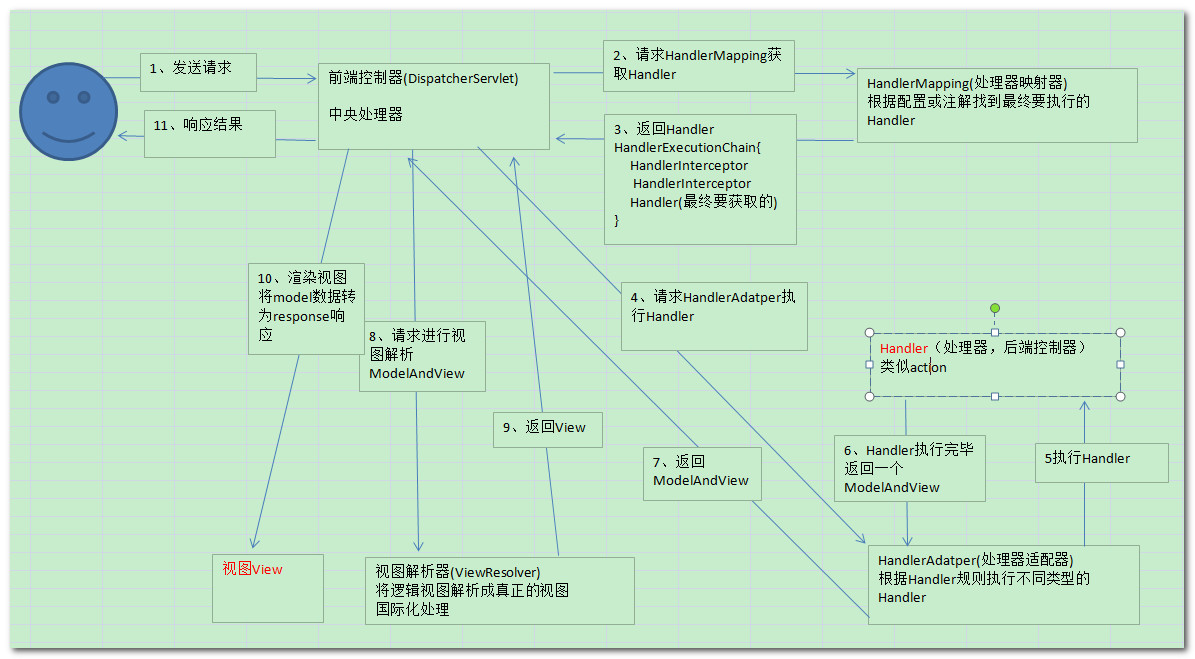

6、说说你对 Spring MVC 的理解

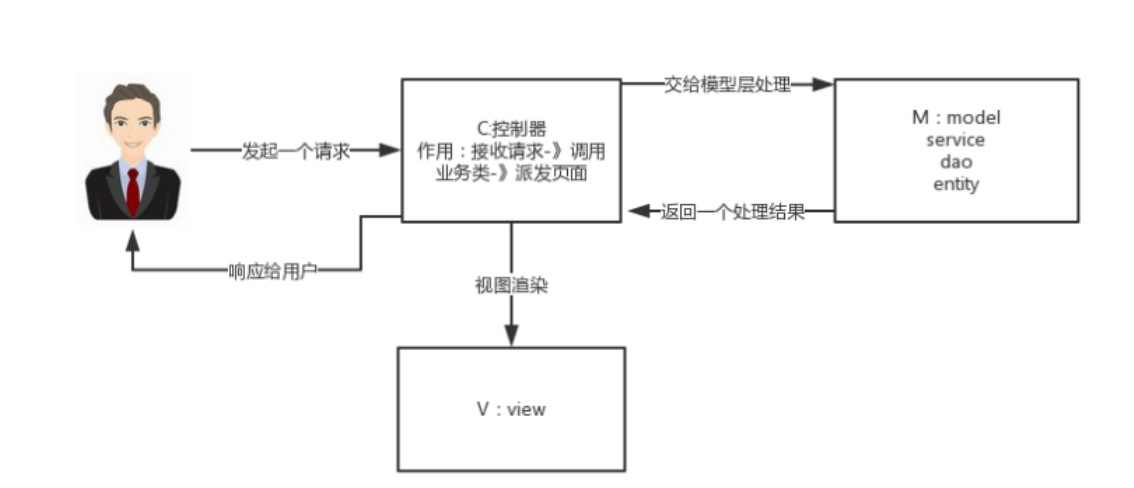

什么是 MVC 模式

MVC:MVC 是一种设计模式

MVC 的原理图:

分析:

M - Model 模型(完成业务逻辑:有 javaBean 构成,service + dao + entity)

V - View 视图(做界面的展示 jsp,html……)

C - Controller 控制器(接收请求 —> 调用模型 —> 根据结果派发页面)

SpringMVC 是一个 MVC 的开源框架,SpringMVC = struts2 + spring,SpringMVC 就相当于是 Struts2 加上 spring 的整合,但是这里有一个疑惑就是,SpringMVC 和 spring 是什么样的关系呢?这个在百度百科上有一个很好的解释:意思是说,SpringMVC 是 spring 的一个后续产品,其实就是 spring 在原有基础上,又提供了 web 应用的 MVC 模块,可以简单的把 SpringMVC 理解为是 spring 的一个模块

(类似 AOP,IOC 这样的模块),网络上经常会说 SpringMVC 和 spring 无缝集成,其实 SpringMVC 就是 spring 的一个子模块,所以根本不需要同 spring 进行整合。

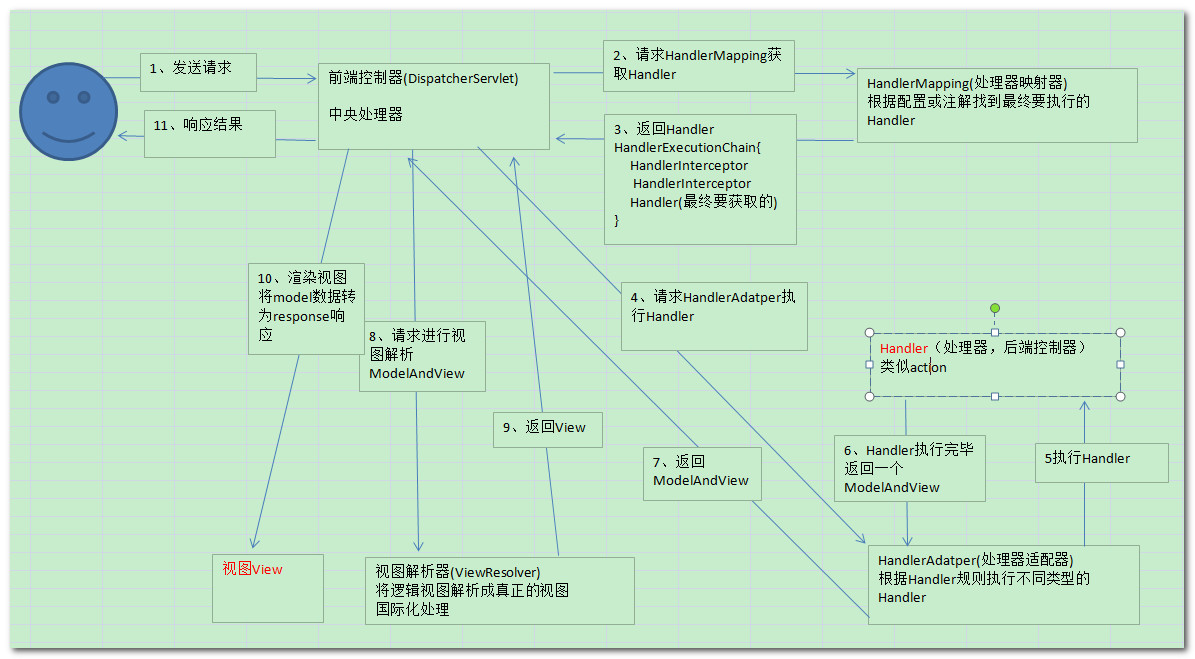

工作原理:

1、 用户发送请求至前端控制器 DispatcherServlet。

2、 DispatcherServlet 收到请求调用 HandlerMapping 处理器映射器。

3、 处理器映射器找到具体的处理器(可以根据 xml 配置、注解进行查找),生成处理器对象及处理器拦截器(如果有则生成)一并返回给 DispatcherServlet。

4、 DispatcherServlet 调用 HandlerAdapter 处理器适配器。

5、 HandlerAdapter 经过适配调用具体的处理器(Controller,也叫后端控制器)。

6、 Controller 执行完成返回 ModelAndView。

7、 HandlerAdapter 将 controller 执行结果 ModelAndView 返回给 DispatcherServlet。

8、 DispatcherServlet 将 ModelAndView 传给 ViewReslover 视图解析器。

9、 ViewReslover 解析后返回具体 View。

10、DispatcherServlet 根据 View 进行渲染视图(即将模型数据填充至视图中)。

11、 DispatcherServlet 响应用户。

组件说明 以下组件通常使用框架提供实现:

DispatcherServlet:作为前端控制器,整个流程控制的中心,控制其它组件执行,统一调度,降低组件之间的耦合性,提高每个组件的扩展性。

HandlerMapping:通过扩展处理器映射器实现不同的映射方式,例如:配置文件方式,实现接口方式,注解方式等。

HandlAdapter:通过扩展处理器适配器,支持更多类型的处理器。

ViewResolver:通过扩展视图解析器,支持更多类型的视图解析,例如:jsp、freemarker、pdf、excel 等。

组件: 1、前端控制器 DispatcherServlet(不需要工程师开发),由框架提供 作用:接收请求,响应结果,相当于转发器,中央处理器。有了 DispatcherServlet 减少了其它组件之间的耦合度。 用户请求到达前端控制器,它就相当于 mvc 模式中的 c,DispatcherServlet 是整个流程控制的中心,由它调用其它组件处理用户的请求,DispatcherServlet 的存在降低了组件之间的耦合性。

2、处理器映射器 HandlerMapping(不需要工程师开发),由框架提供 作用:根据请求的 url 查找 Handler,HandlerMapping 负责根据用户请求找到 Handler 即处理器,springmvc 提供了不同的映射器实现不同的映射方式,例如:配置文件方式,实现接口方式,注解方式等。

3、处理器适配器 HandlerAdapter 作用:按照特定规则(HandlerAdapter 要求的规则)去执行 Handler,通过 HandlerAdapter 对处理器进行执行,这是适配器模式的应用,通过扩展适配器可以对更多类型的处理器进行执行。

4、处理器 Handler(需要工程师开发)注意:编写 Handler 时按照 HandlerAdapter 的要求去做,这样适配器才可以去正确执行Handler Handler 是继 DispatcherServlet 前端控制器的后端控制器,在 DispatcherServlet 的控制下 Handler 对具体的用户请求进行处理。 由于 Handler 涉及到具体的用户业务请求,所以一般情况需要工程师根据业务需求开发 Handler。

5、视图解析器 View resolver(不需要工程师开发),由框架提供 作用:进行视图解析,根据逻辑视图名解析成真正的视图(view) View Resolver 负责将处理结果生成 View 视图,View Resolver 首先根据逻辑视图名解析成物理视图名即具体的页面地址,再生成 View视图对象,最后对 View 进行渲染将处理结果通过页面展示给用户。 springmvc 框架提供了很多的 View 视图类型,包括:jstlView、freemarkerView、pdfView 等。 一般情况下需要通过页面标签或页面模版技术将模型数据通过页面展示给用户,需要由工程师根据业务需求开发具体的页面。